What is Deepchecks?

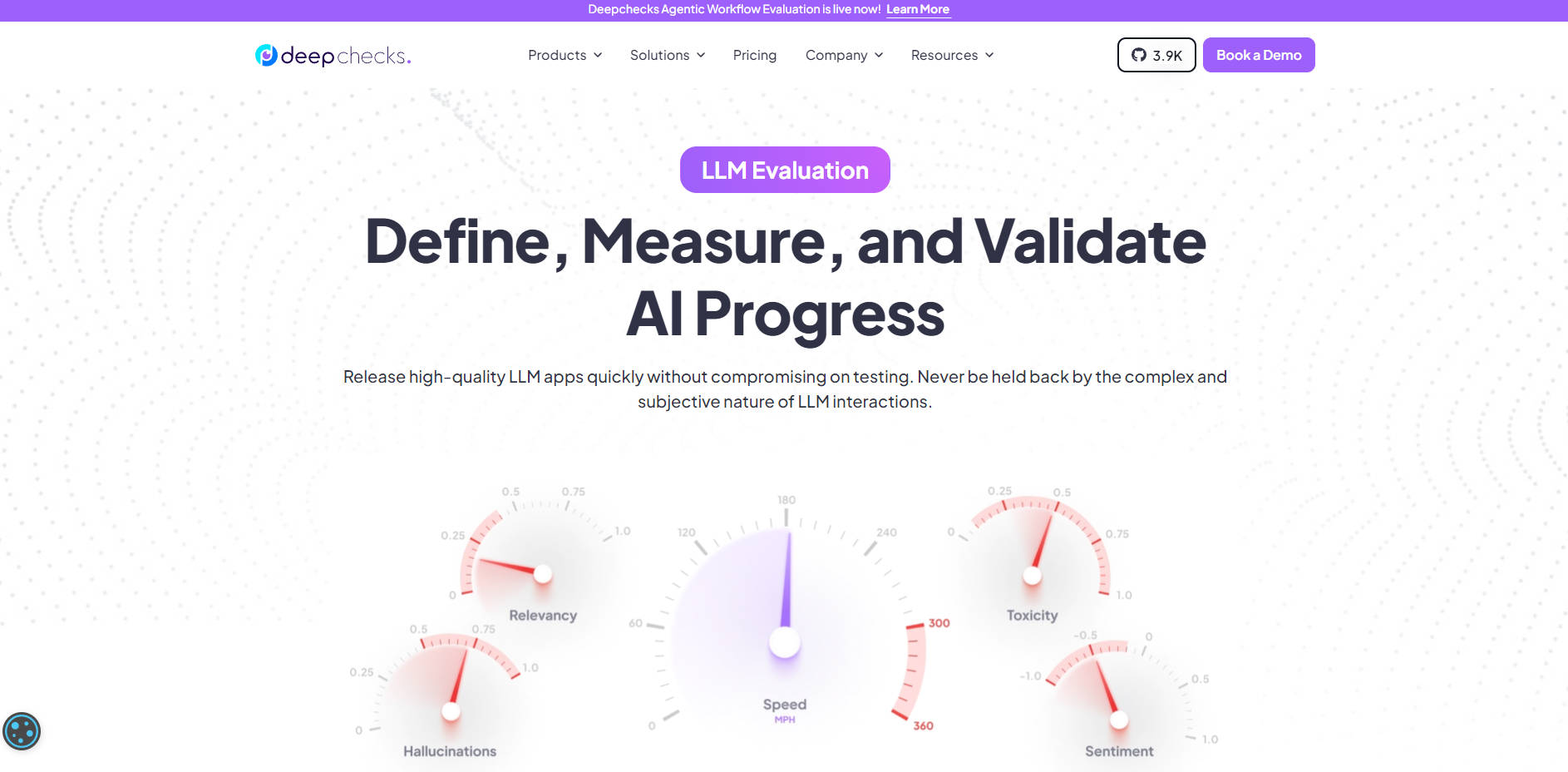

Deepchecks 提供一個專為 AI 團隊打造的完整、端到端評估平台。它直接解決了測試大型語言模型(LLM)應用程式時,複雜、主觀且通常需要人工介入的流程,讓您能更快速、更有信心地從開發階段進入生產環境。此平台將 LLM 評估從一系列臨時專案轉變為系統化、數據驅動的工作流程。

主要特色

🧪 自動評分與標註 利用精密的流程,根據細緻的約束條件,自動評分並標註您的 LLM 互動。您可透過手動覆寫來保留完全控制權,藉此建立一個「黃金標準集」或真實數據,微調自動化系統以達到卓越的準確性。

📊 全面版本比較 透過系統性地比較 LLM 技術堆疊的每個組件,做出由數據指標驅動的決策。您可以輕鬆進行實驗並驗證不同的提示詞、模型(例如 GPT-4 對比 Claude 3)、向量資料庫和檢索方法,為您的特定應用場景找到最佳配置。

🔍 全生命週期監控與除錯 超越預生產測試。Deepchecks 在生產環境中即時監控您的 LLM 應用程式,以捕捉幻覺(錯誤生成)、效能下降或有害內容。其根本原因分析工具能協助您有條理地識別應用程式最薄弱的環節,並精準定位故障發生的具體步驟。

🛡️ 彈性與安全部署 將 Deepchecks 安心整合到您現有的技術堆疊中。透過多種部署選項——從多租戶 SaaS 到 AWS GovCloud 和完全地端內部部署解決方案——您能滿足任何數據隱私或安全限制,包括 SOC2、GDPR 和 HIPAA 合規性。

使用案例

1. 優化客戶支援 RAG 代理 想像您正在開發一個 RAG(檢索增強生成)代理,用於根據您的知識庫回答客戶問題。您不再需要僅依賴經驗法則或軼事證據,而是可以使用 Deepchecks 進行數十項實驗,比較不同的嵌入模型和分塊策略。該平台提供回應相關性和事實準確性的清晰量化分數,讓您能明確選擇提供最有幫助的答案並減少幻覺的版本。

2. 確保內容生成工具的 AI 安全 您的團隊已建置一個用於生成行銷文案的工具。為防止品牌受損,您需要確保其輸出始終符合品牌調性、安全且不含有害內容。您可以將 Deepchecks 配置為在 CI/CD 管道中持續運行,自動標記任何違反您定義的安全指標的回應。在生產環境中,它會持續監控意外行為,若模型生成有問題的內容,立即向您發出警報,讓您能在影響用戶之前進行干預。

Unique Advantages

市場上有許多評估工具,但 Deepchecks 的設計獨樹一幟,旨在解決 LLM 驗證的核心挑戰。

超越 LLM-as-a-Judge: Deepchecks 不再依賴單一、通用的大型語言模型進行評估,而是採用專有的 Swarm of Evaluation Agents。這種先進架構採用一系列專業的 Small Language Models (SLMs) 和多步驟自然語言處理(NLP)管道,透過 Mixture of Experts (MoE) 技術協同運作。這種方法模擬智慧型人工標註者,提供卓越的準確性和一致性。

真正的端到端平台: 儘管許多開源專案提供評估技術,但它們通常需要大量的「動手做」努力才能成為可用的解決方案。Deepchecks 提供一個完整、整合的平台,涵蓋整個生命週期——從開發階段的測試數據生成和版本比較,到生產環境中的強大監控和除錯。

實證成果: 使用 Deepchecks 的團隊報告了實質且對業務至關重要的成果。該平台已證明能將 幻覺和低品質回應減少 70% ,並將新 LLM 應用程式的 上市時間縮短 5 倍。

結論:

Deepchecks 提供嚴謹、可擴展且系統化的框架,是建立、部署和維護高品質 LLM 應用程式所必需的。透過用自動化、數據驅動的評估取代主觀猜測,您可以更快速地創新、降低風險,並推出持續創造價值的產品。

探索 Deepchecks 如何簡化您的 LLM 開發生命週期,並確保您的應用程式如預期般運作。