What is Crawlspace?

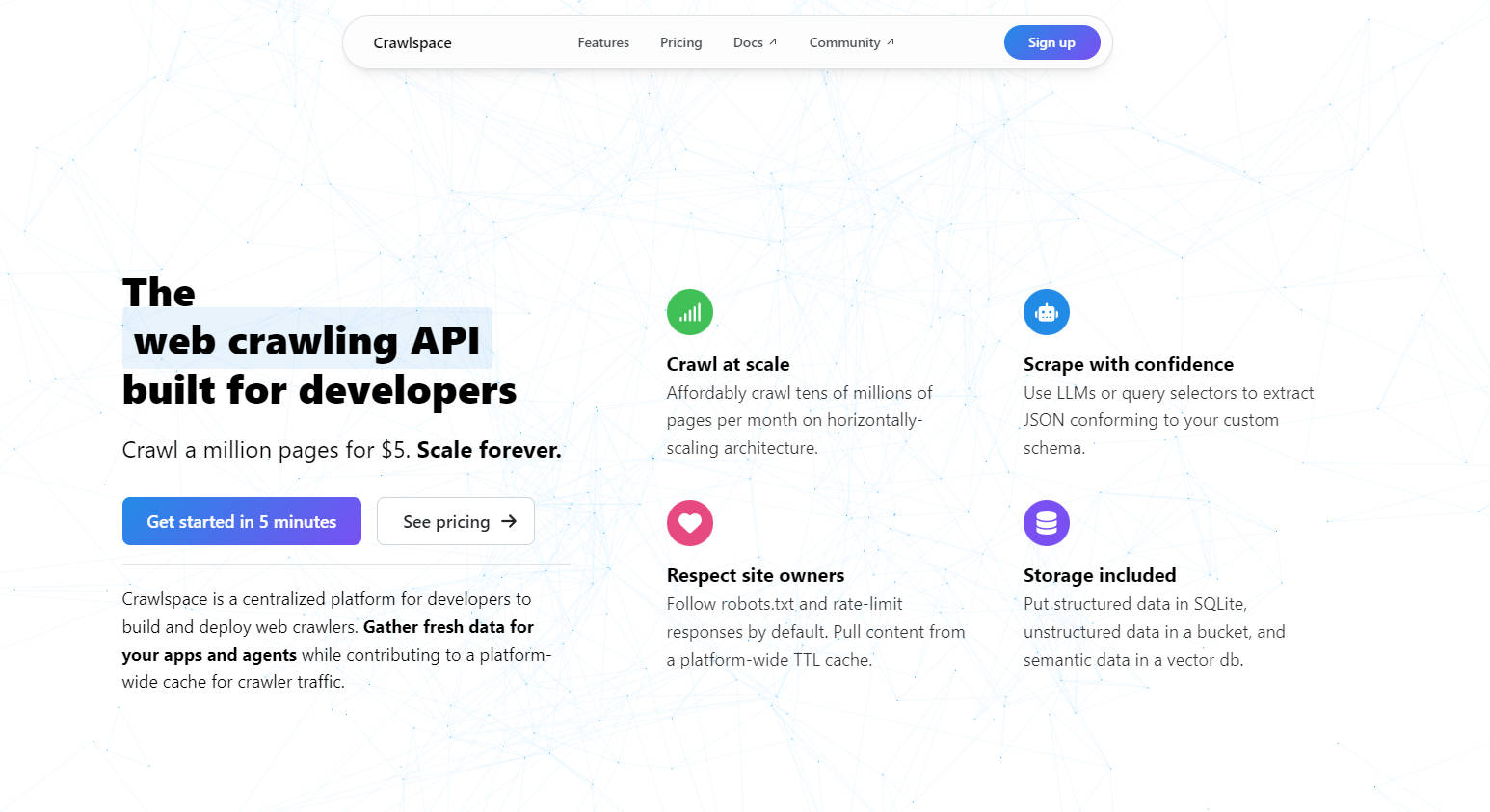

Crawlspace es una plataforma pensada para desarrolladores, diseñada para simplificar la extracción de datos y el rastreo web. Ya sea que esté creando aplicaciones, entrenando modelos de IA o recopilando información, Crawlspace le permite obtener datos estructurados y actualizados a gran escala, sin las complicaciones de gestionar la infraestructura.

Características Clave

? Rastreo a Gran Escala

Rastree de forma asequible decenas de millones de páginas al mes. Con una arquitectura de escalado horizontal, puede hacer crecer sus proyectos sin preocuparse por los cuellos de botella de rendimiento.

? Extracción Inteligente de Datos

Utilice modelos de lenguaje grandes (LLMs) o selectores de consulta para extraer datos JSON que se ajusten a su esquema personalizado. Ya sea que esté extrayendo texto, imágenes o metadatos, Crawlspace garantiza que sus datos sean limpios y utilizables.

? Rastreo Respetuoso

Sigue robots.txt y limita las respuestas por defecto. Además, aprovecha una caché TTL a nivel de plataforma para reducir el tráfico redundante y respetar a los propietarios de los sitios web.

?️ Almacenamiento Flexible

Almacene datos estructurados en SQLite, datos no estructurados en un bucket compatible con S3 y datos semánticos en una base de datos vectorial; todo incluido con su rastreador.

? Implementación sin Servidores

Implemente rastreadores web con la misma facilidad con la que implementa sitios web. Sin infraestructura que gestionar, sin servidores que mantener; solo concéntrese en la creación.

Casos de Uso

Recopilación de Datos para Entrenamiento de IA

Recopile datos estructurados y actualizados para entrenar modelos de aprendizaje automático. Utilice LLMs para extraer y formatear datos directamente en su esquema preferido.Investigación de Mercado

Supervise sitios web de la competencia, realice un seguimiento de los cambios de precios o extraiga detalles de productos a gran escala, todo ello respetando los límites de velocidad y robots.txt.Agrupación de Contenido

Cree conjuntos de datos dinámicos para agregadores de noticias, bolsas de trabajo o plataformas de investigación. Almacene datos en bases de datos SQLite o vectoriales para facilitar su recuperación y análisis.

¿Por qué elegir Crawlspace?

Rentable:Rastree un millón de páginas por solo $5.

Amigable para Desarrolladores:Prioriza TypeScript, con soporte para JavaScript y paquetes npm.

Observable:Supervise los registros de tráfico utilizando OpenTelemetry para una total transparencia.

Salida Siempre Gratuita:Descargue sus conjuntos de datos sin preocuparse por costos adicionales.

Preguntas Frecuentes

P: ¿Cómo reduce Crawlspace el tráfico redundante de bots?

R: Crawlspace utiliza una caché TTL a nivel de plataforma. Cuando varios rastreadores solicitan la misma URL dentro de un intervalo de tiempo determinado, la respuesta se extrae de la caché, lo que reduce el tráfico al servidor de origen.

P: ¿Puedo rastrear sitios web de redes sociales?

R: No. Las plataformas de redes sociales como LinkedIn y X prohíben explícitamente el rastreo en sus archivos robots.txt. Para los datos de redes sociales, considere el uso de plataformas de enriquecimiento de datos.

P: ¿Puedo usar modelos de IA de terceros como GPT-4?

R: ¡Sí! Coloque sus tokens de API en el archivo .env de su rastreador y utilice modelos de proveedores como OpenAI o Anthropic para raspado e incrustación.

P: ¿Es Crawlspace compatible con las políticas de los sitios web?

R: Absolutamente. Crawlspace respeta robots.txt y la limitación de velocidad de forma predeterminada, asegurando que sus rastreadores sean educados y cumplan con las normas.

Construya con más Inteligencia, Rastree Mejor

Crawlspace es más que una plataforma de rastreo web; es la base de su próxima idea innovadora. Con precios asequibles, herramientas fáciles de usar para desarrolladores y un compromiso con el rastreo respetuoso, es la solución definitiva para escalar sus esfuerzos de recopilación de datos.

¿Listo para comenzar? Implemente su primer rastreador hoy mismo y experimente el futuro del rastreo web.