What is LlamaEdge?

Imagina tener la capacidad de ejecutar y optimizar modelos de lenguaje grandes (LLM) directamente en tu dispositivo, sin la nube, sin complicaciones y sin sacrificar el rendimiento. Eso es exactamente lo que ofrece LlamaEdge. Tanto si eres un desarrollador que crea aplicaciones impulsadas por la IA como si eres una empresa que busca implementar LLM privados y personalizados, LlamaEdge es la solución ligera, rápida y portátil que estabas esperando.

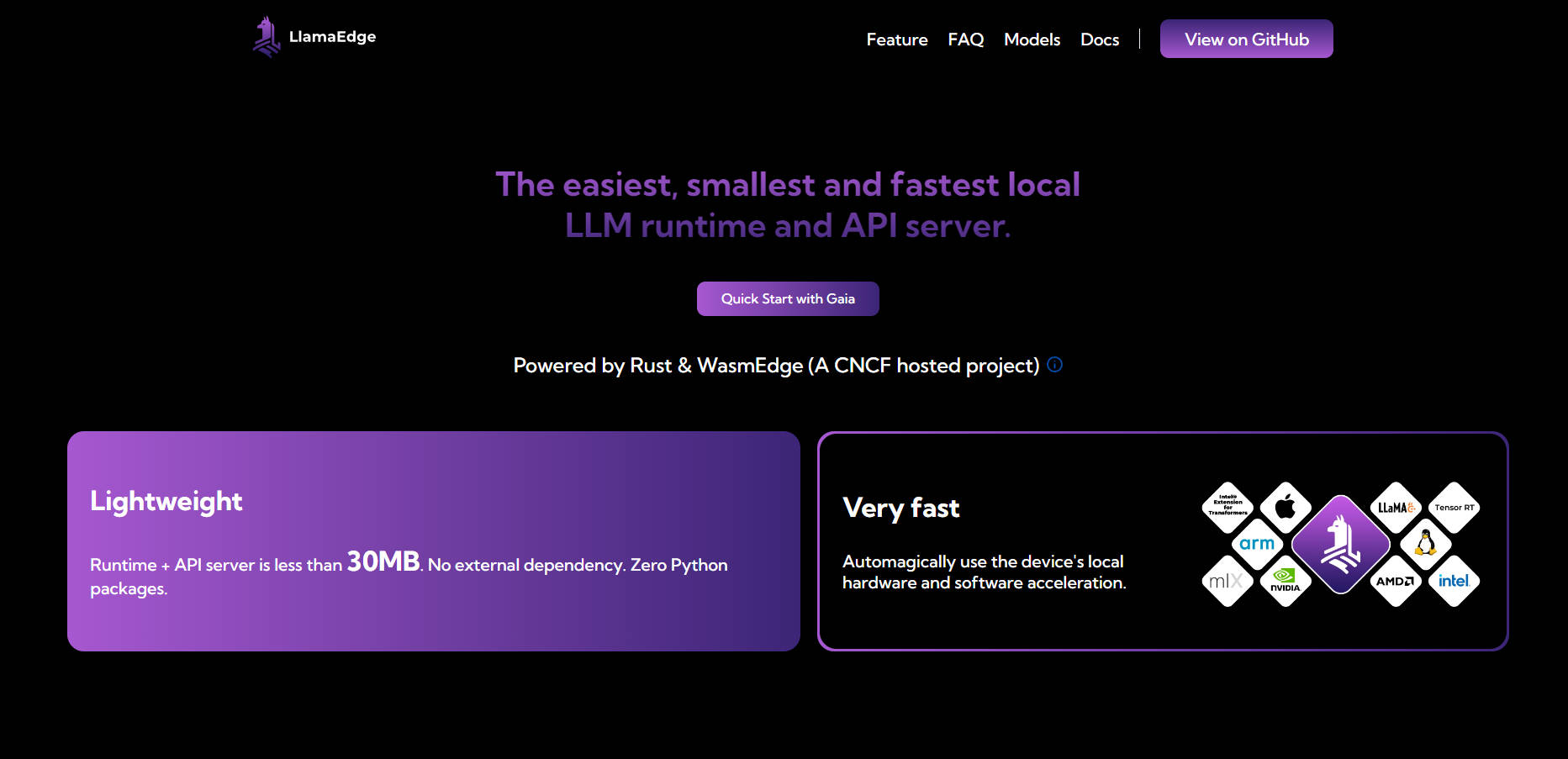

Con un tiempo de ejecución de menos de 30 MB y cero dependencias, LlamaEdge está diseñado para simplificar el proceso de ejecutar LLM localmente o en el borde. Está construido para aprovechar al máximo el hardware de tu dispositivo, garantizando velocidades nativas y una implementación multiplataforma perfecta.

Características principales

💡 Ejecuta LLM localmente o en el borde

Implementa y optimiza LLM directamente en tu dispositivo, garantizando la privacidad de los datos y eliminando la dependencia de costosos servicios en la nube.

🌐 Compatibilidad multiplataforma

Escribe tu código una vez e impleméntalo en cualquier lugar, ya sea en un MacBook, una GPU NVIDIA o un dispositivo en el borde. No es necesario reconstruir ni volver a probar para diferentes plataformas.

⚡ Ligero y rápido

Con un tiempo de ejecución inferior a 30 MB y sin dependencias externas, LlamaEdge es increíblemente ligero. Aprovecha automáticamente la aceleración de hardware de tu dispositivo para un rendimiento óptimo.

🛠️ Diseño modular para la personalización

Ensambla tus agentes y aplicaciones LLM como bloques de Lego utilizando Rust o JavaScript. Crea binarios compactos y autónomos que se ejecuten sin problemas en todos los dispositivos.

🔒 Privacidad y seguridad mejoradas

Mantén tus datos locales y seguros. LlamaEdge se ejecuta en un entorno de pruebas aislado, no requiere permisos de root y garantiza que tus interacciones permanezcan privadas.

Casos de uso

Creación de asistentes de IA privados

Crea chatbots o asistentes virtuales impulsados por la IA que se ejecuten completamente en tu dispositivo, protegiendo los datos confidenciales al tiempo que ofrecen interacciones rápidas y receptivas.Desarrollo de aplicaciones LLM personalizadas

Optimiza los LLM para industrias o casos de uso específicos, ya sea el análisis de documentos legales, la atención al cliente o el diagnóstico sanitario, sin necesidad de soluciones basadas en la nube.Implementación de la IA en dispositivos en el borde

Lleva las capacidades de la IA a dispositivos en el borde, como sensores de IoT o aplicaciones móviles, lo que permite la toma de decisiones en tiempo real sin problemas de latencia o conectividad.

¿Por qué elegir LlamaEdge?

Rentable: Evita los altos costes de las API de LLM alojadas y la complejidad de la gestión de la infraestructura en la nube.

Personalizable: Adapta los LLM a tus necesidades específicas sin las limitaciones de los modelos de propósito general.

Portátil: Implementa tus aplicaciones en diferentes plataformas y dispositivos con un solo archivo binario.

Preparado para el futuro: Mantente a la vanguardia con el soporte para modelos multimodales, tiempos de ejecución alternativos y tecnologías de IA emergentes.

Preguntas frecuentes

P: ¿Cómo se compara LlamaEdge con las soluciones basadas en Python?

R: Las soluciones basadas en Python como PyTorch vienen con grandes dependencias y son más lentas para la inferencia a nivel de producción. LlamaEdge, por otro lado, es ligero (menos de 30 MB), más rápido y libre de conflictos de dependencias.

P: ¿Es LlamaEdge compatible con las GPU y los aceleradores de hardware?

R: Absolutamente. LlamaEdge aprovecha automáticamente la aceleración de hardware de tu dispositivo, garantizando velocidades nativas en CPU, GPU y NPU.

P: ¿Puedo usar LlamaEdge con los modelos de código abierto existentes?

R: Sí. LlamaEdge admite una amplia gama de modelos de IA/LLM, incluyendo toda la serie Llama2, y te permite optimizarlos para tus necesidades específicas.

P: ¿Qué hace que LlamaEdge sea más seguro que otras soluciones?

R: LlamaEdge se ejecuta en un entorno de pruebas aislado, no requiere permisos de root y garantiza que tus datos nunca salgan de tu dispositivo, lo que lo convierte en una opción más segura para las aplicaciones sensibles.

¿Listo para empezar?

Con LlamaEdge, ejecutar y optimizar los LLM localmente nunca ha sido tan fácil. Tanto si estás creando aplicaciones impulsadas por la IA como si estás implementando modelos en dispositivos en el borde, LlamaEdge te permite hacer más, con menos. Instálalo hoy mismo y experimenta el futuro de la implementación local de LLM.

More information on LlamaEdge

Top 5 Countries

Traffic Sources

LlamaEdge Alternativas

Más Alternativas-

LM Studio es una aplicación de escritorio fácil de usar para experimentar con Modelos de Lenguaje Grandes (LLMs) locales y de código abierto. La aplicación de escritorio multiplataforma LM Studio permite descargar y ejecutar cualquier modelo compatible con ggml de Hugging Face, y proporciona una interfaz de usuario (UI) sencilla pero potente para la configuración e inferencia de modelos. La aplicación aprovecha tu GPU cuando es posible.

-

-

-

-