What is LlamaEdge?

클라우드 없이, 복잡함 없이, 성능 저하 없이, 대규모 언어 모델(LLM)을 직접 기기에서 실행하고 미세 조정할 수 있는 능력을 상상해 보세요. 바로 이것이 LlamaEdge가 제공하는 기능입니다. AI 기반 애플리케이션을 구축하는 개발자든, 개인화된 LLM을 배포하려는 기업이든, LlamaEdge는 여러분이 기다려온 가볍고 빠르며 휴대성이 뛰어난 솔루션입니다.

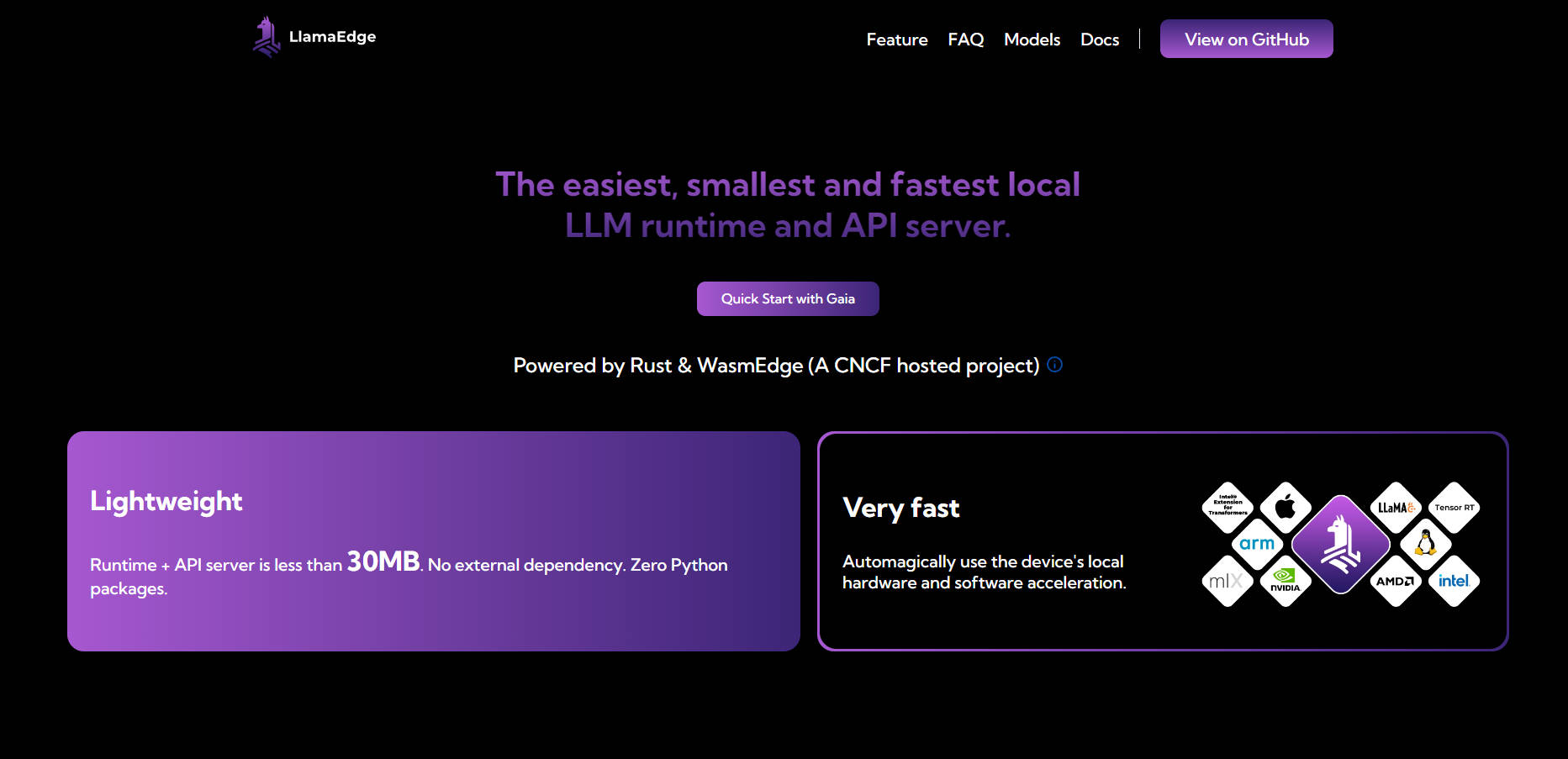

30MB 미만의 런타임과 종속성 없는 LlamaEdge는 LLM을 로컬 또는 엣지에서 실행하는 프로세스를 간소화하도록 설계되었습니다. 장치의 하드웨어를 최대한 활용하여 기본 속도와 원활한 플랫폼 간 배포를 보장합니다.

주요 기능

💡 LLM을 로컬 또는 엣지에서 실행

LLM을 장치에서 직접 배포하고 미세 조정하여 데이터 개인 정보를 보호하고 비용이 많이 드는 클라우드 서비스에 대한 의존도를 줄입니다.

🌐 플랫폼 간 호환성

MacBook, NVIDIA GPU 또는 엣지 장치 등 어디에서든 코드를 한 번 작성하여 배포할 수 있습니다. 다른 플랫폼에 대해 다시 빌드하거나 다시 테스트할 필요가 없습니다.

⚡ 가볍고 빠름

30MB 미만의 런타임과 외부 종속성이 없는 LlamaEdge는 매우 가볍습니다. 장치의 하드웨어 가속을 자동으로 활용하여 최적의 성능을 제공합니다.

🛠️ 사용자 정의를 위한 모듈식 설계

Rust 또는 JavaScript를 사용하여 레고 블록처럼 LLM 에이전트 및 애플리케이션을 조립합니다. 장치에서 원활하게 실행되는 작고 독립적인 바이너리를 만듭니다.

🔒 향상된 개인 정보 보호 및 보안

데이터를 로컬에 안전하게 보관하십시오. LlamaEdge는 샌드박스 환경에서 실행되고 루트 권한이 필요 없으며 상호 작용이 비공개로 유지되도록 합니다.

사용 사례

개인 AI 어시스턴트 구축

빠르고 응답성이 뛰어난 상호 작용을 제공하면서 민감한 데이터를 보호하는 AI 기반 챗봇 또는 가상 어시스턴트를 장치에서 완전히 실행합니다.맞춤형 LLM 앱 개발

클라우드 기반 솔루션 없이 법률 문서 분석, 고객 지원 또는 의료 진단 등 특정 산업 또는 사용 사례에 맞게 LLM을 미세 조정합니다.엣지 장치에 AI 배포

IoT 센서 또는 모바일 앱과 같은 엣지 장치에 AI 기능을 제공하여 지연 시간 또는 연결 문제 없이 실시간 의사 결정을 가능하게 합니다.

LlamaEdge를 선택해야 하는 이유

비용 효율적: 호스팅된 LLM API의 높은 비용과 클라우드 인프라 관리의 복잡성을 피하십시오.

사용자 정의 가능: 범용 모델의 제한 없이 특정 요구 사항에 맞게 LLM을 조정하십시오.

휴대성: 단일 바이너리 파일로 여러 플랫폼 및 장치에 애플리케이션을 배포하십시오.

미래 보장: 멀티모달 모델, 대체 런타임 및 새로운 AI 기술에 대한 지원으로 앞서 나가십시오.

FAQ

Q: LlamaEdge는 Python 기반 솔루션과 어떻게 비교됩니까?

A: PyTorch와 같은 Python 기반 솔루션은 큰 종속성과 함께 제공되며 프로덕션 수준 추론에 더 느립니다. 반면에 LlamaEdge는 가볍고(30MB 미만) 더 빠르며 종속성 충돌이 없습니다.

Q: LlamaEdge는 GPU 및 하드웨어 가속기와 호환됩니까?

A: 물론입니다. LlamaEdge는 장치의 하드웨어 가속을 자동으로 활용하여 CPU, GPU 및 NPU에서 기본 속도를 보장합니다.

Q: 기존 오픈 소스 모델과 함께 LlamaEdge를 사용할 수 있습니까?

A: 예. LlamaEdge는 전체 Llama2 시리즈를 포함한 광범위한 AI/LLM 모델을 지원하며 특정 요구 사항에 맞게 미세 조정할 수 있습니다.

Q: LlamaEdge가 다른 솔루션보다 더 안전한 이유는 무엇입니까?

A: LlamaEdge는 샌드박스 환경에서 실행되고 루트 권한이 필요 없으며 데이터가 장치를 벗어나지 않도록 하여 민감한 애플리케이션에 더 안전한 선택입니다.

시작할 준비가 되셨습니까?

LlamaEdge를 사용하면 LLM을 로컬에서 실행하고 미세 조정하는 것이 그 어느 때보다 쉬워졌습니다. AI 기반 애플리케이션을 구축하든 엣지 장치에 모델을 배포하든 LlamaEdge를 사용하면 더 적은 것으로 더 많은 것을 할 수 있습니다. 오늘 설치하고 로컬 LLM 배포의 미래를 경험하십시오.