What is LlamaEdge?

クラウドも、複雑さも、パフォーマンスの妥協もなしに、大規模言語モデル(LLM)を直接デバイス上で実行し、微調整できる力を手に入れることを想像してみてください。まさにそれを実現するのがLlamaEdgeです。AIを活用したアプリケーションを構築する開発者であれ、プライベートでカスタマイズされたLLMの展開を検討している企業であれ、LlamaEdgeは、あなたが待ち望んでいた軽量で高速、かつ移植可能なソリューションです。

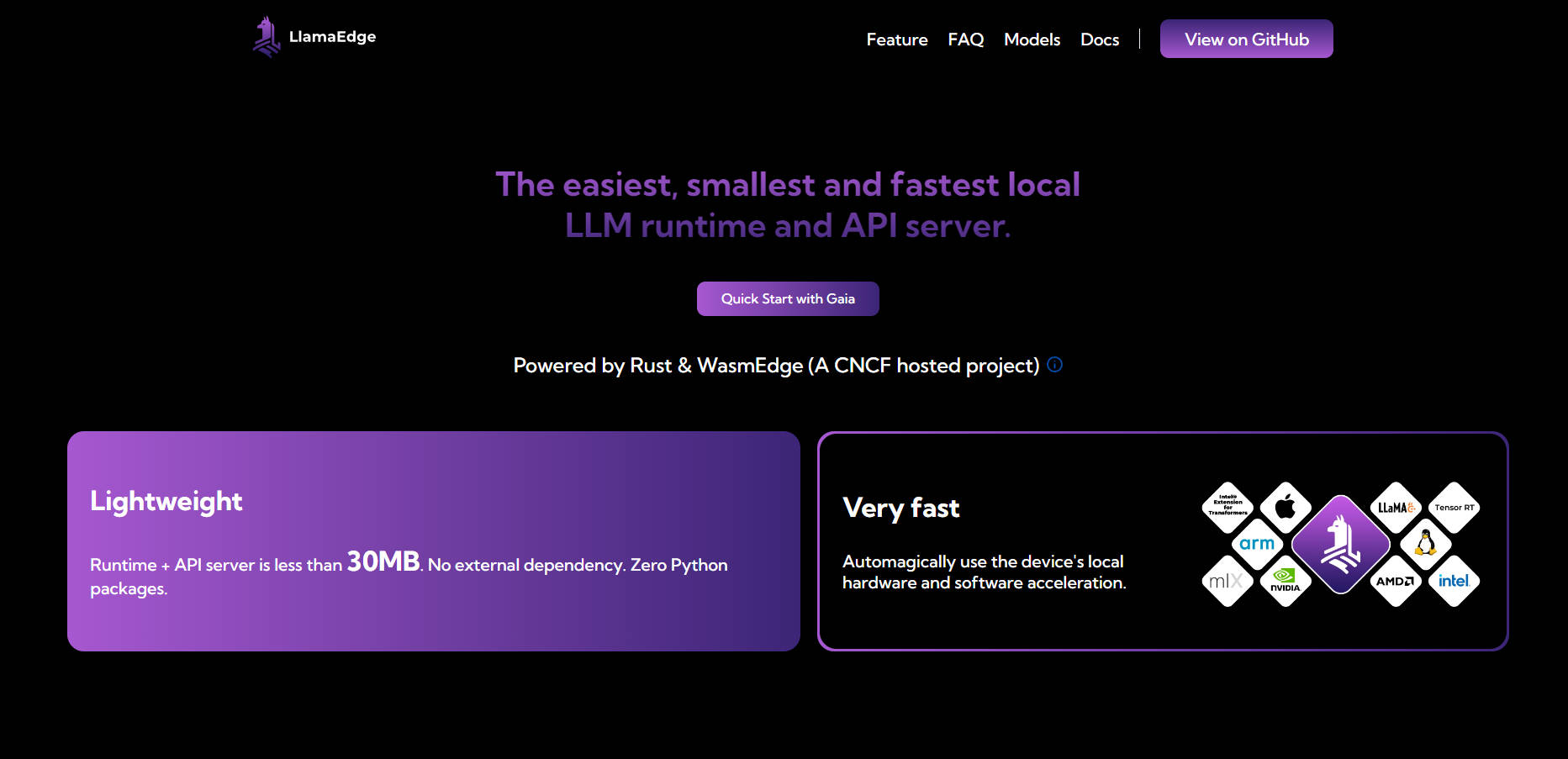

30MB未満のランタイムと依存関係ゼロで、LlamaEdgeはLLMをローカルまたはエッジで実行するプロセスを簡素化するように設計されています。デバイスのハードウェアを最大限に活用するように構築されており、ネイティブの速度とシームレスなクロスプラットフォーム展開を保証します。

主な機能

💡 LLMをローカルまたはエッジで実行

LLMをデバイス上で直接展開および微調整することで、データプライバシーを確保し、コストのかかるクラウドサービスへの依存を排除します。

🌐 クロスプラットフォーム互換性

一度コードを書けば、MacBook、NVIDIA GPU、エッジデバイスなど、どこにでも展開できます。異なるプラットフォーム用に再構築または再テストする必要はありません。

⚡ 軽量かつ高速

30MB未満のランタイムと外部依存関係がないため、LlamaEdgeは非常に軽量です。デバイスのハードウェアアクセラレーションを自動的に活用し、最適なパフォーマンスを実現します。

🛠️ カスタマイズ可能なモジュール設計

RustまたはJavaScriptを使用して、レゴブロックのようにLLMエージェントとアプリケーションを組み立てます。デバイス間でシームレスに実行されるコンパクトで自己完結型のバイナリを作成します。

🔒 強化されたプライバシーとセキュリティ

データをローカルで安全に保ちます。LlamaEdgeはサンドボックス化された環境で実行され、ルート権限を必要とせず、インタラクションのプライバシーを確保します。

ユースケース

プライベートAIアシスタントの構築

デバイス上で完全に実行されるAI搭載のチャットボットまたは仮想アシスタントを作成し、機密データを保護しながら、高速で応答性の高いインタラクションを提供します。カスタマイズされたLLMアプリの開発

クラウドベースのソリューションを必要とせずに、特定の業界またはユースケース(法的文書の分析、顧客サポート、またはヘルスケア診断など)に合わせてLLMを微調整します。エッジデバイスへのAIの展開

IoTセンサーやモバイルアプリなどのエッジデバイスにAI機能をもたらし、遅延や接続性の問題なしにリアルタイムの意思決定を可能にします。

LlamaEdgeを選ぶ理由

費用対効果: ホストされたLLM APIの高いコストと、クラウドインフラストラクチャの管理の複雑さを回避します。

カスタマイズ可能: 汎用モデルの制限なしに、LLMを特定のニーズに合わせて調整します。

移植可能: 単一のバイナリファイルで、異なるプラットフォームおよびデバイス全体にアプリケーションを展開します。

将来を見据えた設計: マルチモーダルモデル、代替ランタイム、および新しいAIテクノロジーのサポートにより、常に最先端を維持します。

FAQ

Q:LlamaEdgeはPythonベースのソリューションと比べてどうですか?

A:PyTorchなどのPythonベースのソリューションには、大きな依存関係が伴い、本番レベルの推論では遅くなります。一方、LlamaEdgeは軽量(30MB未満)で高速であり、依存関係の競合がありません。

Q:LlamaEdgeはGPUおよびハードウェアアクセラレータと互換性がありますか?

A:もちろんです。LlamaEdgeはデバイスのハードウェアアクセラレーションを自動的に活用し、CPU、GPU、およびNPUでネイティブの速度を保証します。

Q:LlamaEdgeを既存のオープンソースモデルで使用できますか?

A:はい。LlamaEdgeは、Llama2シリーズ全体を含む幅広いAI/LLMモデルをサポートしており、特定のニーズに合わせて微調整できます。

Q:LlamaEdgeが他のソリューションよりも安全なのはなぜですか?

A:LlamaEdgeはサンドボックス化された環境で実行され、ルート権限を必要とせず、データがデバイスから離れることがないため、機密性の高いアプリケーションにとってより安全な選択肢となります。

始める準備はできましたか?

LlamaEdgeを使用すると、LLMのローカルでの実行と微調整がこれまでになく簡単になります。AIを活用したアプリケーションを構築する場合でも、エッジデバイスにモデルを展開する場合でも、LlamaEdgeを使用すると、より少ない労力でより多くのことを実行できます。今すぐインストールして、ローカルLLM展開の未来を体験してください。