What is Ludwig?

Construir, entrenar e implementar modelos de IA personalizados, como Large Language Models (LLMs) o redes neuronales especializadas, a menudo requiere navegar por bases de código complejas y gestionar infraestructuras intrincadas. Ludwig ofrece un camino diferente. Es un framework declarativo de bajo código que agiliza todo el proceso, permitiéndote concentrarte en el modelado en sí, en lugar de atascarte en complejidades de ingeniería. Ya sea que estés ajustando un LLM existente o diseñando una arquitectura multimodal única desde cero, Ludwig proporciona las herramientas para construir modelos sofisticados con notable facilidad.

Características clave

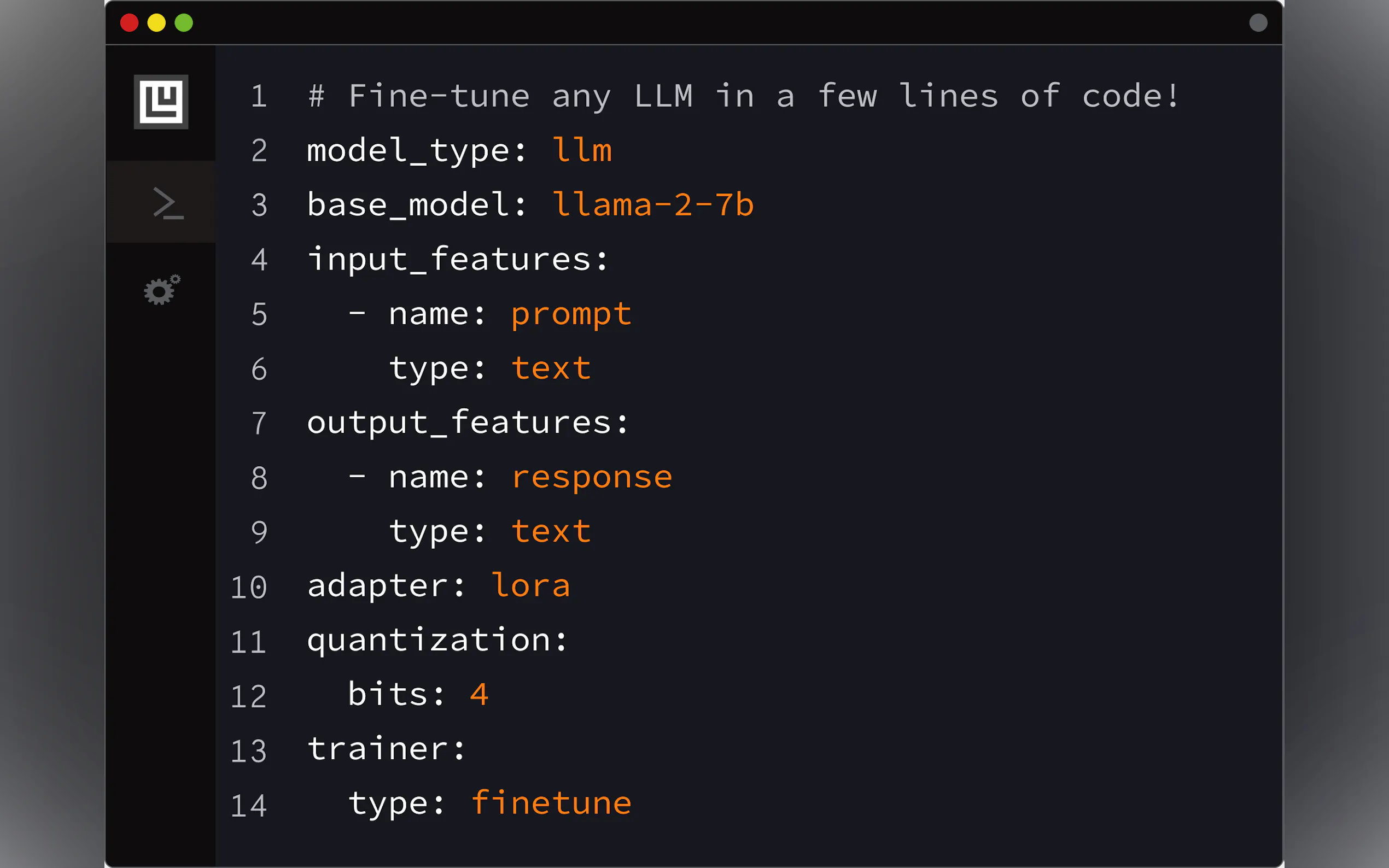

🛠️ Construye modelos personalizados mediante configuración: Define la arquitectura completa de tu modelo, las características y el proceso de entrenamiento utilizando un archivo YAML simple y declarativo. Ludwig gestiona la generación de código subyacente, admitiendo el aprendizaje multitarea y multimodal sin problemas. Sus completas comprobaciones de validación detectan errores antes del tiempo de ejecución.

⚡ Optimizado para la escala y la eficiencia: Entrena modelos grandes de forma efectiva. Ludwig incorpora el ajuste automático del tamaño de lote, el entrenamiento distribuido (DDP, DeepSpeed), métodos de Parameter Efficient Fine-Tuning (PEFT) como LoRA y QLoRA (cuantificación de 4 bits), optimizadores paginados y soporte para conjuntos de datos más grandes que la memoria a través de la integración de Ray.

📐 Conserva el control a nivel de experto: El bajo código no significa bajo control. Puedes especificar todo hasta las funciones de activación. Ludwig integra herramientas de optimización de hiperparámetros (HPO), proporciona métodos de explicabilidad (importancia de las características, contrafactuales) y genera visualizaciones enriquecidas para evaluar las métricas del modelo.

🧱 Experimenta rápidamente con la modularidad: Piensa en Ludwig como bloques de construcción de aprendizaje profundo. Su diseño modular te permite intercambiar codificadores, combinadores y decodificadores, experimentar con diferentes tareas, características o modalidades haciendo pequeños cambios en tu archivo de configuración, lo que facilita la iteración rápida.

🚢 Diseñado para la producción: Pasa de la experimentación a la implementación sin problemas. Ludwig ofrece contenedores Docker preconstruidos, soporte nativo para Ray en Kubernetes y te permite exportar modelos a formatos estándar como Torchscript y Triton Inference Server. Incluso puedes cargar modelos entrenados directamente a HuggingFace Hub con un solo comando.

Casos de uso: Poniendo a Ludwig en práctica

Ajuste fino de un LLM para tareas específicas: Imagina que necesitas un chatbot adaptado a la documentación interna de tu empresa. Usando Ludwig, puedes tomar un modelo pre-entrenado como Llama-2 o Mistral-7b, definir una configuración YAML simple que especifique tus datos (pares instrucción/respuesta), configurar la cuantificación de 4 bits (QLoRA) para la eficiencia y lanzar el proceso de ajuste fino con un solo comando (

ludwig train). Esto te permite crear un LLM especializado que sigue instrucciones en GPUs de grado consumidor (como una Nvidia T4) sin escribir un código de entrenamiento extenso.Construcción de un clasificador multimodal: Supón que deseas predecir el éxito de la recomendación de productos en función de las reseñas de texto, la categoría del producto (conjunto), la calificación del contenido (categoría), el tiempo de ejecución (número) y el estado del crítico (binario). Con Ludwig, defines cada uno de estos diversos tipos de entrada en tu configuración YAML, especificas sus respectivos tipos (

text,set,category,number,binary), eliges los codificadores apropiados (por ejemplo,embedpara texto) y defines la característica de salida binaria (recommended). Ludwig construye automáticamente la arquitectura de red adecuada para manejar estos tipos de datos mixtos y entrena el clasificador.Prototipado e implementación rápidos: Tienes un conjunto de datos y necesitas construir e implementar rápidamente un modelo de clasificación. Utilizando la función AutoML de Ludwig (

ludwig.automl.auto_train), simplemente puedes proporcionar el conjunto de datos, la variable objetivo y un límite de tiempo. Ludwig explora diferentes configuraciones de modelo e hiperparámetros para encontrar un modelo de alto rendimiento. Una vez entrenado, puedes lanzar inmediatamente una API REST para tu modelo utilizandoludwig serve, haciéndolo disponible instantáneamente para las predicciones.

Conclusión

Ludwig reduce significativamente la barrera de entrada para la construcción de modelos de IA personalizados y sofisticados. Al reemplazar el código boilerplate complejo con un sistema de configuración declarativo, acelera la experimentación y el desarrollo. Sus optimizaciones incorporadas aseguran que puedas entrenar eficientemente a escala, mientras que sus características listas para la producción simplifican la implementación. Si estás buscando ajustar LLMs, construir sistemas multimodales o simplemente iterar más rápido en tus proyectos de aprendizaje profundo, Ludwig proporciona un framework potente y accesible.

More information on Ludwig

Top 5 Countries

Traffic Sources

Ludwig Alternativas

Más Alternativas-

-

LM Studio es una aplicación de escritorio fácil de usar para experimentar con Modelos de Lenguaje Grandes (LLMs) locales y de código abierto. La aplicación de escritorio multiplataforma LM Studio permite descargar y ejecutar cualquier modelo compatible con ggml de Hugging Face, y proporciona una interfaz de usuario (UI) sencilla pero potente para la configuración e inferencia de modelos. La aplicación aprovecha tu GPU cuando es posible.

-

LLaMA Factory es un marco de ajuste fino de modelos grandes de código bajo de código abierto que integra las técnicas de ajuste fino ampliamente utilizadas en la industria y admite el ajuste fino de modelos grandes sin código a través de la interfaz de usuario web.

-

-

Transformer Lab: Una plataforma de código abierto para construir, ajustar y ejecutar LLMs localmente sin necesidad de programar. Descarga cientos de modelos, ajusta finamente en diferentes hardwares, chatea, evalúa y mucho más.