What is Ludwig?

大規模言語モデル(LLM)や特殊なニューラルネットワークのようなカスタムAIモデルの構築、トレーニング、デプロイには、複雑なコードベースの操作や複雑なインフラの管理がしばしば必要になります。Ludwigは、これとは異なるアプローチを提供します。これは宣言型のローコードフレームワークであり、プロセス全体を効率化し、エンジニアリングの複雑さに煩わされることなく、モデリングそのものに集中できます。既存のLLMを微調整する場合でも、独自のマルチモーダルアーキテクチャをゼロから設計する場合でも、Ludwigは驚くほど簡単に洗練されたモデルを構築するためのツールを提供します。

主な機能

🛠️ 構成によるカスタムモデルの構築: シンプルな宣言型YAMLファイルを使用して、モデルアーキテクチャ全体、機能、およびトレーニングプロセスを定義します。Ludwigは、基盤となるコード生成を処理し、マルチタスクおよびマルチモーダル学習をシームレスにサポートします。包括的な検証チェックにより、実行前にエラーを検出します。

⚡ スケールと効率のために最適化: 大規模モデルを効果的にトレーニングします。Ludwigは、自動バッチサイズ調整、分散トレーニング(DDP、DeepSpeed)、Parameter Efficient Fine-Tuning(PEFT)メソッド(LoRAやQLoRA(4ビット量子化)など)、ページングされたオプティマイザ、およびRay統合によるメモリよりも大きいデータセットのサポートを組み込んでいます。

📐 エキスパートレベルの制御を維持: ローコードは、ローコントロールを意味するものではありません。アクティベーション関数に至るまですべてを指定できます。Ludwigは、ハイパーパラメータ最適化(HPO)ツールを統合し、説明可能性メソッド(特徴量の重要度、反事実)を提供し、モデルメトリックを評価するための豊富な視覚化を生成します。

🧱 モジュール性による迅速な実験: Ludwigを深層学習の構成要素と考えてください。そのモジュール設計により、エンコーダ、コンバイナ、デコーダを交換したり、構成ファイルに小さな変更を加えることで、さまざまなタスク、機能、またはモダリティを試したりして、迅速な反復を促進できます。

🚢 本番環境向けに設計: 実験からデプロイまでスムーズに進みます。Ludwigは、事前に構築されたDockerコンテナ、Kubernetes上のRayのネイティブサポートを提供し、モデルをTorchscriptやTriton Inference Serverなどの標準形式にエクスポートできます。トレーニング済みのモデルを、単一のコマンドでHuggingFace Hubに直接アップロードすることもできます。

ユースケース:Ludwigの実践

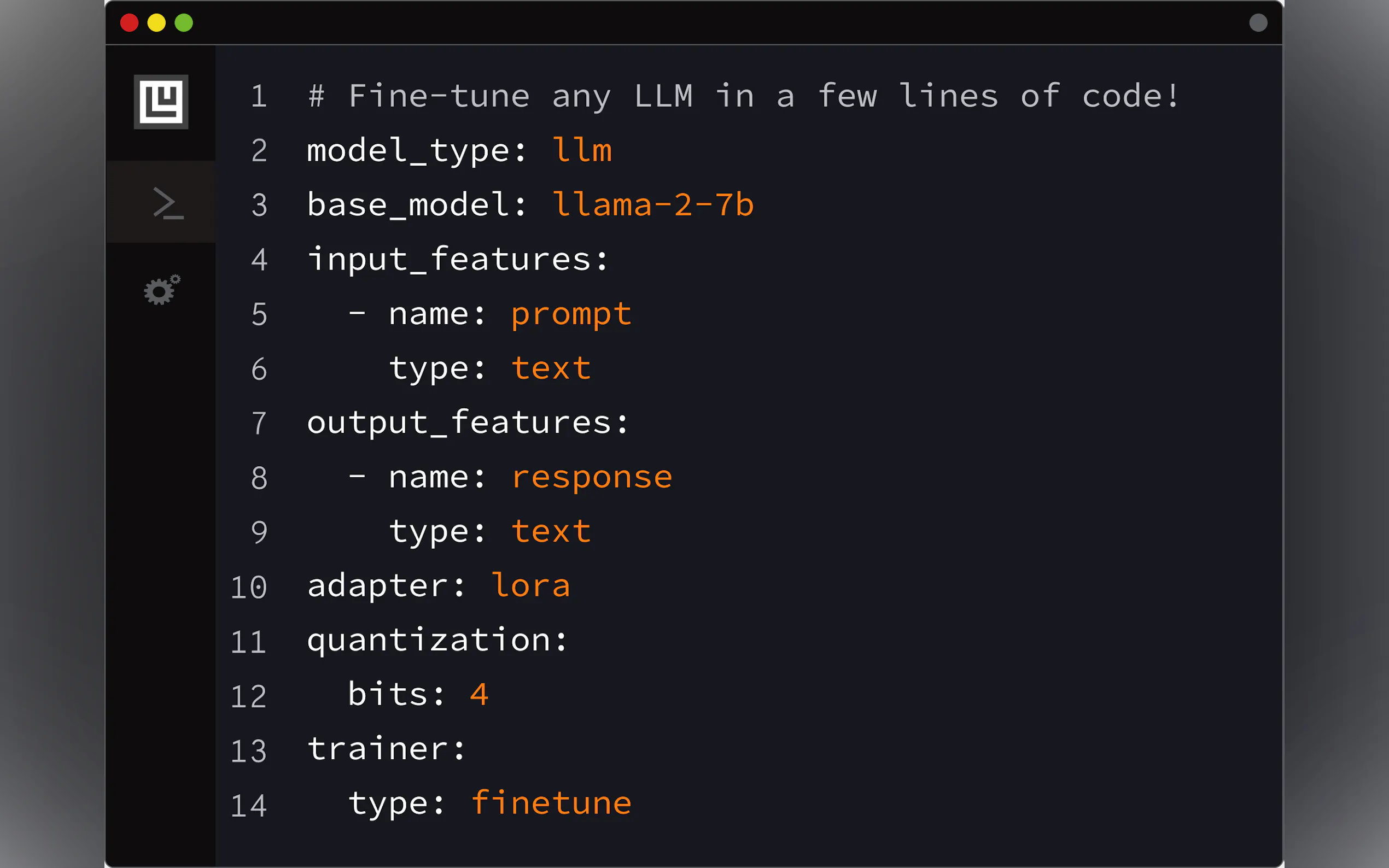

特定のタスクのためのLLMの微調整: 会社の内部ドキュメントに合わせたチャットボットが必要だとします。Ludwigを使用すると、Llama-2やMistral-7bなどの事前トレーニング済みのモデルを取得し、データ(命令/応答ペア)を指定するシンプルなYAML構成を定義し、効率のために4ビット量子化(QLoRA)を設定し、単一のコマンド(

ludwig train)で微調整プロセスを開始できます。これにより、広範なトレーニングコードを作成せずに、コンシューマーグレードのGPU(Nvidia T4など)で、特殊な、指示に従うLLMを作成できます。マルチモーダル分類器の構築: テキストレビュー、製品カテゴリ(セット)、コンテンツ評価(カテゴリ)、ランタイム(数値)、および批評家のステータス(バイナリ)に基づいて、製品の推奨の成功を予測するとします。Ludwigを使用すると、これらの多様な入力タイプをYAML構成で定義し、それぞれのタイプ(

text、set、category、number、binary)を指定し、適切なエンコーダ(テキストの場合はembedなど)を選択し、バイナリ出力機能(recommended)を定義します。Ludwigは、これらの混合データタイプを処理し、分類器をトレーニングするための適切なネットワークアーキテクチャを自動的に構築します。迅速なプロトタイピングとデプロイ: データセットがあり、分類モデルを迅速に構築してデプロイする必要があります。LudwigのAutoML機能(

ludwig.automl.auto_train)を使用すると、データセット、ターゲット変数、および制限時間を指定するだけです。Ludwigは、さまざまなモデル構成とハイパーパラメータを探索して、高性能なモデルを見つけます。トレーニングが完了すると、ludwig serveを使用してモデルのREST APIをすぐに起動し、予測にすぐに利用できるようにすることができます。

結論

Ludwigは、洗練されたカスタムAIモデルを構築するための参入障壁を大幅に下げます。複雑なボイラープレートコードを宣言型構成システムに置き換えることで、実験と開発を加速します。その組み込みの最適化により、効率的に大規模にトレーニングできることが保証され、本番環境対応の機能により、デプロイが簡素化されます。LLMを微調整したり、マルチモーダルシステムを構築したり、深層学習プロジェクトをより迅速に反復したりする場合は、Ludwigが強力でアクセス可能なフレームワークを提供します。