What is Ludwig?

Разработка, обучение и развертывание кастомных AI-моделей, таких как Large Language Models (LLMs) или специализированные нейронные сети, часто требует навигации по сложным кодовым базам и управления запутанной инфраструктурой. Ludwig предлагает другой путь. Это декларативный low-code фреймворк, который оптимизирует весь процесс, позволяя вам сосредоточиться на самом моделировании, а не увязать в инженерных сложностях. Независимо от того, выполняете ли вы тонкую настройку существующей LLM или разрабатываете уникальную мультимодальную архитектуру с нуля, Ludwig предоставляет инструменты для создания сложных моделей с поразительной легкостью.

Ключевые особенности

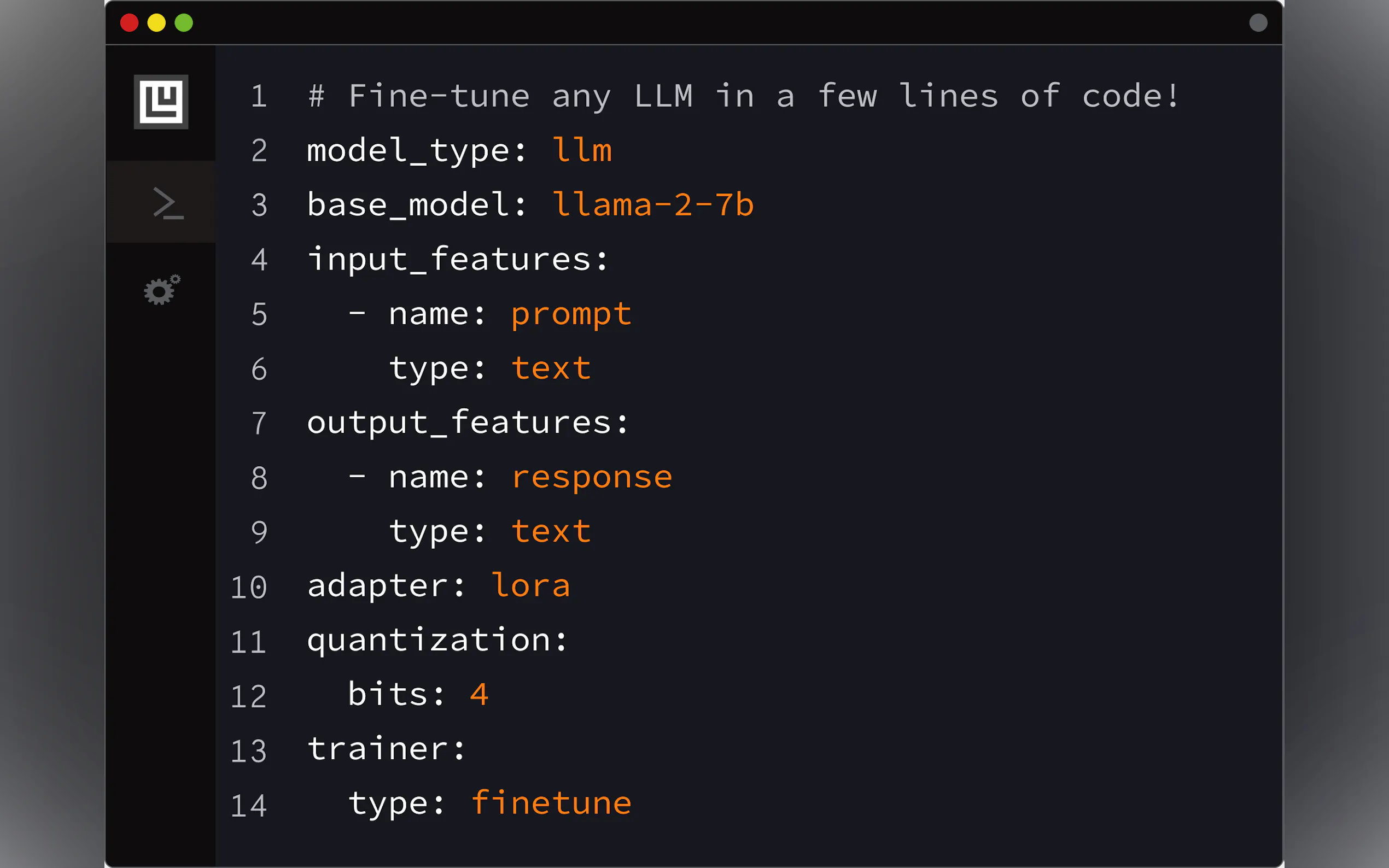

🛠️ Создание кастомных моделей через конфигурацию: Определите всю архитектуру вашей модели, признаки и процесс обучения, используя простой декларативный YAML-файл. Ludwig обрабатывает генерацию базового кода, плавно поддерживая многозадачное и мультимодальное обучение. Его комплексные проверки валидации выявляют ошибки до запуска.

⚡ Оптимизирован для масштаба и эффективности: Эффективно обучайте большие модели. Ludwig включает автоматическую настройку размера пакета, распределенное обучение (DDP, DeepSpeed), Parameter Efficient Fine-Tuning (PEFT) методы, такие как LoRA и QLoRA (4-битное квантование), страничные оптимизаторы и поддержку наборов данных больше, чем объем памяти, через интеграцию с Ray.

📐 Сохранение контроля на уровне эксперта: Low-code не означает низкий уровень контроля. Вы можете указать все, вплоть до функций активации. Ludwig интегрирует инструменты оптимизации гиперпараметров (HPO), предоставляет методы объяснения (важность признаков, контрфактические примеры) и создает богатые визуализации для оценки метрик модели.

🧱 Быстрое экспериментирование с модульностью: Представьте Ludwig как строительные блоки глубокого обучения. Его модульная конструкция позволяет вам заменять энкодеры, объединители и декодеры, экспериментировать с различными задачами, признаками или модальностями, внося небольшие изменения в ваш конфигурационный файл, что облегчает быструю итерацию.

🚢 Разработано для продакшена: Переходите от экспериментов к развертыванию плавно. Ludwig предлагает предварительно созданные Docker-контейнеры, нативную поддержку Ray на Kubernetes и позволяет экспортировать модели в стандартные форматы, такие как Torchscript и Triton Inference Server. Вы даже можете загружать обученные модели непосредственно в HuggingFace Hub с помощью одной команды.

Примеры использования: Ludwig на практике

Тонкая настройка LLM для конкретных задач: Представьте, что вам нужен чат-бот, адаптированный к внутренней документации вашей компании. С помощью Ludwig вы можете взять предварительно обученную модель, такую как Llama-2 или Mistral-7b, определить простую конфигурацию YAML, указав ваши данные (пары инструкция/ответ), настроить 4-битное квантование (QLoRA) для эффективности и запустить процесс тонкой настройки с помощью одной команды (

ludwig train). Это позволяет вам создать специализированную LLM, следующую инструкциям, на потребительских графических процессорах (например, Nvidia T4), не написав обширный код обучения.Создание мультимодального классификатора: Предположим, вы хотите прогнозировать успех рекомендации продукта на основе текстовых обзоров, категории продукта (set), рейтинга контента (category), времени выполнения (number) и статуса критика (binary). С помощью Ludwig вы определяете каждый из этих разнообразных типов ввода в своей конфигурации YAML, указываете их соответствующие типы (

text,set,category,number,binary), выбираете соответствующие энкодеры (например,embedдля текста) и определяете двоичный выходной признак (recommended). Ludwig автоматически конструирует соответствующую сетевую архитектуру для обработки этих смешанных типов данных и обучает классификатор.Быстрое прототипирование и развертывание: У вас есть набор данных, и вам нужно быстро создать и развернуть модель классификации. Используя функцию AutoML Ludwig (

ludwig.automl.auto_train), вы можете просто предоставить набор данных, целевую переменную и ограничение по времени. Ludwig изучает различные конфигурации моделей и гиперпараметры, чтобы найти высокопроизводительную модель. После обучения вы можете немедленно запустить REST API для своей модели, используяludwig serve, что делает ее мгновенно доступной для прогнозов.

Заключение

Ludwig значительно снижает порог вхождения для создания сложных, кастомных AI-моделей. Заменяя сложный шаблонный код декларативной системой конфигурации, он ускоряет эксперименты и разработку. Его встроенные оптимизации гарантируют, что вы сможете эффективно обучаться в масштабе, а его готовые к производству функции упрощают развертывание. Если вы хотите выполнить тонкую настройку LLM, создать мультимодальные системы или просто быстрее итерировать свои проекты глубокого обучения, Ludwig предоставляет мощный и доступный фреймворк.

More information on Ludwig

Top 5 Countries

Traffic Sources

Ludwig Альтернативи

Больше Альтернативи-

-

LM Studio — это удобное настольное приложение для экспериментов с локальными и открытыми большими языковыми моделями (LLM). Кроссплатформенное настольное приложение LM Studio позволяет скачивать и запускать любую ggml-совместимую модель с Hugging Face, а также предоставляет простой, но мощный пользовательский интерфейс для настройки моделей и выполнения инференса. Приложение задействует ваш GPU по возможности.

-

LLaMA Factory — это платформа с открытым исходным кодом для дообучения больших языковых моделей с минимальным количеством кода. Она объединяет в себе популярные методы дообучения, используемые в отрасли, и поддерживает дообучение моделей без кода через веб-интерфейс.

-

-

Transformer Lab: Открытая платформа для создания, настройки и запуска больших языковых моделей (LLM) локально без программирования. Загрузите сотни моделей, настройте их на различном оборудовании, пообщайтесь, оцените результаты и многое другое.