What is Ludwig?

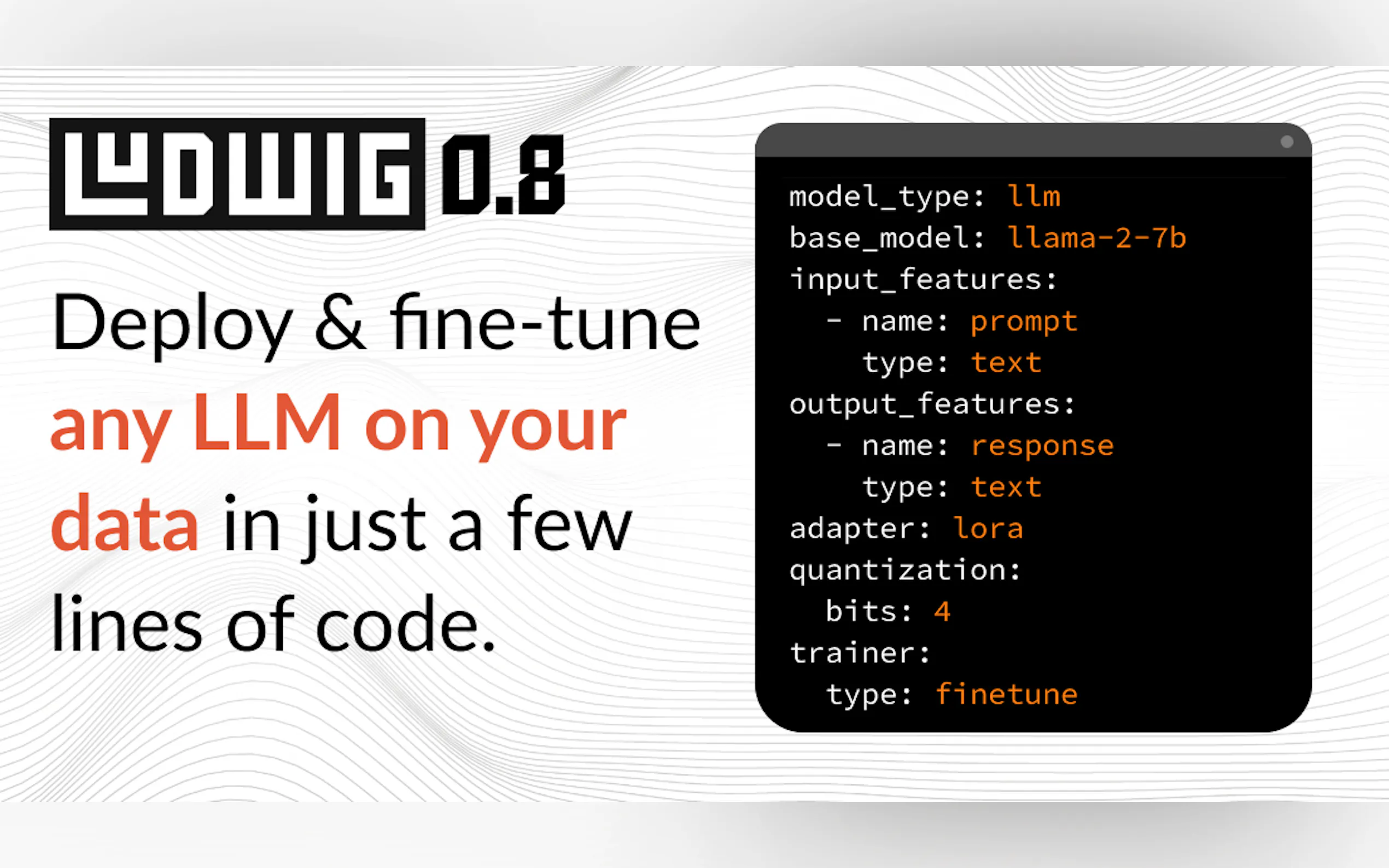

La création, l'entraînement et le déploiement de modèles d'IA personnalisés, tels que les grands modèles de langage (LLM) ou les réseaux neuronaux spécialisés, nécessitent souvent de naviguer dans des bases de code complexes et de gérer une infrastructure sophistiquée. Ludwig offre une approche différente. Il s'agit d'un framework déclaratif à faible code qui simplifie l'ensemble du processus, vous permettant de vous concentrer sur la modélisation elle-même, plutôt que de vous enliser dans des complexités d'ingénierie. Que vous souhaitiez affiner un LLM existant ou concevoir une architecture multimodale unique à partir de zéro, Ludwig vous fournit les outils nécessaires pour construire des modèles sophistiqués avec une facilité remarquable.

Fonctionnalités clés

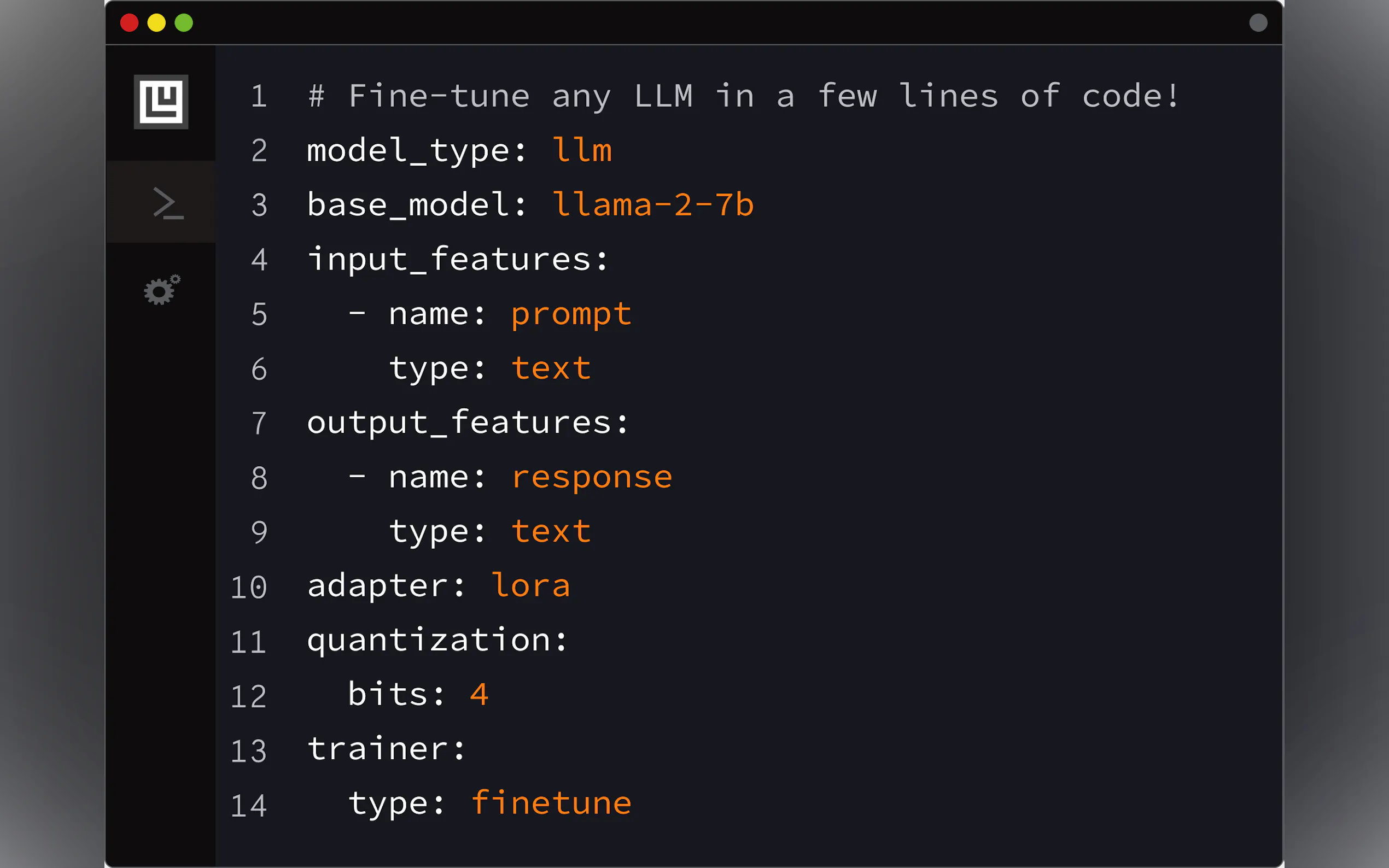

🛠️ Création de modèles personnalisés via la configuration : Définissez l'architecture complète de votre modèle, ses caractéristiques et son processus d'entraînement à l'aide d'un simple fichier YAML déclaratif. Ludwig gère la génération de code sous-jacente, prenant en charge l'apprentissage multi-tâches et multimodal de manière transparente. Ses contrôles de validation complets détectent les erreurs avant l'exécution.

⚡ Optimisé pour l'échelle et l'efficacité : Entraînez efficacement des modèles de grande taille. Ludwig intègre le réglage automatique de la taille des lots, l'entraînement distribué (DDP, DeepSpeed), les méthodes d'ajustement fin à faible paramétrage (PEFT) telles que LoRA et QLoRA (quantification 4 bits), les optimiseurs paginés et la prise en charge des ensembles de données plus grands que la mémoire via l'intégration de Ray.

📐 Conservez un contrôle de niveau expert : Faible code ne signifie pas faible contrôle. Vous pouvez tout spécifier, jusqu'aux fonctions d'activation. Ludwig intègre des outils d'optimisation des hyperparamètres (HPO), fournit des méthodes d'explicabilité (importance des caractéristiques, contrefactuels) et génère des visualisations riches pour évaluer les métriques du modèle.

🧱 Expérimentez rapidement avec la modularité : Considérez Ludwig comme des blocs de construction d'apprentissage profond. Sa conception modulaire vous permet d'échanger des encodeurs, des combinateurs et des décodeurs, d'expérimenter avec différentes tâches, caractéristiques ou modalités en apportant de petites modifications à votre fichier de configuration, facilitant ainsi une itération rapide.

🚢 Conçu pour la production : Passez de l'expérimentation au déploiement en douceur. Ludwig offre des conteneurs Docker préconstruits, une prise en charge native de Ray sur Kubernetes, et vous permet d'exporter des modèles vers des formats standard tels que Torchscript et Triton Inference Server. Vous pouvez même télécharger des modèles entraînés directement vers le HuggingFace Hub avec une seule commande.

Cas d'utilisation : Mettre Ludwig en pratique

Affiner un LLM pour des tâches spécifiques : Imaginez que vous ayez besoin d'un chatbot adapté à la documentation interne de votre entreprise. En utilisant Ludwig, vous pouvez prendre un modèle pré-entraîné tel que Llama-2 ou Mistral-7b, définir une simple configuration YAML spécifiant vos données (paires instruction/réponse), configurer une quantification 4 bits (QLoRA) pour l'efficacité, et lancer le processus d'ajustement fin avec une seule commande (

ludwig train). Cela vous permet de créer un LLM spécialisé, suivant les instructions, sur des GPU grand public (comme un Nvidia T4) sans écrire de code d'entraînement étendu.Création d'un classificateur multimodal : Supposons que vous souhaitiez prédire le succès d'une recommandation de produit en fonction des commentaires textuels, de la catégorie du produit (ensemble), de la classification du contenu (catégorie), de la durée (nombre) et de l'état du critique (binaire). Avec Ludwig, vous définissez chacun de ces types d'entrée divers dans votre configuration YAML, spécifiez leurs types respectifs (

text,set,category,number,binary), choisissez les encodeurs appropriés (par exemple,embedpour le texte) et définissez la caractéristique de sortie binaire (recommended). Ludwig construit automatiquement l'architecture de réseau appropriée pour gérer ces types de données mixtes et entraîne le classificateur.Prototypage et déploiement rapides : Vous avez un ensemble de données et vous devez rapidement créer et déployer un modèle de classification. En utilisant la fonctionnalité AutoML de Ludwig (

ludwig.automl.auto_train), vous pouvez simplement fournir l'ensemble de données, la variable cible et une limite de temps. Ludwig explore différentes configurations de modèle et hyperparamètres pour trouver un modèle très performant. Une fois entraîné, vous pouvez immédiatement lancer une API REST pour votre modèle en utilisantludwig serve, le rendant instantanément disponible pour les prédictions.

Conclusion

Ludwig abaisse considérablement la barrière à l'entrée pour la construction de modèles d'IA personnalisés et sophistiqués. En remplaçant le code boilerplate complexe par un système de configuration déclaratif, il accélère l'expérimentation et le développement. Ses optimisations intégrées vous garantissent un entraînement efficace à grande échelle, tandis que ses fonctionnalités prêtes pour la production simplifient le déploiement. Si vous cherchez à affiner les LLM, à construire des systèmes multimodaux, ou simplement à itérer plus rapidement sur vos projets d'apprentissage profond, Ludwig fournit un framework puissant et accessible.

More information on Ludwig

Top 5 Countries

Traffic Sources

Ludwig Alternatives

Plus Alternatives-

-

LM Studio est une application de bureau intuitive, conçue pour faciliter l'expérimentation avec les Large Language Models (LLM) locaux et open-source. Cette application multiplateforme vous offre la possibilité de télécharger et d'exécuter n'importe quel modèle compatible ggml directement depuis Hugging Face. Elle intègre une interface utilisateur (UI) pour la configuration et l'inférence des modèles, se distinguant par sa simplicité d'accès et sa puissance. De plus, elle tire pleinement parti de votre GPU lorsque les conditions le permettent.

-

LLaMA Factory est un framework open source de réglage fin de modèles volumineux à faible code qui intègre les techniques de réglage fin largement utilisées dans l'industrie et prend en charge le réglage fin sans code des grands modèles via l'interface Web UI.

-

-

Transformer Lab : Une plateforme open-source pour construire, affiner et exécuter des LLM localement sans coder. Téléchargez des centaines de modèles, affinez-les sur différents matériels, discutez, évaluez, et bien plus encore.