What is Phi-3 Mini-128K-Instruct ONNX?

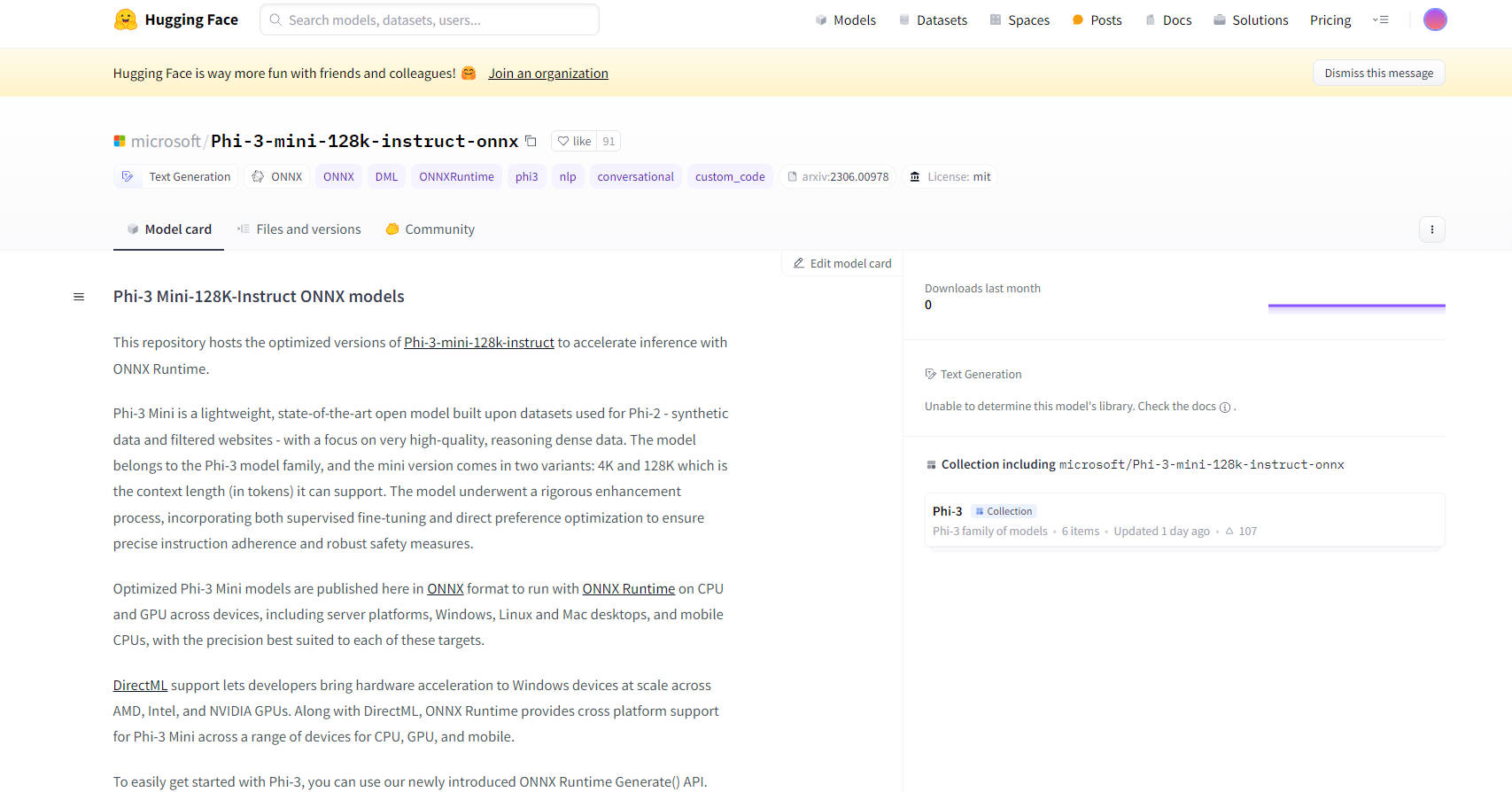

Los modelos Phi-3 Mini-128K-Instruct ONNX de Microsoft representan un avance revolucionario en la tecnología de IA de código abierto. Estos modelos están diseñados para mejorar las capacidades de inferencia con ONNX Runtime, ofreciendo un rendimiento optimizado en varias plataformas y dispositivos, incluidas CPU, GPU y dispositivos móviles. Los modelos Phi-3 Mini, específicamente la variante de 128K, están diseñados para el procesamiento de datos de alta calidad y denso en razonamiento, lo que los hace ideales para tareas complejas que requieren una adherencia robusta a las instrucciones y medidas de seguridad.

Características principales:

Rendimiento optimizado: Los modelos están disponibles en formato ONNX, lo que garantiza que se ejecuten de manera eficiente con ONNX Runtime en una variedad de dispositivos, desde servidores hasta teléfonos móviles. Esta optimización incluye compatibilidad con DirectML, lo que permite la aceleración de hardware en dispositivos Windows con GPU AMD, Intel y NVIDIA.

Compatibilidad multiplataforma: Con soporte para equipos de escritorio Windows, Linux y Mac, así como para CPU móviles, los modelos Phi-3 Mini-128K-Instruct ONNX brindan una amplia compatibilidad multiplataforma, lo que los hace versátiles para diversas aplicaciones.

Técnicas avanzadas de cuantificación: Los modelos utilizan la cuantificación consciente de la activación (AWQ), que cuantifica selectivamente el 99% menos relevante de los pesos para mantener la precisión, lo que da como resultado una pérdida de precisión mínima en comparación con los métodos de cuantificación tradicionales.

Facilidad de integración: Una nueva API de ONNX Runtime Generate() simplifica la integración de modelos Phi-3 Mini en aplicaciones, lo que permite a los desarrolladores incorporar fácilmente modelos de lenguaje grandes (LLM) en su software.

Documentación y soporte completos: Se encuentran disponibles documentación detallada y soporte comunitario, incluidas instrucciones sobre cómo comenzar con los modelos, lo que garantiza un proceso de desarrollo sin problemas para los usuarios.

Casos de uso:

IA conversacional: Ideales para chatbots y asistentes virtuales, los modelos Phi-3 Mini-128K-Instruct ONNX pueden manejar consultas complejas y mantener conversaciones coherentes y conscientes del contexto.

Generación de texto: Los modelos se destacan en generar texto de alta calidad y contextualmente relevante, útil para la creación de contenido, resúmenes y más.

Procesamiento del lenguaje natural (PNL): Estos modelos son adecuados para varias tareas de PNL, incluida la traducción de idiomas, el análisis de sentimientos y la extracción de información.

Público objetivo:

Desarrolladores e investigadores de IA: Ideales para quienes trabajan en proyectos de PNL, investigación de IA y desarrollo de aplicaciones inteligentes.

Empresas: Adecuadas para empresas que buscan integrar capacidades avanzadas de IA en sus productos o servicios, particularmente en áreas como servicio al cliente y generación de contenido.

Instituciones educativas: Beneficiosas para la investigación académica y la enseñanza de conceptos avanzados de IA y aprendizaje automático.

Requisitos de hardware:

Configuración mínima: GPU compatible con DirectX 12 con al menos 4 GB de RAM combinada para Windows y SM >= 70 para CUDA (por ejemplo, V100 o más reciente).

Hardware probado: Incluye RTX 4090 (DirectML), 1 GPU A100 de 80 GB, Standard F64s v2 (64 vcpu, 128 GiB de memoria) y Samsung Galaxy S21.

Métricas de rendimiento:

Los modelos demuestran un rendimiento superior en ONNX Runtime en comparación con PyTorch, con un rendimiento hasta 5 veces más rápido en FP16 CUDA y hasta 9 veces más rápido en INT4 CUDA.

Conclusión:

Los modelos Phi-3 Mini-128K-Instruct ONNX de Microsoft representan un salto significativo en la optimización y el despliegue de modelos de IA. Su versatilidad, facilidad de integración y alto rendimiento los convierten en una excelente opción para una amplia gama de aplicaciones, desde IA conversacional hasta tareas complejas de PNL. Con soporte para múltiples plataformas y técnicas avanzadas de cuantificación, estos modelos ofrecen potencia y flexibilidad para desarrolladores y empresas en el espacio de la IA.

More information on Phi-3 Mini-128K-Instruct ONNX

Phi-3 Mini-128K-Instruct ONNX Alternativas

Más Alternativas-

ONNX Runtime: Ejecuta modelos de ML más rápido, en cualquier lugar. Acelera la inferencia y el entrenamiento en diversas plataformas. ¡Compatible con PyTorch, TensorFlow y muchos más!

-

Phi-2 es un modelo ideal para que los investigadores exploren diferentes áreas como interpretabilidad mecanicista, mejoras de seguridad y experimentos de ajuste fino.

-

-

MiniCPM3-4B es la tercera generación de la serie MiniCPM. El rendimiento general de MiniCPM3-4B supera a Phi-3.5-mini-Instruct y GPT-3.5-Turbo-0125, siendo comparable con muchos modelos recientes de 7B~9B.

-

Gemma 3 270M: IA compacta e hiper-eficiente para tareas especializadas. Afínela para un seguimiento preciso de instrucciones y una implementación de bajo costo directamente en el dispositivo.