What is Phi-3 Mini-128K-Instruct ONNX?

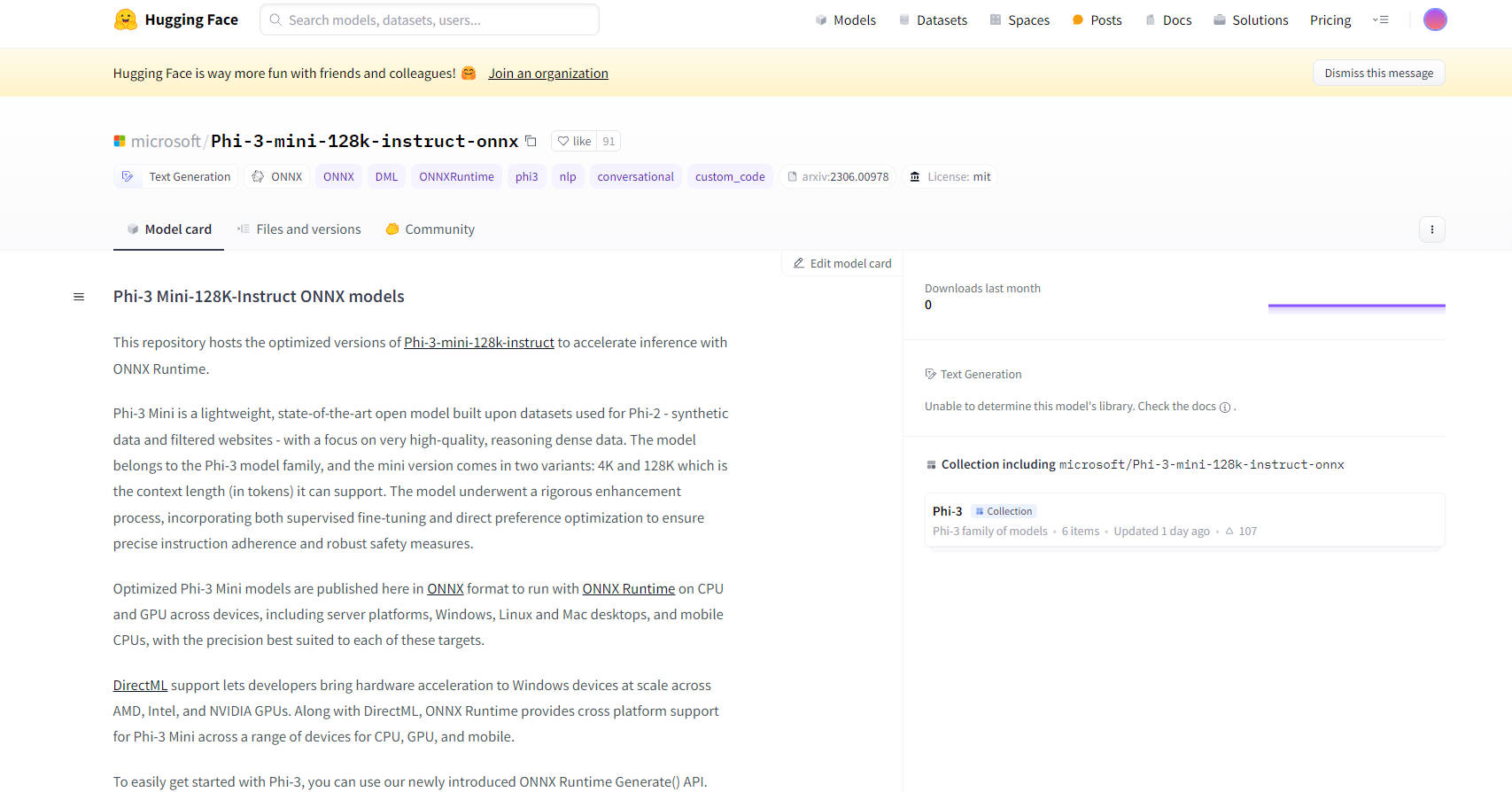

微軟的 Phi-3 Mini-128K-Instruct ONNX 模型代表開放原始碼 AI 技術的尖端進展。這些模型專為透過 ONNX Runtime 提升推理能力,在包括 CPU、GPU 和行動裝置等各種平台和裝置上提供最佳化效能。Phi-3 Mini 模型特別是 128K 變體,專為高品質、推理密集型資料處理而設計,使其成為需要堅固指令遵循和安全措施的複雜任務的理想選擇。

主要特色:

最佳化效能:這些模型採用 ONNX 格式,可確保在從伺服器到手機等各種裝置上使用 ONNX Runtime 時能有效率地執行。此最佳化包括對 DirectML 的支援,可在配備 AMD、Intel 和 NVIDIA GPU 的 Windows 裝置上進行硬體加速。

跨平台相容性:透過支援 Windows、Linux 和 Mac 桌上型電腦以及行動裝置 CPU,Phi-3 Mini-128K-Instruct ONNX 模型提供廣泛的跨平台相容性,使其適用於各種應用。

進階量化技術:這些模型採用 Activation Aware Quantization (AWQ),有選擇地將最不重要的 99% 權重量化以維持精準度,與傳統量化方法相比,造成的精準度損失極小。

易於整合:新的 ONNX Runtime Generate() API 簡化將 Phi-3 Mini 模型整合到應用程式的流程,讓開發人員能輕鬆地將大型語言模型 (LLM) 納入其軟體中。

全面的文件和支援:提供詳細的文件和社群支援,包括使用模型的入門說明,確保使用者的開發過程順利。

用例:

對話式 AI:Phi-3 Mini-128K-Instruct ONNX 模型非常適合聊天機器人和虛擬助理,可以處理複雜的查詢,並維持連貫、情境感知的對話。

文字產生:這些模型擅長產生高品質、與情境相關的文字,適用於內容建立、摘要等。

自然語言處理 (NLP):這些模型非常適合各種 NLP 任務,包括語言翻譯、情緒分析和資訊萃取。

目標受眾:

AI 開發人員和研究人員:非常適合從事 NLP 專案、AI 研究和開發智慧應用程式的人員。

企業:適合尋求將進階 AI 功能整合到其產品或服務中的企業,特別是在客服和內容產生等領域。

教育機構:有利於學術研究和教授進階 AI 和機器學習概念。

硬體需求:

最低配置:DirectX 12 相容 GPU,Windows 至少具備 4GB 總 RAM,CUDA 的 SMs >= 70(例如 V100 或更新版本)。

測試過的硬體:包括 RTX 4090 (DirectML)、1 個 A100 80GB GPU、標準 F64s v2(64 個 vcpu,128 GiB 記憶體)和 Samsung Galaxy S21。

效能指標:

與 PyTorch 相比,這些模型在 ONNX Runtime 中展現出優異的效能,FP16 CUDA 的效能快達 5 倍,INT4 CUDA 快達 9 倍。

結論:

微軟的 Phi-3 Mini-128K-Instruct ONNX 模型代表 AI 模型最佳化和部署的重大進步。其多功能性、易於整合和高效能使其成為從對話式 AI 到複雜 NLP 任務等廣泛應用程式的絕佳選擇。藉由支援多個平台和進階量化技術,這些模型為 AI 領域的開發人員和企業提供強大且靈活的解決方案。