What is Phi-3 Mini-128K-Instruct ONNX?

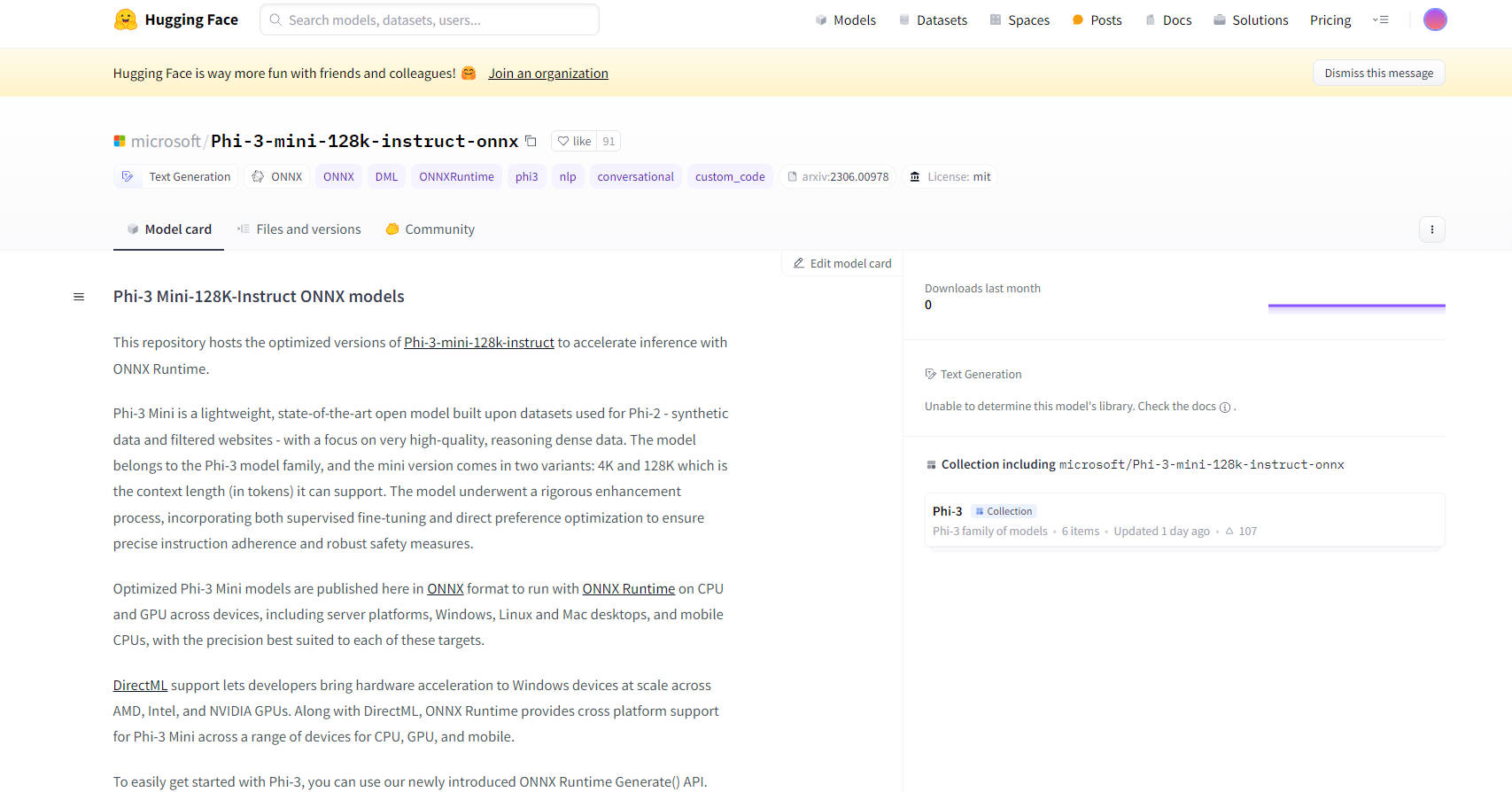

Microsoft의 Phi-3 Mini-128K-Instruct ONNX 모델은 오픈소스 AI 기술의 첨단적 발전을 보여줍니다. 이러한 모델은 ONNX Runtime을 통한 추론 역량을 향상시키도록 설계되어 CPU, GPU, 모바일 기기 등 다양한 플랫폼과 기기에서 최적화된 성능을 제공합니다. Phi-3 Mini 모델, 특히 128K 변형은 고품질의 추론이 많은 데이터 처리에 맞춤화되어 견고한 명령 준수와 안전 조처가 필요한 복잡한 작업에 이상적입니다.

주요 특징:

최적화된 성능: 이 모델은 ONNX 포맷으로 제공되어 서버에서 모바일 폰에 이르기까지 다양한 기기에서 ONNX Runtime으로 효율적으로 실행됩니다. 이러한 최적화에는 DirectML 지원이 포함되어 AMD, Intel, NVIDIA GPU를 탑재한 Windows 기기에서 하드웨어 가속을 사용할 수 있습니다.

크로스 플랫폼 호환성: Windows, Linux, Mac 데스크톱과 모바일 CPU를 지원하는 Phi-3 Mini-128K-Instruct ONNX 모델은 다양한 응용 프로그램에 사용할 수 있는 광범위한 크로스 플랫폼 호환성을 제공합니다.

고급 양자화 기술: 이 모델은 중요하지 않은 가중치를 99% 선택적으로 양자화하여 정확도를 유지하는 활성화 인식 양자화(AWQ)를 사용하며, 이를 통해 기존의 양자화 방식에 비해 정확도 손실을 최소화합니다.

손쉬운 통합: 새로운 ONNX Runtime Generate() API를 통해 Phi-3 Mini 모델을 응용 프로그램에 통합하는 것이 간소화되어 개발자가 대규모 언어 모델(LLM)을 소프트웨어에 손쉽게 통합할 수 있습니다.

포괄적인 문서화 및 지원: 모델을 시작하는 방법에 대한 지침을 비롯한 자세한 문서화와 커뮤니티 지원을 제공하여 사용자의 원활한 개발 프로세스를 보장합니다.

사용 사례:

대화형 AI: Phi-3 Mini-128K-Instruct ONNX 모델은 챗봇과 가상 비서에 이상적이며 복잡한 질의를 처리하고 일관되고 맥락을 인식한 대화를 유지할 수 있습니다.

텍스트 생성: 이 모델은 맥락에 맞는 고품질의 텍스트를 생성하는 데 뛰어나며, 콘텐츠 생성, 요약 등에 유용합니다.

자연어 처리(NLP): 이러한 모델은 언어 변환, 감정 분석, 정보 추출을 포함한 다양한 NLP 작업에 적합합니다.

대상 청중:

AI 개발자 및 연구자: NLP 프로젝트, AI 연구, 스마트 응용 프로그램 개발에 종사하는 분들에게 이상적입니다.

기업: 특히 고객 서비스나 콘텐츠 생성과 같은 분야에서 제품이나 서비스에 고급 AI 역량을 통합하려는 기업에 적합합니다.

교육 기관: 고급 AI 및 머신러닝 개념을 연구하고 가르치는 학술 연구에 유익합니다.

하드웨어 요구 사항:

최소 구성: Windows의 경우 최소 4GB의 결합된 RAM이 있는 DirectX 12 지원 GPU, CUDA의 경우 SMs >= 70(예: V100 이상).

테스트된 하드웨어: RTX 4090(DirectML), 1 A100 80GB GPU, Standard F64s v2(64vcpu, 128GiB 메모리), 삼성 갤럭시 S21이 포함됩니다.

성능 측정 지표:

이 모델은 PyTorch에 비해 ONNX Runtime에서 우수한 성능을 보여주며, FP16 CUDA에서는 최대 5배, INT4 CUDA에서는 최대 9배 더 빠른 성능을 제공합니다.

결론:

Microsoft의 Phi-3 Mini-128K-Instruct ONNX 모델은 AI 모델 최적화와 배포에서 상당한 진전을 보여줍니다. 이 모델의 다기능성, 통합의 용이성, 고성능은 대화형 AI에서 복잡한 NLP 작업에 이르기까지 광범위한 응용 프로그램에 탁월한 선택이 될 것입니다. 다양한 플랫폼과 고급 양자화 기술을 지원하는 이 모델은 AI 분야의 개발자와 기업에 강력하고 유연한 기능을 제공합니다.

More information on Phi-3 Mini-128K-Instruct ONNX

Phi-3 Mini-128K-Instruct ONNX 대체품

더보기 대체품-

ONNX Runtime: 어디서든 더 빠르게 ML 모델을 실행하세요. 다양한 플랫폼에서 추론 및 학습 속도를 가속화합니다. PyTorch, TensorFlow 등 다양한 프레임워크를 지원합니다!

-

Phi-2는 연구자들이 기계적 해석 가능성, 안전 개선, 미세 조정 실험 같은 다양한 분야를 탐색하기에 이상적인 모델입니다.

-

-

MiniCPM3-4B는 MiniCPM 시리즈의 3세대 모델입니다. MiniCPM3-4B는 Phi-3.5-mini-Instruct와 GPT-3.5-Turbo-0125를 능가하는 전반적인 성능을 보여주며, 최근 7B~9B 모델들과 비교 가능한 수준입니다.

-

Gemma 3 270M: 특화된 작업을 위한 소형 초고효율 AI. 정교한 지시 수행 및 저비용 온디바이스 배포를 위해 미세 조정 가능합니다.