What is Phi-3 Mini-128K-Instruct ONNX?

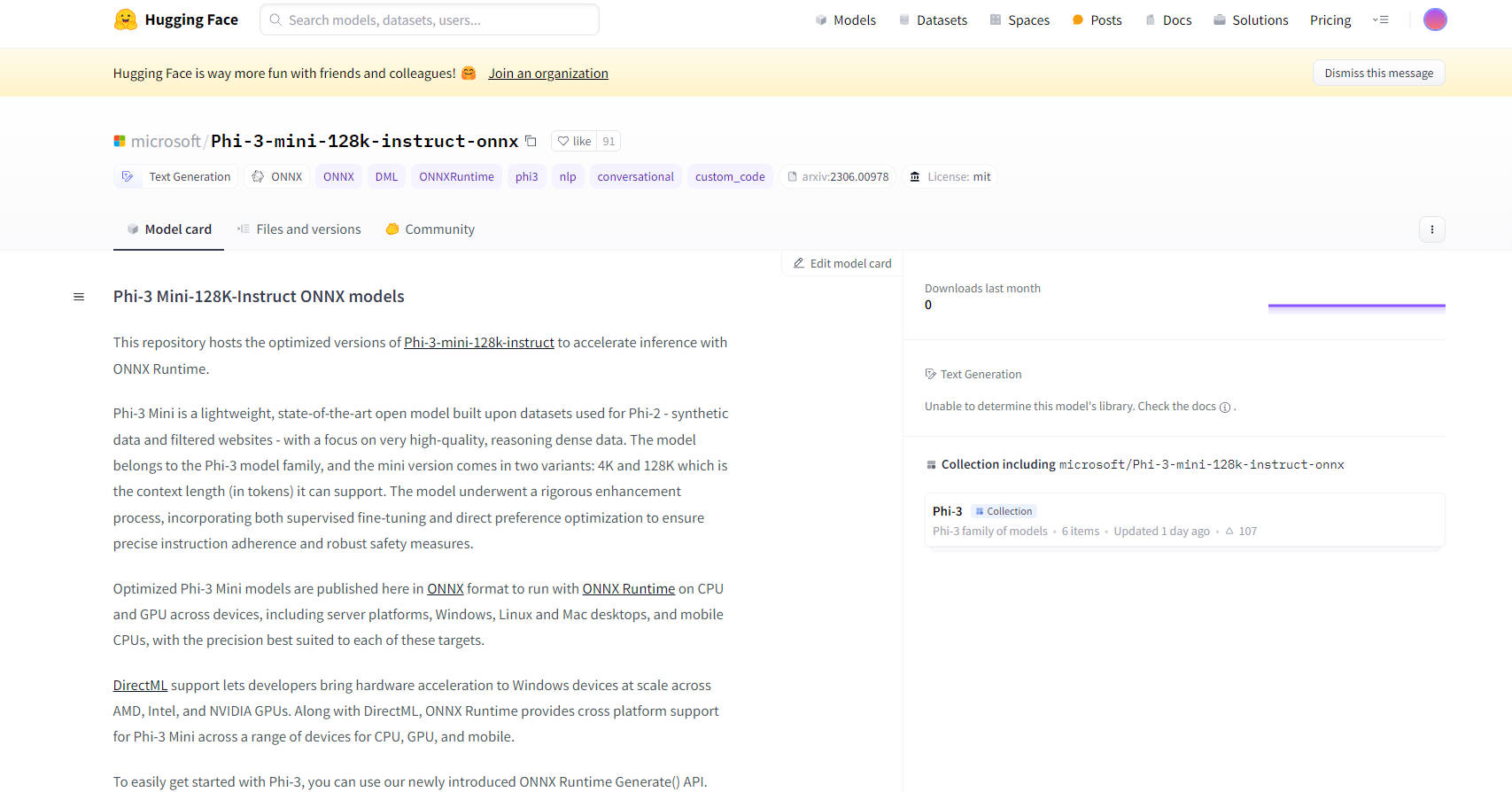

Les modèles ONNX Mini-128K-Instruct Phi-3 de Microsoft représentent une avancée de pointe dans la technologie de l'IA open source. Ces modèles sont conçus pour améliorer les capacités d'inférence avec ONNX Runtime, offrant des performances optimisées sur diverses plates-formes et appareils, notamment les processeurs, les processeurs graphiques et les appareils mobiles. Les modèles Phi-3 Mini, en particulier la variante 128K, sont adaptés au traitement de données de haute qualité et à forte densité de raisonnement, ce qui les rend idéaux pour les tâches complexes nécessitant une adhésion rigoureuse aux instructions et des mesures de sécurité.

Principales caractéristiques :

Performances optimisées : les modèles sont disponibles au format ONNX, ce qui garantit leur exécution efficace avec ONNX Runtime sur une gamme d'appareils, des serveurs aux téléphones mobiles. Cette optimisation inclut la prise en charge de DirectML, permettant l'accélération matérielle sur les appareils Windows dotés de processeurs graphiques AMD, Intel et NVIDIA.

Compatibilité multiplateforme : avec la prise en charge des ordinateurs de bureau Windows, Linux et Mac, ainsi que des processeurs mobiles, les modèles ONNX Mini-128K-Instruct Phi-3 offrent une compatibilité multiplateforme étendue, ce qui les rend polyvalents pour diverses applications.

Techniques de quantification avancées : les modèles utilisent la quantification consciente de l'activation (AWQ), qui quantifie sélectivement les 99 % de poids les moins saillants pour maintenir la précision, ce qui entraîne une perte de précision minimale par rapport aux méthodes de quantification traditionnelles.

Facilité d'intégration : une nouvelle API ONNX Runtime Generate() simplifie l'intégration des modèles Phi-3 Mini dans les applications, permettant aux développeurs d'incorporer facilement des grands modèles de langage (LLM) dans leurs logiciels.

Documentation et support complets : une documentation détaillée et un support communautaire sont disponibles, y compris des instructions pour démarrer avec les modèles, garantissant un processus de développement fluide pour les utilisateurs.

Cas d'utilisation :

IA conversationnelle : idéaux pour les chatbots et les assistants virtuels, les modèles ONNX Mini-128K-Instruct Phi-3 peuvent gérer des requêtes complexes et maintenir des conversations cohérentes et contextuelles.

Génération de texte : les modèles excellent dans la génération de texte de haute qualité et contextuellement pertinent, utile pour la création de contenu, le résumé, etc.

Traitement du langage naturel (PNL) : ces modèles sont bien adaptés à diverses tâches de PNL, notamment la traduction linguistique, l'analyse des sentiments et l'extraction d'informations.

Public cible :

Développeurs et chercheurs en IA : idéal pour ceux qui travaillent sur des projets de PNL, la recherche sur l'IA et le développement d'applications intelligentes.

Entreprises : adapté aux entreprises cherchant à intégrer des capacités d'IA avancées dans leurs produits ou services, en particulier dans des domaines tels que le service client et la génération de contenu.

Établissements d'enseignement : bénéfique pour la recherche universitaire et l'enseignement des concepts avancés d'IA et d'apprentissage automatique.

Configuration matérielle :

Configuration minimale : processeur graphique compatible DirectX 12 avec au moins 4 Go de RAM combinée pour Windows et SM>= 70 pour CUDA (par exemple, V100 ou plus récent).

Matériel testé : inclut RTX 4090 (DirectML), 1 processeur graphique A100 80 Go, F64s v2 standard (64 vCPU, 128 Gio de mémoire) et Samsung Galaxy S21.

Métriques de performance :

Les modèles démontrent des performances supérieures dans ONNX Runtime par rapport à PyTorch, avec des performances jusqu'à 5X plus rapides en FP16 CUDA et jusqu'à 9X plus rapides en INT4 CUDA.

Conclusion :

Les modèles ONNX Mini-128K-Instruct Phi-3 de Microsoft représentent un bond en avant significatif dans l'optimisation et le déploiement des modèles d'IA. Leur polyvalence, leur facilité d'intégration et leurs hautes performances en font un excellent choix pour une large gamme d'applications, de l'IA conversationnelle aux tâches de PNL complexes. Avec la prise en charge de plusieurs plates-formes et des techniques de quantification avancées, ces modèles offrent à la fois puissance et flexibilité aux développeurs et aux entreprises dans l'espace de l'IA.

More information on Phi-3 Mini-128K-Instruct ONNX

Phi-3 Mini-128K-Instruct ONNX Alternatives

Plus Alternatives-

ONNX Runtime : Exécutez vos modèles de ML plus rapidement, où que vous soyez. Accélérez l'inférence et l'entraînement sur toutes les plateformes. Prise en charge de PyTorch, TensorFlow et bien plus encore !

-

Phi-2 est un modèle idéal pour les chercheurs afin d'explorer différents domaines tels que l'interprétabilité mécaniste, les améliorations de sécurité et les expériences de réglage fin.

-

-

MiniCPM3-4B est la 3e génération de la série MiniCPM. Les performances globales de MiniCPM3-4B surpassent celles de Phi-3.5-mini-Instruct et GPT-3.5-Turbo-0125, se comparant à de nombreux modèles récents de 7B à 9B.

-

Gemma 3 270M : IA compacte et hyper-efficace pour les tâches spécialisées. Idéale pour un affinage précis des instructions et un déploiement économique embarqué.