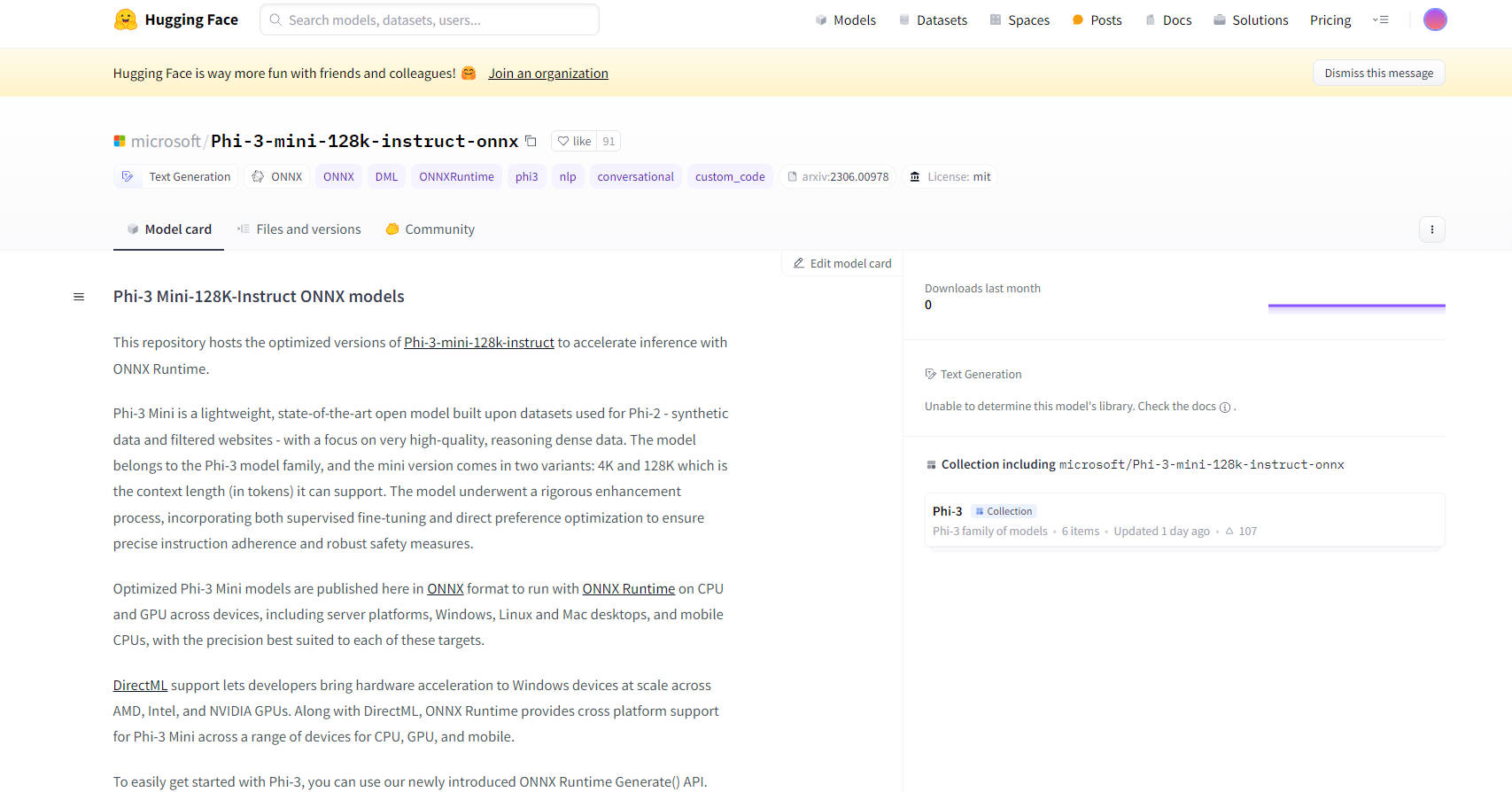

What is Phi-3 Mini-128K-Instruct ONNX?

Основные возможности:

Оптимизированная производительность: модели представлены в формате ONNX, что гарантирует их эффективную работу с ONNX Runtime на различных устройствах, от серверов до мобильных телефонов. Эта оптимизация включает поддержку DirectML, обеспечивающую аппаратное ускорение на устройствах Windows с графическими процессорами AMD, Intel и NVIDIA.

Кроссплатформенная совместимость: благодаря поддержке настольных компьютеров Windows, Linux и Mac, а также мобильных процессоров, модели ONNX Phi-3 Mini-128K-Instruct обеспечивают широкую кроссплатформенную совместимость, делая их универсальными для различных приложений.

Передовые методы квантования: модели используют квантование с учетом активации (AWQ), которое избирательно квантует наименее значимые 99% весов для сохранения точности, что приводит к минимальной потере точности по сравнению с традиционными методами квантования.

Простота интеграции: новый API ONNX Runtime Generate() упрощает интеграцию моделей Phi-3 Mini в приложения, позволяя разработчикам легко включать большие языковые модели (LLM) в свое программное обеспечение.

Подробная документация и поддержка: доступны подробная документация и поддержка сообщества, включая инструкции по началу работы с моделями, обеспечивающие плавный процесс разработки для пользователей.

Варианты использования:

Разговорный ИИ: идеальные для чат-ботов и виртуальных помощников модели Phi-3 Mini-128K-Instruct ONNX могут обрабатывать сложные запросы и поддерживать последовательные, контекстно-зависимые беседы.

Генерация текста: модели превосходно генерируют высококачественный, контекстуально релевантный текст, полезный для создания контента, составления резюме и многого другого.

Обработка естественного языка (NLP): эти модели хорошо подходят для различных задач NLP, включая перевод языков, анализ тональности и извлечение информации.

Целевая аудитория:

Разработчики и исследователи ИИ: идеальные для тех, кто работает над проектами NLP, исследованиями ИИ и разработкой интеллектуальных приложений.

Предприятия: подходят для компаний, которые стремятся интегрировать передовые возможности ИИ в свои продукты или услуги, особенно в таких областях, как обслуживание клиентов и создание контента.

Учебные заведения: полезны для академических исследований и преподавания передовых концепций ИИ и машинного обучения.

Требования к оборудованию:

Минимальная конфигурация: графический процессор с поддержкой DirectX 12 с общей оперативной памятью не менее 4 ГБ для Windows и SMs >= 70 для CUDA (например, V100 или новее).

Протестированное оборудование: включает RTX 4090 (DirectML), 1 графический процессор A100 80 ГБ, стандартный F64s v2 (64 виртуальных процессора, 128 ГБ памяти) и Samsung Galaxy S21.

Показатели производительности:

Модели демонстрируют превосходную производительность в ONNX Runtime по сравнению с PyTorch, вплоть до 5 раз быстрее на FP16 CUDA и до 9 раз быстрее на INT4 CUDA.

Заключение:

Модели ONNX Phi-3 Mini-128K-Instruct от Microsoft представляют собой значительный шаг вперед в оптимизации и развертывании моделей ИИ. Их универсальность, простота интеграции и высокая производительность делают их отличным выбором для широкого спектра приложений, от разговорного ИИ до сложных задач NLP. Благодаря поддержке нескольких платформ и передовым методам квантования эти модели предлагают как мощность, так и гибкость для разработчиков и предприятий в сфере ИИ.

More information on Phi-3 Mini-128K-Instruct ONNX

Phi-3 Mini-128K-Instruct ONNX Альтернативи

Больше Альтернативи-

ONNX Runtime: Запускайте модели машинного обучения быстрее, где угодно. Ускоряйте вывод и обучение на различных платформах. Поддержка PyTorch, TensorFlow и многих других!

-

Phi-2 является идеальной моделью для исследователей, изучающих различные области, такие как механистическая интерпретируемость, повышение безопасности и эксперименты по точной настройке.

-

-

MiniCPM3-4B - это третье поколение серии MiniCPM. В целом, производительность MiniCPM3-4B превосходит Phi-3.5-mini-Instruct и GPT-3.5-Turbo-0125, будучи сопоставимой со многими современными моделями размером 7B~9B.

-

Gemma 3 270M: Компактный, сверхэффективный ИИ для специализированных задач. Легко настраивается для точного выполнения команд и экономичного локального развертывания.