What is Phi-3 Mini-128K-Instruct ONNX?

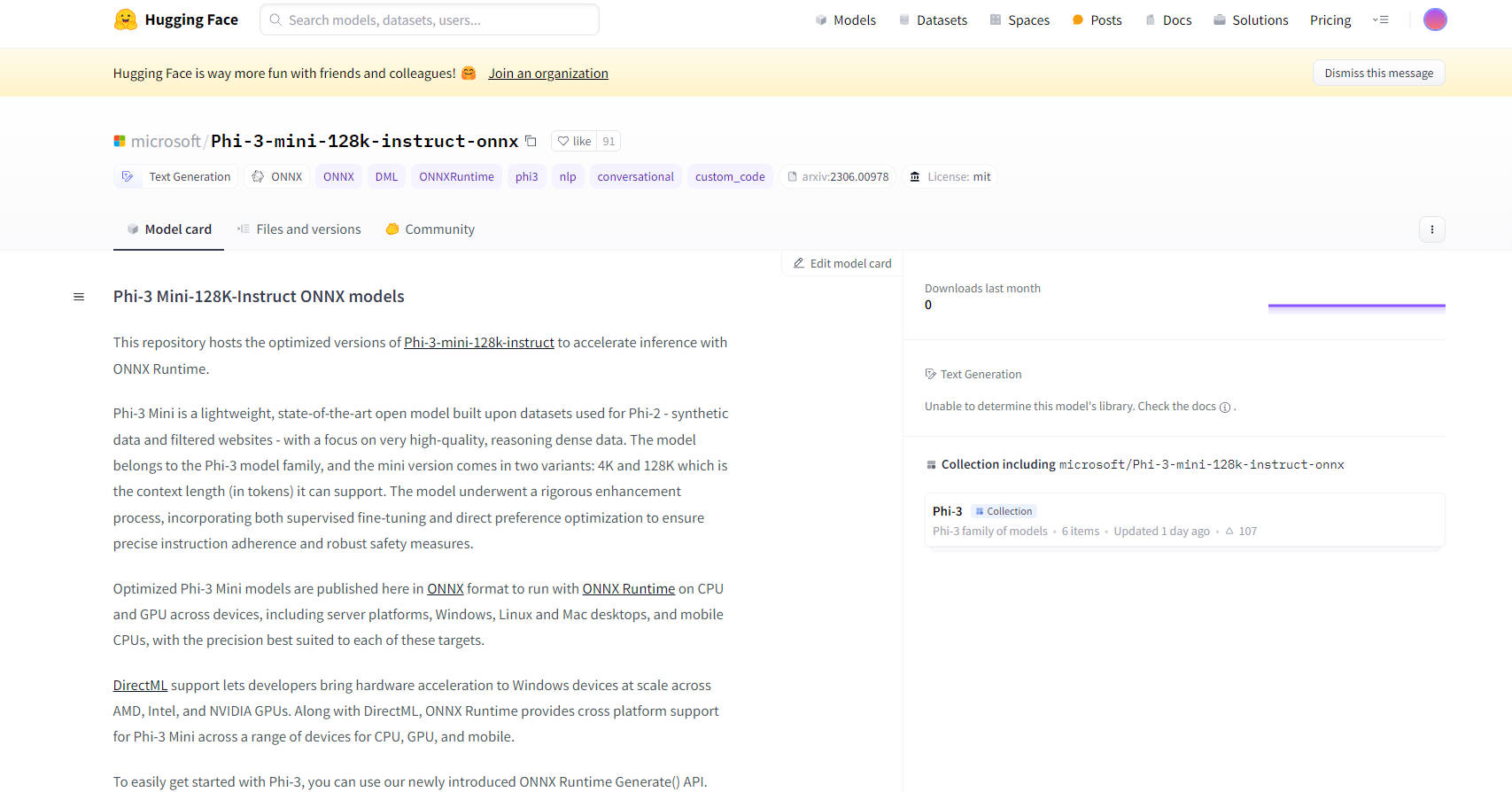

微软的 Phi-3 Mini-128K-Instruct ONNX 模型代表了开源 AI 技术中的前沿进步。这些模型旨在通过 ONNX Runtime 增强推理能力,为包括 CPU、GPU 和移动设备在内的各种平台和设备提供优化性能。Phi-3 Mini 模型,特别是 128K 变量,专为高质量、密集推理数据处理而设计,使其成为需要鲁棒指令遵循和安全措施的复杂任务的理想选择。

主要特点:

优化性能:这些模型采用 ONNX 格式,确保它们可以在从服务器到移动电话的各种设备上通过 ONNX Runtime 高效运行。此优化包括对 DirectML 的支持,允许在使用 AMD、Intel 和 NVIDIA GPU 的 Windows 设备上进行硬件加速。

跨平台兼容性:通过对 Windows、Linux 和 Mac 桌面以及移动 CPU 的支持,Phi-3 Mini-128K-Instruct ONNX 模型提供了广泛的跨平台兼容性,使其适用于各种应用程序。

先进的量化技术:这些模型利用 Activation Aware Quantization (AWQ),有选择性地量化最不突出的 99% 的权重以保持准确性,与传统量化方法相比,准确性损失最小。

易于集成:新的 ONNX Runtime Generate() API 简化了 Phi-3 Mini 模型与应用程序的集成,允许开发人员轻松地将大型语言模型 (LLM) 融入其软件。

全面的文档和支持:提供详细的文档和社区支持,包括有关如何开始使用模型的说明,确保用户顺利的开发过程。

使用案例:

会话式 AI:对于聊天机器人和虚拟助手来说,Phi-3 Mini-128K-Instruct ONNX 模型可以处理复杂的查询并维持连贯的上下文感知对话。

文本生成:这些模型擅长生成高质量的、上下文相关的文本,可用于内容创建、摘要等。

自然语言处理 (NLP):这些模型非常适合各种 NLP 任务,包括语言翻译、情感分析和信息提取。

目标受众:

AI 开发人员和研究人员:非常适合从事 NLP 项目、AI 研究和开发智能应用程序的人员。

企业:适用于希望将先进的 AI 能力集成到其产品或服务中的企业,尤其是在客户服务和内容生成等领域。

教育机构:有利于学术研究和教授先进的 AI 和机器学习概念。

硬件要求:

最低配置:DirectX 12 兼容 GPU,Windows 至少有 4GB 的组合 RAM,CUDA 的 SMs >= 70(例如,V100 或更新版本)。

测试硬件:包括 RTX 4090 (DirectML)、1 A100 80GB GPU、标准 F64s v2(64 个 vcpu,128 GiB 内存)和 Samsung Galaxy S21。

性能指标:

这些模型在 ONNX Runtime 中展示了优于 PyTorch 的卓越性能,在 FP16 CUDA 中的速度提高了 5 倍,在 INT4 CUDA 中的速度提高了 9 倍。

结论:

微软的 Phi-3 Mini-128K-Instruct ONNX 模型代表了 AI 模型优化和部署的重大飞跃。它们的通用性、易于集成和高性能使其成为广泛应用程序的绝佳选择,从会话式 AI 到复杂的 NLP 任务。凭借对多个平台和先进量化技术的支持,这些模型为 AI 领域的开发人员和企业提供了强大的功能和灵活性。