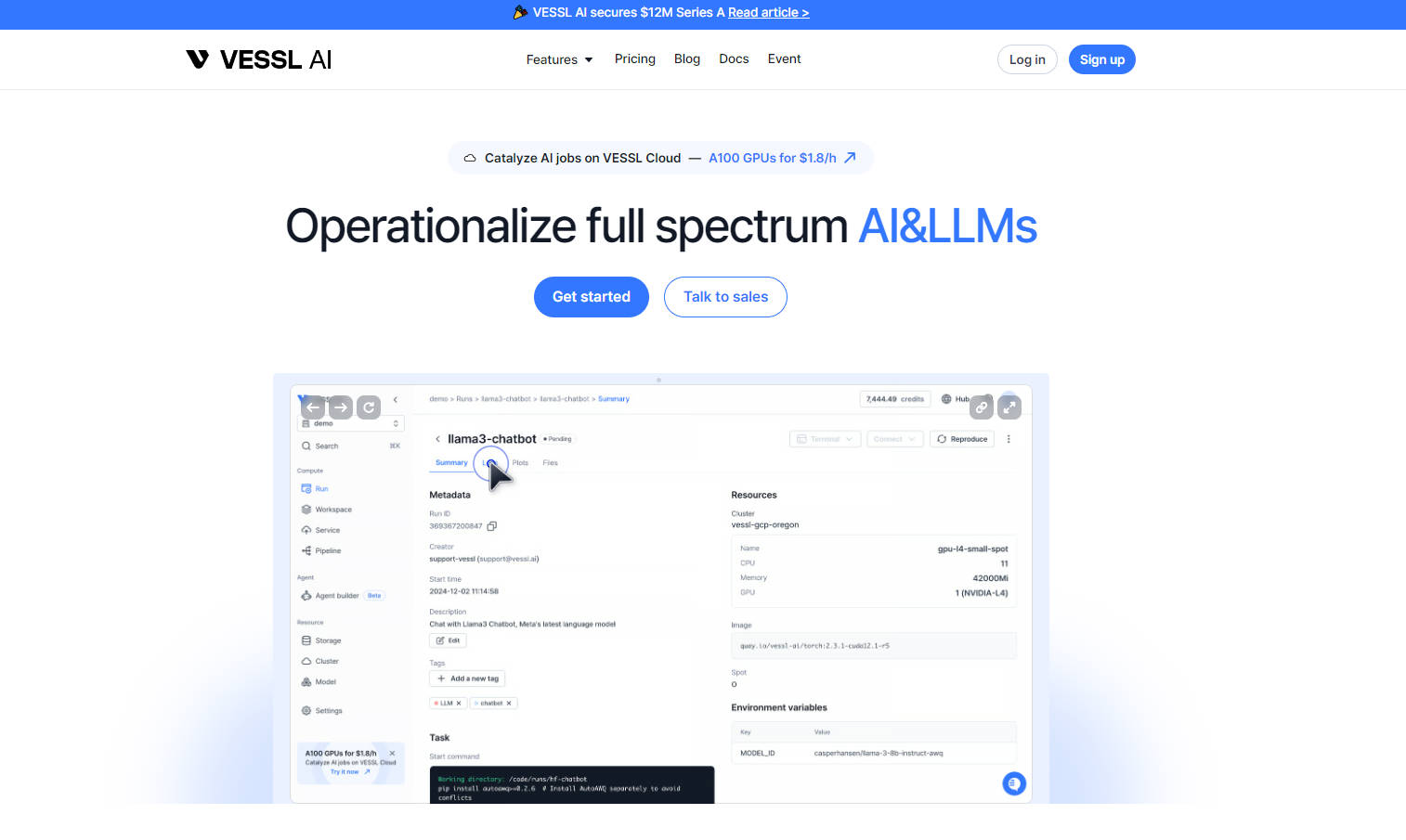

What is Vessl AI?

VESSL AIは、人工知能(AI)モデルの開発、トレーニング、デプロイを加速させる包括的な機械学習運用(MLOps)プラットフォームを提供します。複数のクラウド環境にまたがるAIワークロードを管理するための統一インターフェースを提供します。このプラットフォームは複雑なインフラストラクチャ管理を簡素化し、ユーザーは運用上のオーバーヘッドではなく、イノベーションに集中できます。主な機能には、サーバーレスデプロイ、自動化されたワークフロー、リアルタイムモニタリング、そして一般的なツールやフレームワークとのシームレスな統合が含まれます。

主な機能

Hub?:ゼロセットアップでオープンソースモデルにアクセスし、微調整できます。VESSL Hubから事前設定されたテンプレートを使用して、さまざまなAIワークロードを簡単にデプロイできます。

Run⚡:単一のコマンドで複数のクラウドにまたがって機械学習モデルをトレーニングします。バッチジョブのスケジューリング、自動フェイルオーバー、そして秒単位課金とスポットインスタンスによるコスト最適化のメリットを得られます。

Service⚙️:永続的なエンドポイントを使用してモデルをサーバーレスでデプロイし、トラフィックに基づいた自動スケーリングを保証します。GPU使用率、レイテンシ、スループットなどのリアルタイムメトリクスを監視します。

Cluster?️:クラウドプロバイダーとオンプレミスクラスター全体で統一されたインターフェースを活用します。リソース仕様をカスタマイズし、ワークロードの優先順位を付けて最適な効率を実現します。

Pipelines?:エンドツーエンドの継続的インテグレーションと継続的デリバリー(CI/CD)でAIワークフローを自動化します。cronジョブを簡単に管理し、複雑な機械学習ワークフローのデバッグ可能性を確保します。

ユースケース

学術研究:KAISTは、200名以上の機械学習研究者に1,000台以上のGPUを提供するためにVESSL AIを活用しています。VESSL AIにより、研究者はGPUリソースに容易にアクセスして利用できるようになり、共同研究を促進し、研究プロジェクトを加速させています。SNUもGPUクラスタのプロビジョニングとfastMRIチャレンジのホスティングにVESSL AIを活用しています。

大規模言語モデルのファインチューニング:Scatter Labは、大規模言語モデルのファインチューニングのプロセスを簡素化するためにVESSL AIを使用しています。VESSL AIの直感的なインターフェースと強力な機能により、開発時間とリソースを削減できます。

自動運転開発:現代自動車は、VESSL AIを使用してさまざまな地域から100TBを超えるデータを統合し、データパイプラインを合理化しています。VESSL AIは、モデルのデプロイ時間を5か月から1週間に短縮し、自動運転技術の開発を大幅に加速させました。

結論

VESSL AIは、AIワークロードを管理するための強力でユーザーフレンドリーなプラットフォームを提供します。VESSL AIは複雑なタスクを簡素化し、リソースの使用を最適化することで、ユーザーはクラウドコストを最大80%削減できます。包括的な機能とシームレスな統合機能により、AI開発プロセスを合理化し、より迅速で効率的な結果を実現したいチームにとって理想的な選択肢となります。