What is Ollama Docker?

Погружайтесь в будущее разработки ИИ с Ollama Docker - передовым контейнеризированным окружением, призванным оптимизировать ваши развертывания и предоставить вам ускорение на графических процессорах. Разработанный с учетом простоты настройки, универсальных возможностей разработки и интуитивно понятного веб-интерфейса, Ollama Docker выводит ваш рабочий процесс на новый уровень, обеспечивая более быструю и эффективную обработку задач и бесшовную интеграцию с вашими проектами.

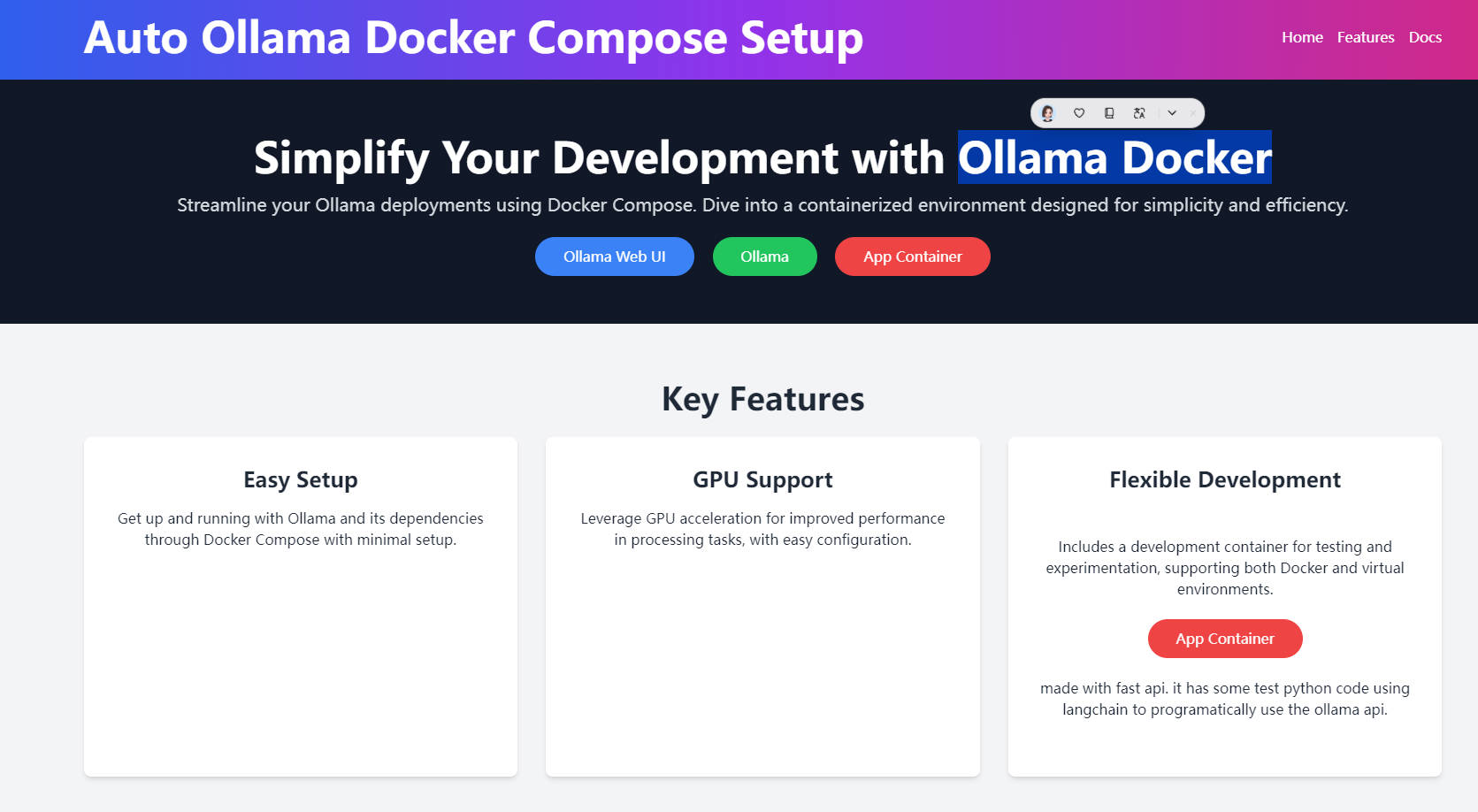

Ключевые функции:

Простая настройка: С помощью Docker Compose развертывание Ollama и его зависимостей становится простым делом, гарантируя, что ваша система будет запущена с минимальными усилиями.

Поддержка графических процессоров: Испытайте повышение производительности при обработке задач благодаря интеграции ускорения на графических процессорах, которое можно легко настроить с помощью NVIDIA Container Toolkit.

Гибкая разработка: Специальный контейнер поддерживает ваши потребности в разработке, предоставляя среду для тестирования и экспериментов, независимо от того, предпочитаете ли вы Docker или виртуальные среды.

Контейнер приложения, оптимизированный для Fast API: Этот контейнер, построенный с использованием FastAPI, включает тестовый код Python с использованием Langchain для программного подхода к использованию API Ollama, что облегчает быстрое экспериментирование и разработку.

Сценарии использования:

Быстрая разработка приложений ИИ: Разработчики могут быстро создавать прототипы приложений ИИ с использованием предварительно обученных моделей Ollama, ускоряя цикл разработки.

Научные исследования в области ИИ: Университеты могут использовать Ollama Docker, чтобы предоставить студентам среды с ускорением на графических процессорах, повышая возможности обучения и исследований в области ИИ.

Облачное тестирование ИИ: Компании могут использовать Ollama Docker для развертывания моделей ИИ в облаке для тестирования и оценки без необходимости локальной инфраструктуры графических процессоров.

Заключение:

Ollama Docker является краеугольным камнем эффективной разработки ИИ, предоставляя бесшовную, поддерживающую графические процессоры и удобную для разработки среду. Независимо от того, являетесь ли вы разработчиком, стремящимся ускорить создание приложений ИИ, или преподавателем, стремящимся улучшить учебные программы по ИИ, Ollama Docker - ваш ключ к разблокировке новых возможностей. Начните изучать его возможности уже сегодня и трансформируйте свой подход к работе с ИИ.

Часто задаваемые вопросы:

Вопрос: Что предлагает Ollama Docker разработчикам, интересующимся ИИ?

Ответ: Ollama Docker предоставляет готовую к использованию среду для разработки ИИ, отличающуюся простотой настройки, поддержкой графических процессоров и гибким контейнером разработки, оптимизированным для тестирования и экспериментов, ускоряя процесс разработки ИИ.

Вопрос: Могу ли я использовать Ollama Docker в образовательных целях?

Ответ: Безусловно, Ollama Docker - отличный инструмент для образовательных учреждений, предлагающий среды с ускорением на графических процессорах, которые повышают обучение и исследования в области ИИ для студентов и преподавателей.

Вопрос: Как Ollama Docker поддерживает облачное тестирование ИИ?

Ответ: С помощью Ollama Docker вы можете развертывать модели ИИ в облаке для тестирования, минуя необходимость локальной инфраструктуры графических процессоров, что делает его идеальным для компаний, которые хотят оценить модели ИИ масштабируемым и ресурсоэффективным образом.

More information on Ollama Docker

Top 5 Countries

Traffic Sources

Ollama Docker Альтернативи

Больше Альтернативи-

-

-

Oumi — это полностью открытая платформа, которая оптимизирует весь жизненный цикл фундаментальных моделей — от подготовки данных и обучения до оценки и развертывания. Независимо от того, разрабатываете ли вы модели на ноутбуке, запускаете крупномасштабные эксперименты на кластере или внедряете модели в промышленную эксплуатацию, Oumi предоставляет необходимые инструменты и рабочие процессы.

-

-

Kolosal AI — это открытая платформа, позволяющая запускать большие языковые модели (LLM) локально на устройствах, таких как ноутбуки, настольные компьютеры и даже Raspberry Pi, с приоритетом на скорость, эффективность, конфиденциальность и экологичность.