What is HelixML?

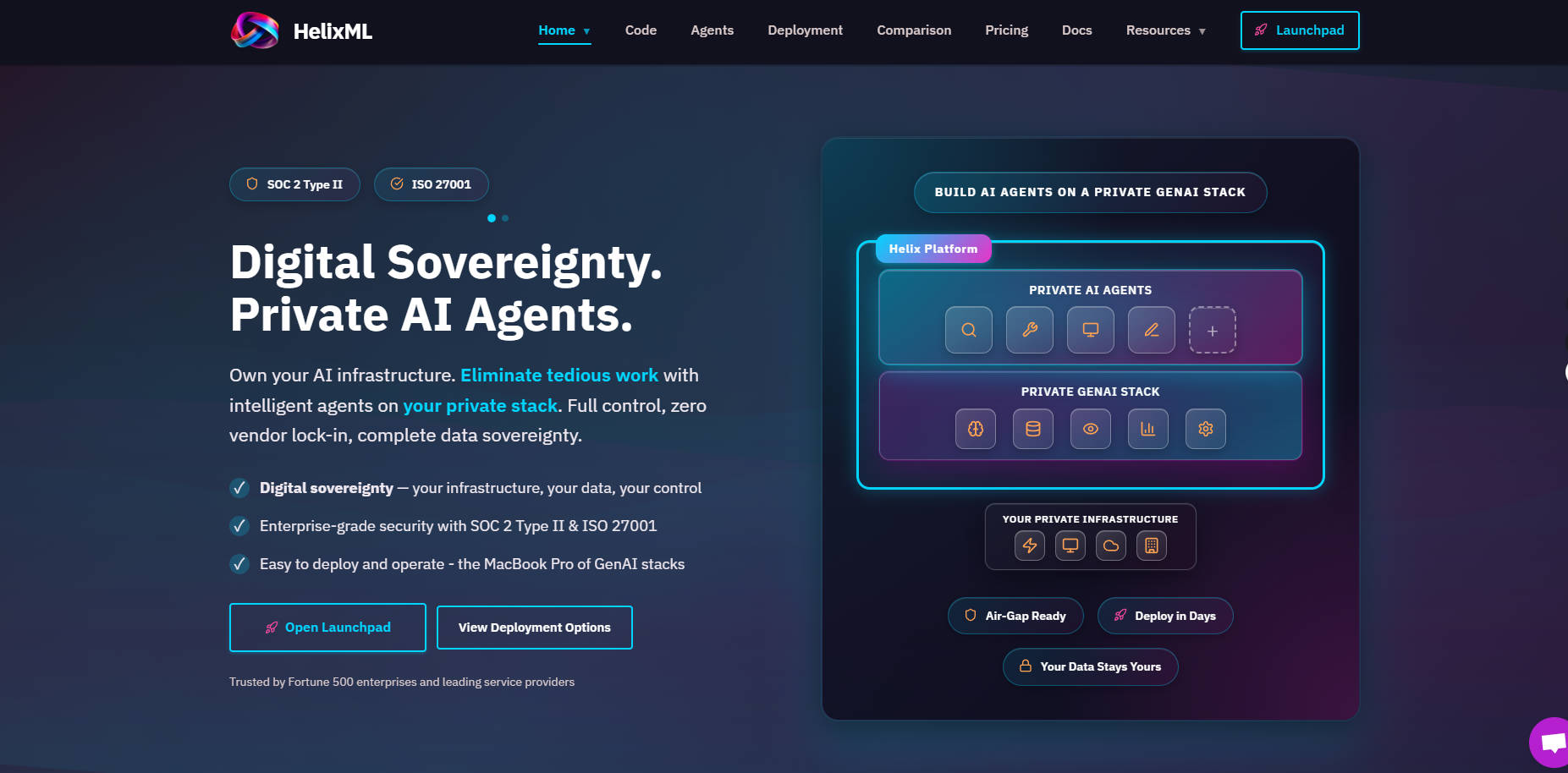

HelixML是一个企业级平台,旨在大规模构建、部署和管理复杂的AI代理和应用程序。它通过允许部署在您自己的数据中心或虚拟私有云(VPC)中,解决了数据安全和合规性的关键需求,确保组织对您的生成式AI堆栈和敏感数据拥有完全控制权。开发人员只需在声明式的helix.yaml配置文件中定义需求,即可快速创建复杂、上下文感知和多步骤推理的应用程序。

主要功能

HelixML提供了一个健壮、可观测且高度可定制的基础设施,专为专业的AI开发和部署而设计。

🤖 高级AI代理编排

Helix提供了一种基于会话的架构,支持多步骤推理和复杂的工具编排,使代理能够处理超越简单聊天的复杂任务。代理利用全面的内存管理,在整个交互过程中保持上下文,确保对话流程高度相关且连贯。

📚 企业知识管理(RAG)

超越基本的上下文注入。Helix内置了用于企业文档(PDF、Word)的摄取工具,以及用于外部内容的网页抓取工具。它支持多种RAG后端(包括Typesense、Haystack和PGVector),并整合了视觉RAG支持,用于集成和搜索多模态内容,从而最大化代理响应的深度和准确性。

⚙️ 智能资源调度

借助专为提高效率而设计的智能GPU调度器,优化您的硬件投资。该系统根据需求动态加载和卸载模型,并有效地将它们打包到可用的GPU内存中,与静态部署相比,显著提高了资源利用率并降低了运营成本。

🔍 完整追踪与可观测性

由于代理通常每一步处理数万个tokens并与外部系统交互,Helix提供了对每个执行步骤的完整、实时可见性。您可以检查对LLM提供商和第三方API的请求和响应,跟踪实时token使用情况,并在追踪界面中直接执行成本分析和性能调试。

🛠️ 无缝工具与API集成

通过强大的工具集成,赋予代理真实世界的能力。Helix支持使用OpenAPI schemas进行REST API集成,通过OAuth token管理实现安全的第三方访问,并通过集成的GPTScript实现高级脚本编写,使代理能够在您现有的企业生态系统中执行复杂的真实世界操作。

应用场景

HelixML旨在解决企业中复杂、数据敏感的问题,将原始数据转化为可操作的智能和自动化。

内部知识库分析: 上传大量的内部公司文档、合规指南和技术规范。部署一个内部代理,该代理利用Vision RAG分析文本、图表和示意图,为员工查询提供即时、准确的答案,同时不损害专有数据安全。

自动化客户支持代理: 通过提供网站文档URL和摄取支持工单,即时构建知识库。部署一个面向客户的代理,该代理能够智能地回答复杂问题,减轻人工支持团队的负担,同时保持高质量、最新的响应。

事件驱动型工作流自动化: 利用webhook触发器、计划任务和API绑定,创建主动式代理。例如,部署一个代理,该代理监控系统日志(通过webhooks),对不同API进行多步骤分析,并根据发现自动生成摘要报告或启动修复脚本。

为何选择HelixML?

选择HelixML意味着在您的生成式AI战略中优先考虑安全性、控制和效率。我们为关键任务应用程序提供了必要的架构深度。

保证数据安全与主权: 与托管云服务不同,Helix设计用于部署在您自己的数据中心或VPC中。这种架构确保所有数据、提示和推理结果都保留在您的安全边界内,满足严格的监管和合规性要求。

最大运营效率: 微服务架构和智能GPU模型调度器协同工作,确保您的计算资源得到最佳利用。这种动态方法最大限度地减少了GPU空闲时间,并在可变负载下高效扩展,从而大幅节约成本。

LLM提供商无关的灵活性: Helix支持主要的商业LLM提供商(OpenAI、Anthropic)以及本地、自托管模型。这种多提供商能力使您的应用程序面向未来,允许您根据性能、成本和可用性轻松切换或组合模型,而无需重建您的核心代理逻辑。

总结

HelixML提供了您所需的安全基础和复杂工具,助您超越基本的LLM封装,部署真正的企业级AI代理。利用其声明式配置、深度可观测性和私有架构,自信地构建强大、上下文感知的解决方案,并拥有完全的控制权。

立即探索HelixML如何帮助您确保下一代AI应用程序的安全并实现规模化。

More information on HelixML

Top 5 Countries

Traffic Sources

HelixML 替代

HelixML 替代-

使用 HelixML 构建私有生成式 AI 应用。通过我们的自托管平台掌控您的数据和模型。您可以选择在本地、VPC 或我们的云上进行部署。

-

-

Helicone AI Gateway: 统一并优化您的LLM API,为生产环境提供强大支持。借助智能路由与缓存,助您显著提升性能、大幅降低成本,并确保系统稳定可靠。

-

TaskingAI 为 AI 原生应用开发带来了 Firebase 的简洁体验。开启项目,只需选定一个 LLM 模型;构建响应式助手,则有状态 API 保驾护航;更可通过托管内存、工具集成和增强生成系统,让助手功能如虎添翼。

-

LlamaIndex 助力您基于企业数据构建智能AI智能体。通过先进的RAG技术,为LLMs赋能,将复杂文档转化为可靠、可操作的洞察。