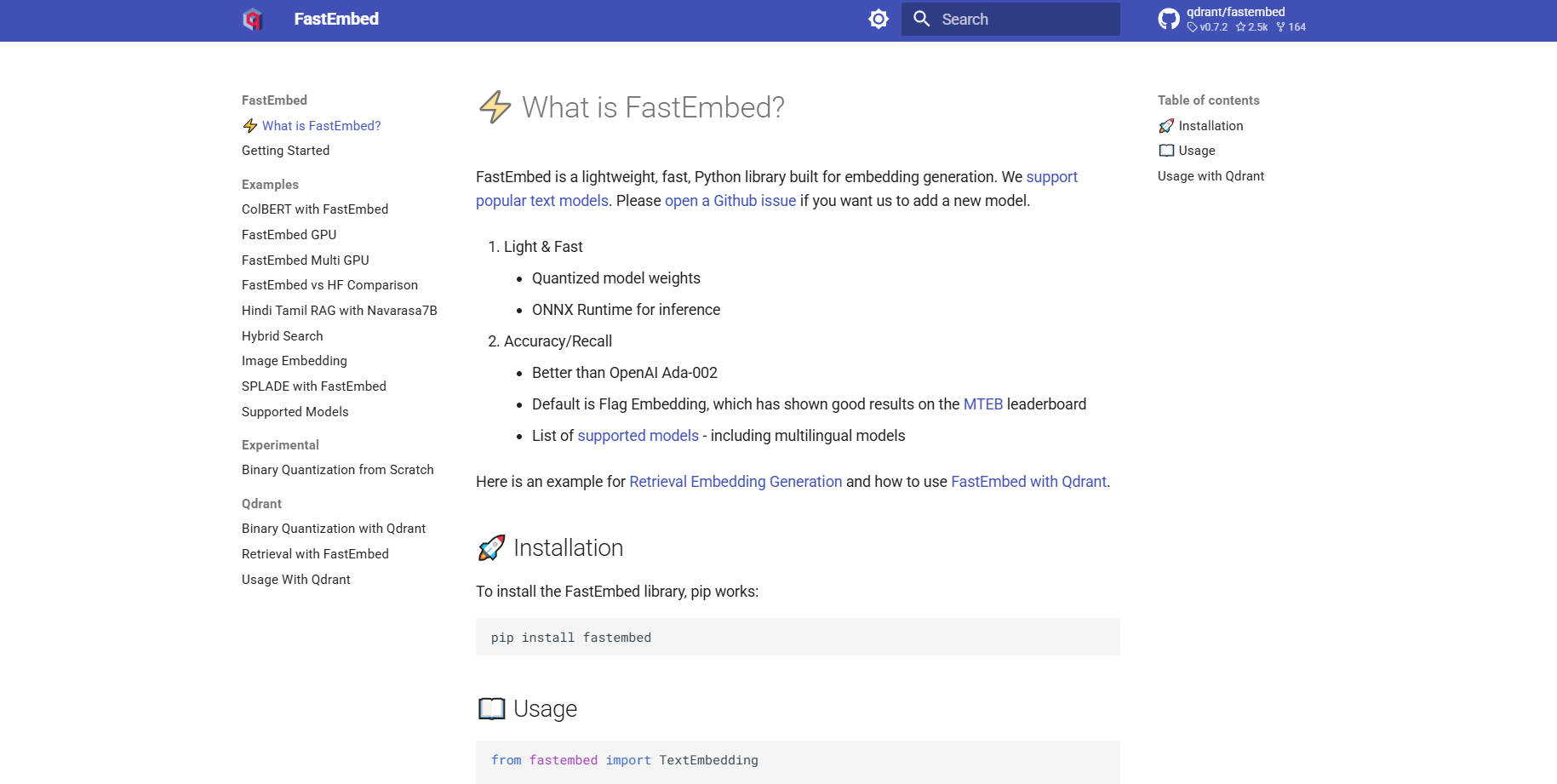

What is FastEmbed?

FastEmbed es una biblioteca Python potente, pero sorprendentemente ligera, diseñada específicamente para la generación de embeddings de alta velocidad y precisión a través de diversas modalidades. Resuelve los problemas comunes de rendimiento y la excesiva carga de dependencias asociados con las bibliotecas de deep learning tradicionales, aprovechando la eficiencia de ONNX Runtime. Diseñada para desarrolladores y equipos de MLOps, FastEmbed entrega rápidamente embeddings vectoriales listos para producción, convirtiéndola en la base ideal para construir sistemas robustos de Generación Aumentada por Recuperación (RAG) y aplicaciones serverless eficientes.

Características Principales

FastEmbed está diseñada para manejar la complejidad de las pipelines RAG modernas, ofreciendo un soporte robusto para diversos tipos de embeddings y técnicas de optimización, al mismo tiempo que mantiene una huella mínima.

⚡️ Embeddings de Texto Optimizados (Densos y Dispersos)

FastEmbed ofrece soporte para la generación de vectores densos utilizando modelos de texto populares, siendo Flag Embedding de alto rendimiento la opción predeterminada. Fundamentalmente, también soporta embeddings dispersos como SPLADE++, lo que le brinda la flexibilidad de elegir la estrategia de recuperación óptima —ya sea enfocándose en la similitud semántica de alta densidad o en la coincidencia eficiente de palabras clave— y permite una integración sin fisuras de modelos personalizados.

🖼️ Soporte Multimodal Integral

Expanda sus capacidades de recuperación más allá del texto. FastEmbed incorpora soporte especializado para la generación de embeddings de imágenes (por ejemplo, usando modelos CLIP) y modelos multimodales avanzados de interacción tardía (ColPali). Esto le permite unificar la indexación a través de imágenes y consultas de texto, posibilitando una búsqueda multimodal compleja dentro de un único marco de trabajo.

🚀 Aceleración del Rendimiento a través de ONNX Runtime

A diferencia de las bibliotecas que dependen de las pesadas dependencias de PyTorch, FastEmbed utiliza el optimizado ONNX Runtime. Esta elección técnica reduce drásticamente el tamaño de la biblioteca, minimiza las dependencias externas y acelera la velocidad de ejecución, asegurando una inicialización más rápida y un rendimiento superior en comparación con las pipelines de embeddings convencionales.

⚙️ Modelos de Reordenamiento e Interacción Integrados

Mejore la precisión de sus resultados de búsqueda utilizando la utilidad integrada TextCrossEncoder, que soporta modelos de reordenamiento de última generación. Además, la biblioteca soporta Modelos de Interacción Tardía (como ColBERT), lo que permite una puntuación más matizada y consciente del contexto entre consultas y pasajes recuperados post-recuperación.

📈 Paralelismo de Datos Escalable

Para usuarios que manejan conjuntos de datos masivos, FastEmbed emplea automáticamente el paralelismo de datos al codificar grandes lotes de texto. Esta característica garantiza un procesamiento de alto rendimiento y una utilización eficiente de los recursos disponibles, acelerando significativamente las fases iniciales de vectorización e indexación de proyectos a gran escala.

Casos de Uso

FastEmbed está optimizada para entornos donde el rendimiento, el tamaño y la precisión no pueden verse comprometidos.

1. Despliegue Serverless de Alta Eficiencia

La arquitectura ligera de FastEmbed y su dependencia de ONNX Runtime la convierten en una excelente candidata para entornos serverless, como AWS Lambda. Puede desplegar servicios de generación de embeddings como microservicios sin preocuparse por paquetes de dependencias de varios gigabytes, asegurando arranques en frío rápidos y una escalabilidad rentable.

2. Indexación Rápida para Sistemas RAG Empresariales

Al migrar o actualizar una gran base de conocimiento corporativa, la velocidad es esencial. Utilice las capacidades de paralelismo de datos de FastEmbed para codificar rápidamente millones de documentos en vectores. Al integrarse directamente con bases de datos vectoriales (como el cliente Qdrant), puede poblar rápidamente colecciones con embeddings optimizados y de alta calidad, acelerando el tiempo de despliegue para sus aplicaciones RAG.

3. Búsqueda Multimodal Avanzada

Si su aplicación requiere buscar en documentos que contienen tanto texto como imágenes (por ejemplo, manuales técnicos o catálogos de productos), FastEmbed proporciona las herramientas necesarias. Aproveche los modelos ColPali para generar embeddings distintos, pero relacionados, para datos visuales y textuales, posibilitando consultas sofisticadas que abarcan ambas modalidades para ofrecer resultados altamente relevantes.

¿Por qué elegir FastEmbed?

FastEmbed es mantenida por Qdrant y construida específicamente para superar los cuellos de botella comunes a los que se enfrentan los desarrolladores que crean aplicaciones de búsqueda vectorial listas para producción.

Eficiencia Inigualable (Huella Ligera): FastEmbed evita la pesada carga de dependencias de los frameworks de deep learning típicos. Al utilizar ONNX Runtime y requerir pocos paquetes externos, reduce drásticamente el tamaño de la biblioteca, haciéndola altamente portable e ideal para entornos con recursos limitados.

Velocidad y Rendimiento Superiores: Aprovechando ONNX y el paralelismo de datos optimizado, FastEmbed está diseñada para la velocidad. Este enfoque en el rendimiento se traduce directamente en tiempos de respuesta de consulta más rápidos y un mayor rendimiento para el procesamiento por lotes, ahorrando un tiempo computacional valioso.

Precisión Probada y Diversidad de Modelos: FastEmbed soporta un conjunto de modelos de alta calidad en constante expansión, incluyendo opciones multilingües. Fundamentalmente, sus modelos predeterminados están evaluados para ofrecer una precisión superior a las bases comerciales establecidas, como OpenAI Ada-002, asegurando que sus sistemas de recuperación se construyan sobre datos semánticos precisos.

Integración Lista para Producción: Con soporte opcional para aceleración GPU (a través de

fastembed-gpu) y una integración fluida y respaldada con Qdrant, Langchain y Llama Index, FastEmbed está lista para ser desplegada como un componente central de la infraestructura de IA de nivel empresarial.

Conclusión

FastEmbed proporciona el equilibrio crítico de velocidad, tamaño y precisión requerido para las aplicaciones modernas de búsqueda vectorial y RAG. Al optimizar el rendimiento a través de ONNX Runtime y ofrecer un soporte robusto para diversos modelos y modalidades, simplifica la pipeline de embeddings y asegura resultados fiables y de alta calidad.

More information on FastEmbed

FastEmbed Alternativas

Más Alternativas-

Embedchain: El *framework* RAG de código abierto diseñado para simplificar la creación y el despliegue de aplicaciones LLM personalizadas. Pasa del prototipo a la producción con facilidad y control.

-

Snowflake Arctic embed: Incrustaciones de texto de código abierto de alto rendimiento y eficientes para RAG y búsqueda semántica. Mejoran la precisión de la IA y reducen los costos.

-

EmbeddingGemma: Incrustaciones de texto multilingües directamente en el dispositivo para aplicaciones de IA que priorizan la privacidad. Obtén un rendimiento y una eficiencia de primera clase, incluso sin conexión.

-

Superlinked es un framework de Python para ingenieros de IA que desarrollan aplicaciones de búsqueda y recomendación de alto rendimiento que combinan datos estructurados y no estructurados.

-

Infinity es una base de datos nativa de IA de vanguardia que ofrece una amplia gama de capacidades de búsqueda para tipos de datos enriquecidos como vector denso, vector disperso, tensor, texto completo y datos estructurados. Ofrece un sólido soporte para diversas aplicaciones de LLM, incluyendo búsqueda, sistemas de recomendación, respuesta a preguntas, IA conversacional, copilot, generación de contenido, y muchas más aplicaciones RAG (Retrieval-augmented Generation).