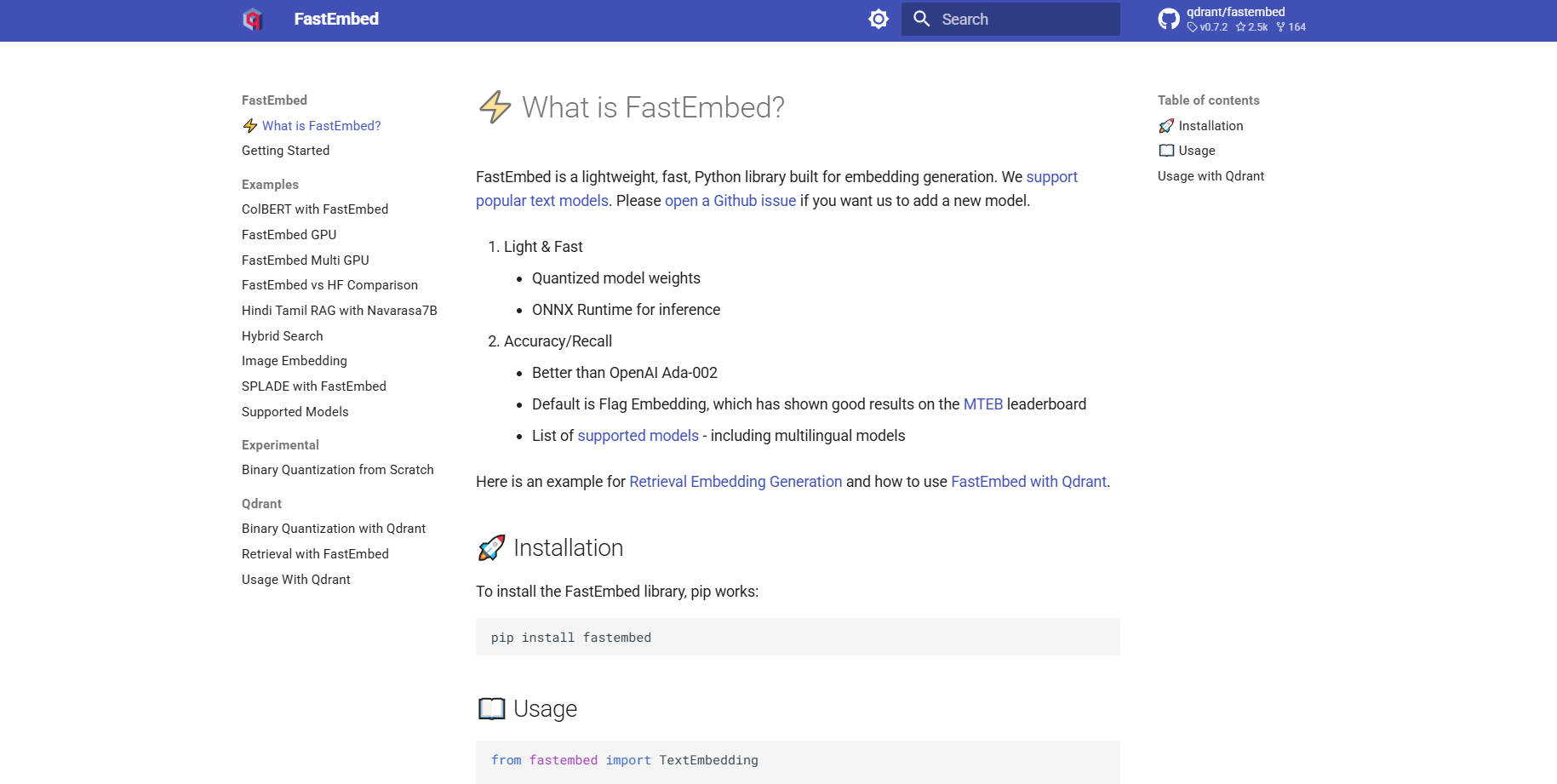

What is FastEmbed?

FastEmbed — это мощная, но при этом удивительно легковесная библиотека Python, разработанная специально для высокоскоростного и точного генерирования эмбеддингов в различных модальностях. Она решает распространённые проблемы производительности и раздувания зависимостей, характерные для традиционных библиотек глубокого обучения, за счёт использования эффективного ONNX Runtime. Разработанная для разработчиков и команд MLOps, FastEmbed быстро предоставляет готовые к производству векторные эмбеддинги, что делает её идеальной основой для создания надёжных систем Retrieval-Augmented Generation (RAG) и эффективных бессерверных приложений.

Ключевые особенности

FastEmbed спроектирована для работы со сложностью современных конвейеров RAG, предлагая надёжную поддержку различных типов эмбеддингов и методов оптимизации при сохранении минимального объёма.

⚡️ Оптимизированные текстовые эмбеддинги (плотные и разреженные)

FastEmbed обеспечивает поддержку генерации плотных векторов с использованием популярных текстовых моделей, при этом высокопроизводительный Flag Embedding служит выбором по умолчанию. Что особенно важно, она также поддерживает разреженные эмбеддинги, такие как SPLADE++, предоставляя вам гибкость в выборе оптимальной стратегии поиска — будь то акцент на высокоплотном семантическом сходстве или эффективном сопоставлении по ключевым словам — и позволяет бесшовно интегрировать пользовательские модели.

🖼️ Комплексная мультимодальная поддержка

Расширьте свои возможности поиска за пределы текста. FastEmbed включает специализированную поддержку для генерации эмбеддингов изображений (например, с использованием моделей CLIP) и передовых мультимодальных моделей с поздним взаимодействием (ColPali). Это позволяет унифицировать индексацию изображений и текстовых запросов, обеспечивая сложный мультимодальный поиск в рамках единой среды.

🚀 Ускорение производительности через ONNX Runtime

В отличие от библиотек, которые полагаются на тяжёлые зависимости PyTorch, FastEmbed использует оптимизированный ONNX Runtime. Это техническое решение значительно уменьшает размер библиотеки, минимизирует внешние зависимости и ускоряет скорость выполнения, обеспечивая более быструю инициализацию и превосходную пропускную способность по сравнению с обычными конвейерами эмбеддингов.

⚙️ Встроенные модели переранжирования и взаимодействия

Повысьте точность результатов поиска с помощью встроенной TextCrossEncoder утилиты, которая поддерживает современные модели переранжирования. Кроме того, библиотека поддерживает модели с поздним взаимодействием (например, ColBERT), что позволяет более тонко и контекстуально оценивать соответствие между запросами и найденными фрагментами после извлечения.

📈 Масштабируемый параллелизм данных

Для пользователей, работающих с обширными наборами данных, FastEmbed автоматически применяет параллелизм данных при кодировании больших пакетов текста. Эта функция обеспечивает высокопроизводительную обработку и эффективное использование доступных ресурсов, значительно ускоряя этапы первоначальной векторизации и индексации в крупномасштабных проектах.

Варианты использования

FastEmbed оптимизирована для сред, где производительность, размер и точность не могут быть скомпрометированы.

1. Высокоэффективное бессерверное развёртывание

Легковесная архитектура FastEmbed и её опора на ONNX Runtime делают её отличным кандидатом для бессерверных сред, таких как AWS Lambda. Вы можете развёртывать сервисы генерации эмбеддингов как микросервисы, не беспокоясь о многогигабайтных пакетах зависимостей, что обеспечивает быстрый «холодный» старт и экономически эффективное масштабирование.

2. Быстрая индексация для корпоративных RAG-систем

При миграции или обновлении крупной корпоративной базы знаний требуется скорость. Используйте возможности параллелизма данных FastEmbed для быстрой кодировки миллионов документов в векторы. Интегрируясь напрямую с векторными базами данных (например, с клиентом Qdrant), вы можете быстро заполнять коллекции высококачественными, оптимизированными эмбеддингами, ускоряя время до развёртывания ваших RAG-приложений.

3. Расширенный мультимодальный поиск

Если ваше приложение требует поиска по документам, содержащим как текст, так и изображения (например, технические руководства или каталоги продуктов), FastEmbed предоставляет необходимые инструменты. Используйте модели ColPali для генерации различных, но связанных эмбеддингов для визуальных и текстовых данных, что позволяет выполнять сложные запросы, охватывающие обе модальности, и получать высокорелевантные результаты.

Почему стоит выбрать FastEmbed?

FastEmbed поддерживается Qdrant и создана специально для преодоления общих узких мест, с которыми сталкиваются разработчики при создании готовых к производству приложений векторного поиска.

Непревзойдённая эффективность (легковесность): FastEmbed избегает тяжёлой нагрузки зависимостей, характерной для обычных фреймворков глубокого обучения. Используя ONNX Runtime и требуя минимум внешних пакетов, она значительно уменьшает размер библиотеки, делая её легко переносимой и идеальной для сред с ограниченными ресурсами.

Превосходная скорость и пропускная способность: Благодаря ONNX и оптимизированному параллелизму данных, FastEmbed разработана для высокой скорости. Этот акцент на производительности напрямую выражается в более быстром времени отклика на запросы и более высокой пропускной способности при пакетной обработке, экономя ценное вычислительное время.

Доказанная точность и разнообразие моделей: FastEmbed поддерживает постоянно расширяющийся набор высококачественных моделей, включая мультиязычные варианты. Что особенно важно, её стандартные модели по результатам бенчмарков демонстрируют точность, превосходящую признанные коммерческие эталоны, такие как OpenAI Ada-002, гарантируя, что ваши системы поиска будут построены на точных семантических данных.

Готовность к производственной интеграции: Благодаря опциональной поддержке ускорения GPU (через

fastembed-gpu) и бесшовной, поддерживаемой интеграции с Qdrant, Langchain и Llama Index, FastEmbed готова к развёртыванию в качестве основного компонента AI-инфраструктуры корпоративного уровня.

Заключение

FastEmbed обеспечивает критически важный баланс скорости, размера и точности, необходимый для современных приложений векторного поиска и RAG. Оптимизируя производительность через ONNX Runtime и предлагая надёжную поддержку разнообразных моделей и модальностей, она упрощает конвейер эмбеддингов и гарантирует надёжные, высококачественные результаты.

More information on FastEmbed

FastEmbed Альтернативи

Больше Альтернативи-

Embedchain: Открытый RAG-фреймворк, упрощающий создание и развертывание персонализированных LLM-приложений. Переходите от прототипа к продакшену с легкостью и полным контролем.

-

Эмбеддинги Snowflake Arctic: Высокопроизводительные, эффективные текстовые эмбеддинги с открытым исходным кодом для RAG и семантического поиска. Повысьте точность ИИ и сократите расходы.

-

EmbeddingGemma: Локальные многоязычные текстовые эмбеддинги для ИИ-приложений, ориентированных на конфиденциальность. Обеспечивают лучшую в своем классе производительность и эффективность, даже офлайн.

-

Superlinked — это фреймворк на Python для AI-инженеров, создающих высокопроизводительные приложения для поиска и рекомендаций, объединяющие структурированные и неструктурированные данные.

-

Infinity — это передовая нативная для ИИ база данных, которая предлагает широкий спектр поисковых возможностей для разнообразных типов данных, таких как плотные векторы, разреженные векторы, тензоры, полнотекстовые и структурированные данные. Она обеспечивает мощную поддержку для различных LLM-приложений, включая поиск, рекомендательные системы, ответы на вопросы, диалоговый ИИ, Copilot, генерацию контента и многие другие RAG-приложения (Retrieval-augmented Generation).