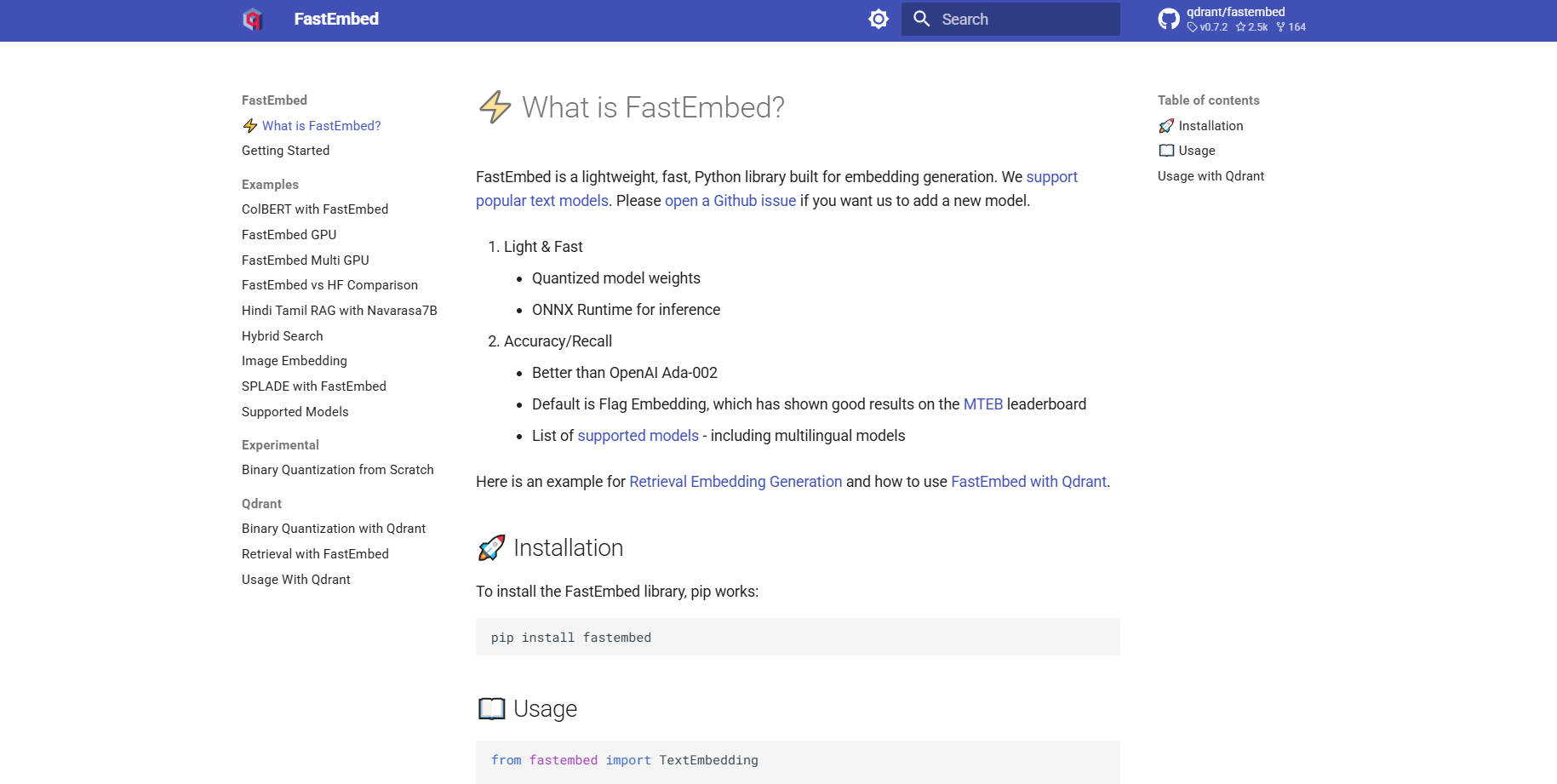

What is FastEmbed?

FastEmbed 是一个功能强大但又极其轻量级的 Python 库,专为跨多种模态的高速、准确嵌入生成而设计。它通过利用高效的 ONNX Runtime,解决了传统深度学习库常见的性能瓶颈和依赖膨胀问题。FastEmbed 专为开发者和 MLOps 团队打造,能够快速生成可用于生产环境的向量嵌入,是构建强大检索增强生成 (RAG) 系统和高效无服务器应用的理想基础。

主要特性

FastEmbed 旨在应对现代 RAG 管道的复杂性,提供对各种嵌入类型和优化技术的强大支持,同时保持极小的资源占用。

⚡️ 优化的文本嵌入(稠密与稀疏)

FastEmbed 支持使用流行的文本模型生成稠密向量,其中高性能的 Flag Embedding 是默认首选。更重要的是,它还支持 SPLADE++ 等稀疏嵌入,让您能够灵活选择最佳的检索策略——无论是侧重于高密度语义相似性还是高效的关键词匹配——并支持无缝集成自定义模型。

🖼️ 全面多模态支持

将您的检索能力扩展到文本之外。FastEmbed 集成了生成图像嵌入(例如,使用 CLIP 模型)和先进的后期交互多模态模型 (ColPali) 的专业支持。这使得您可以在图像和文本查询之间统一索引,从而在单一框架内实现复杂的多模态搜索。

🚀 通过 ONNX Runtime 加速性能

与依赖繁重 PyTorch 的库不同,FastEmbed 利用了精简的 ONNX Runtime。这一技术选择显著减小了库的体积,最大程度地减少了外部依赖,并加速了执行速度,与传统的嵌入管道相比,确保了更快的初始化和卓越的吞吐量。

⚙️ 内置重排和交互模型

使用集成的 TextCrossEncoder 工具提升搜索结果的精确度,该工具支持最先进的重排模型。此外,该库还支持后期交互模型(如 ColBERT),可在检索后对查询和检索到的段落进行更细致、上下文感知的评分。

📈 可伸缩的数据并行

对于处理海量数据集的用户,FastEmbed 在编码大量文本批次时会自动采用数据并行机制。此特性确保了高吞吐量处理和可用资源的有效利用,从而显著加快了大规模项目的初始向量化和索引阶段。

应用场景

FastEmbed 针对那些对性能、体积和准确性要求严苛的环境进行了优化。

1. 高效无服务器部署

FastEmbed 轻量级的架构以及对 ONNX Runtime 的依赖,使其成为 AWS Lambda 等无服务器环境的绝佳选择。您可以以微服务的形式部署嵌入生成服务,无需担心多 GB 级别的依赖包,从而确保快速冷启动和经济高效的扩展。

2. 企业级 RAG 系统的快速索引

在迁移或更新大型企业知识库时,速度至关重要。利用 FastEmbed 的数据并行能力,可以快速将数百万份文档编码为向量。通过与向量数据库(如 Qdrant 客户端)直接集成,您可以快速填充包含高质量、优化嵌入的集合,从而加速 RAG 应用的部署时间。

3. 高级多模态搜索

如果您的应用需要搜索包含文本和图像的文档(例如技术手册或产品目录),FastEmbed 提供了必要的工具。利用 ColPali 模型为视觉和文本数据生成独特而又关联的嵌入,从而实现跨两种模态的复杂查询,以提供高度相关的结果。

为何选择 FastEmbed?

FastEmbed 由 Qdrant 维护,专门为解决开发者在构建可用于生产环境的向量搜索应用时遇到的常见瓶颈而设计。

无与伦比的效率(轻量级占用): FastEmbed 避免了典型深度学习框架的沉重依赖负担。通过使用 ONNX Runtime 并仅需要少量外部软件包,它显著减小了库的体积,使其高度便携,是资源受限环境的理想选择。

卓越的速度和吞吐量: 凭借 ONNX 和优化的数据并行技术,FastEmbed 专为高速运行而设计。这种对性能的专注直接转化为更快的查询响应时间以及更高的批处理吞吐量,从而节省了宝贵的计算时间。

经验证的准确性和模型多样性: FastEmbed 支持不断扩展的高质量模型集,包括多语言选项。至关重要的是,其默认模型经过基准测试,可提供优于 OpenAI Ada-002 等成熟商业基线的准确性,确保您的检索系统建立在精确的语义数据之上。

生产级集成: 凭借对 GPU 加速的可选支持(通过

fastembed-gpu),以及与 Qdrant、Langchain 和 Llama Index 的无缝且受支持的集成,FastEmbed 已准备好作为企业级 AI 基础设施的核心组件进行部署。

结论

FastEmbed 提供了现代向量搜索和 RAG 应用所需的关键平衡点:速度、体积和准确性。通过 ONNX runtime 优化性能,并为多样化的模型和模态提供强大支持,它简化了嵌入管道,确保了可靠、高质量的结果。