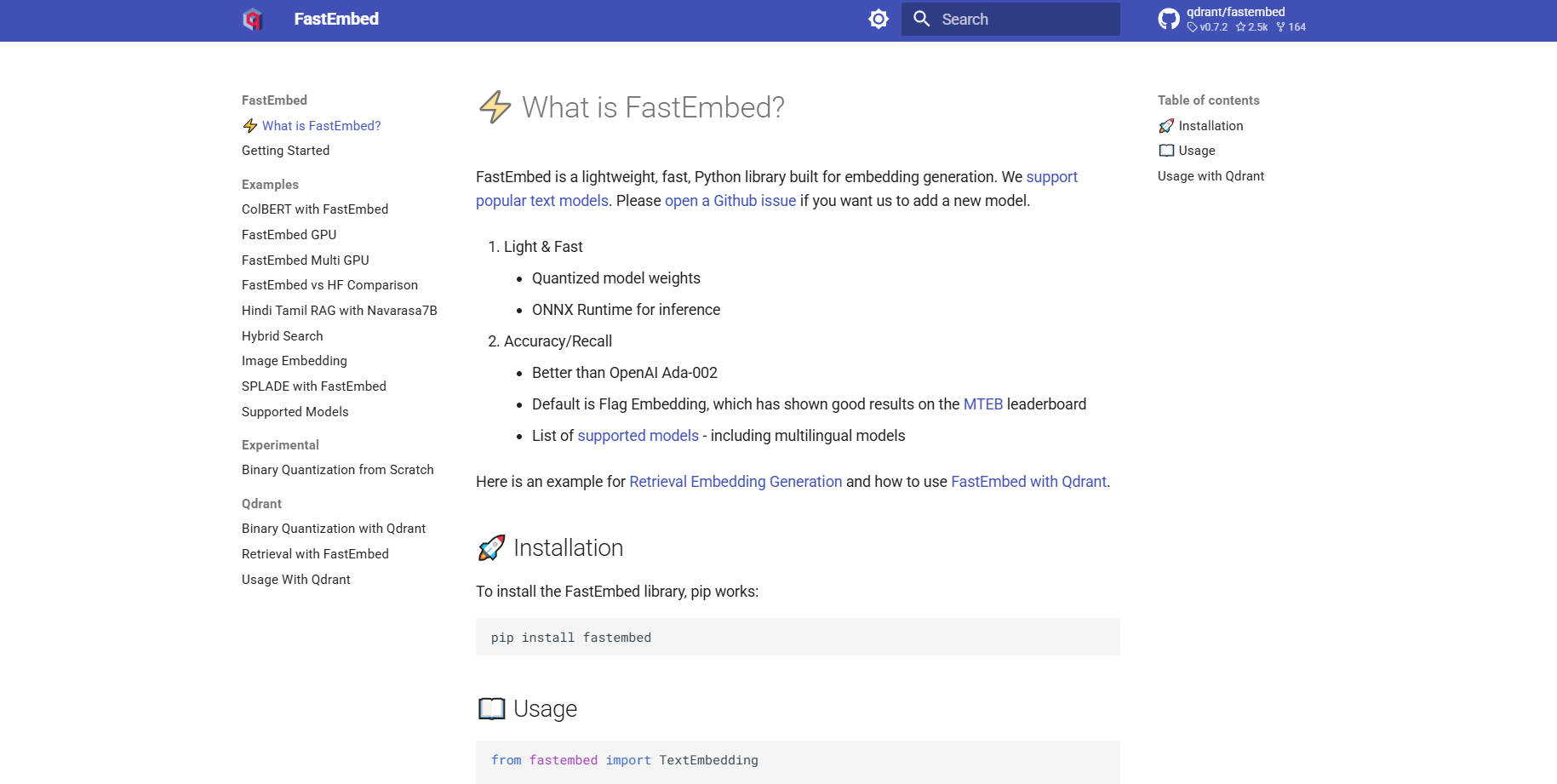

What is FastEmbed?

FastEmbed는 다양한 모달리티에 걸쳐 고속의 정확한 임베딩 생성을 위해 특별히 설계된 강력하면서도 놀랍도록 가벼운 Python 라이브러리입니다. 이 라이브러리는 효율적인 ONNX Runtime을 활용하여 기존 딥러닝 라이브러리와 관련된 일반적인 성능 및 종속성 비대 문제(dependency bloat issues)를 해결합니다. 개발자와 MLOps 팀을 위해 설계된 FastEmbed는 프로덕션 환경에 바로 적용 가능한 벡터 임베딩을 신속하게 제공하며, 견고한 검색 증강 생성(RAG) 시스템 및 효율적인 서버리스 애플리케이션 구축을 위한 이상적인 기반을 제공합니다.

주요 기능

FastEmbed는 최신 RAG 파이프라인의 복잡성을 처리하도록 구축되었으며, 최소한의 설치 공간(footprint)을 유지하면서 다양한 임베딩 유형 및 최적화 기술에 대한 강력한 지원을 제공합니다.

⚡️ 최적화된 텍스트 임베딩 (Dense & Sparse)

FastEmbed는 인기 있는 텍스트 모델을 사용하여 Dense 벡터를 생성하는 기능을 제공하며, 고성능 Flag Embedding을 기본 옵션으로 채택하고 있습니다. 무엇보다 중요한 것은 SPLADE++와 같은 Sparse 임베딩도 지원하여, 고밀도 의미론적 유사성(semantic similarity)에 중점을 두든 효율적인 키워드 매칭에 중점을 두든 최적의 검색 전략을 유연하게 선택할 수 있도록 하며, 커스텀 모델의 원활한 통합을 가능하게 합니다.

🖼️ 포괄적인 멀티모달 지원

텍스트를 넘어 검색 기능을 확장해 보세요. FastEmbed는 이미지 임베딩(예: CLIP 모델 사용) 및 고급 Late Interaction Multimodal Models (ColPali) 생성을 위한 특수 지원을 포함합니다. 이를 통해 이미지 및 텍스트 쿼리에 걸쳐 인덱싱을 통합하고, 단일 프레임워크 내에서 복잡한 멀티모달 검색을 가능하게 합니다.

🚀 ONNX Runtime을 통한 성능 가속

무거운 PyTorch 종속성에 의존하는 라이브러리와 달리, FastEmbed는 간소화된 ONNX Runtime을 활용합니다. 이러한 기술적 선택은 라이브러리 크기를 획기적으로 줄이고, 외부 종속성을 최소화하며, 실행 속도를 가속화하여 기존 임베딩 파이프라인에 비해 더 빠른 초기화와 우수한 처리량(throughput)을 보장합니다.

⚙️ 내장된 재순위화 및 상호작용 모델

최신 재순위화 모델을 지원하는 통합된 TextCrossEncoder 유틸리티를 사용하여 검색 결과의 정확도를 향상시키세요. 또한, 이 라이브러리는 Late Interaction Models (ColBERT와 같은)을 지원하여 검색 후 쿼리와 검색된 구절 간에 더욱 미묘하고 문맥을 인식하는 점수 매김(scoring)을 가능하게 합니다.

📈 확장 가능한 데이터 병렬 처리

대규모 데이터셋을 다루는 사용자를 위해 FastEmbed는 대량의 텍스트를 인코딩할 때 자동으로 데이터 병렬 처리를 활용합니다. 이 기능은 높은 처리량과 가용 리소스의 효율적인 활용을 보장하여, 대규모 프로젝트의 초기 벡터화 및 인덱싱 단계를 크게 가속화합니다.

사용 사례

FastEmbed는 성능, 크기, 정확도에 대한 타협이 불가능한 환경에 최적화되어 있습니다.

1. 고효율 서버리스 배포

FastEmbed의 경량 아키텍처와 ONNX Runtime에 대한 의존성은 AWS Lambda와 같은 서버리스 환경에 탁월한 선택지가 됩니다. 수 기가바이트에 달하는 종속성 패키지에 대한 걱정 없이 임베딩 생성 서비스를 마이크로서비스로 배포할 수 있어, 빠른 콜드 스타트와 비용 효율적인 확장을 보장합니다.

2. 엔터프라이즈 RAG 시스템을 위한 신속한 인덱싱

대규모 기업 지식 베이스를 마이그레이션하거나 업데이트할 때는 속도가 필수적입니다. FastEmbed의 데이터 병렬 처리 기능을 활용하여 수백만 개의 문서를 벡터로 신속하게 인코딩할 수 있습니다. 벡터 데이터베이스(Qdrant 클라이언트와 같은)와 직접 통합함으로써, 고품질의 최적화된 임베딩으로 컬렉션을 빠르게 채울 수 있으며, RAG 애플리케이션의 배포 시간을 단축할 수 있습니다.

3. 고급 멀티모달 검색

애플리케이션이 텍스트와 이미지가 모두 포함된 문서(예: 기술 설명서 또는 제품 카탈로그)를 검색해야 하는 경우, FastEmbed는 필요한 도구를 제공합니다. ColPali 모델을 활용하여 시각 및 텍스트 데이터에 대해 별개이면서도 관련 있는 임베딩을 생성함으로써, 두 가지 모달리티를 아우르는 정교한 쿼리를 가능하게 하여 매우 관련성 높은 결과를 제공합니다.

FastEmbed를 선택해야 하는 이유

FastEmbed는 Qdrant에 의해 유지 관리되며, 프로덕션 환경에 바로 적용 가능한 벡터 검색 애플리케이션을 구축하는 개발자들이 직면하는 일반적인 병목 현상을 극복하기 위해 특별히 제작되었습니다.

비교할 수 없는 효율성 (경량 설치 공간): FastEmbed는 일반적인 딥러닝 프레임워크의 무거운 종속성 부담을 피합니다. ONNX Runtime을 사용하고 외부 패키지를 거의 필요로 하지 않음으로써, 라이브러리 크기를 획기적으로 줄여 이식성이 뛰어나고 리소스가 제한된 환경에 이상적입니다.

우수한 속도 및 처리량: ONNX와 최적화된 데이터 병렬 처리를 활용하는 FastEmbed는 속도를 위해 설계되었습니다. 이러한 성능 중심의 접근 방식은 더 빠른 쿼리 응답 시간과 배치 처리(batch processing)를 위한 더 높은 처리량으로 직접 이어져 귀중한 계산 시간을 절약합니다.

입증된 정확도 및 모델 다양성: FastEmbed는 다국어 옵션을 포함하여 끊임없이 확장되는 고품질 모델 세트를 지원합니다. 무엇보다 중요한 것은 기본 모델이 OpenAI Ada-002와 같은 기존 상용 기준선보다 우수한 정확도를 제공하도록 벤치마킹되어, 검색 시스템이 정밀한 의미론적 데이터에 기반하도록 보장합니다.

프로덕션 준비 통합: GPU 가속(

fastembed-gpu를 통해)에 대한 선택적 지원과 Qdrant, Langchain, Llama Index와의 원활하고 지원되는 통합을 통해 FastEmbed는 엔터프라이즈급 AI 인프라의 핵심 구성 요소로 배포될 준비가 되어 있습니다.

결론

FastEmbed는 최신 벡터 검색 및 RAG 애플리케이션에 필요한 속도, 크기, 정확도의 중요한 균형을 제공합니다. ONNX Runtime을 통해 성능을 최적화하고 다양한 모델 및 모달리티에 대한 강력한 지원을 제공함으로써, 임베딩 파이프라인을 단순화하고 안정적이며 고품질의 결과를 보장합니다.

More information on FastEmbed

FastEmbed 대체품

더보기 대체품-

Embedchain: 개인 맞춤형 LLM 앱 구축 및 배포를 간소화하는 오픈소스 RAG 프레임워크. 프로토타입부터 상용화까지, 쉽고 유연하게 제어하며 나아가세요.

-

Snowflake Arctic embed: RAG 및 시맨틱 검색에 최적화된 고성능, 고효율 오픈 소스 텍스트 임베딩. AI 정확도를 향상시키고 비용을 절감합니다.

-

EmbeddingGemma: 프라이버시 우선 AI 앱을 위한 온디바이스 다국어 텍스트 임베딩. 오프라인에서도 동급 최고의 성능과 효율성을 제공합니다.

-

Superlinked는 정형 및 비정형 데이터를 결합하는 고성능 검색 및 추천 애플리케이션을 구축하는 AI 엔지니어를 위한 Python 프레임워크입니다.

-