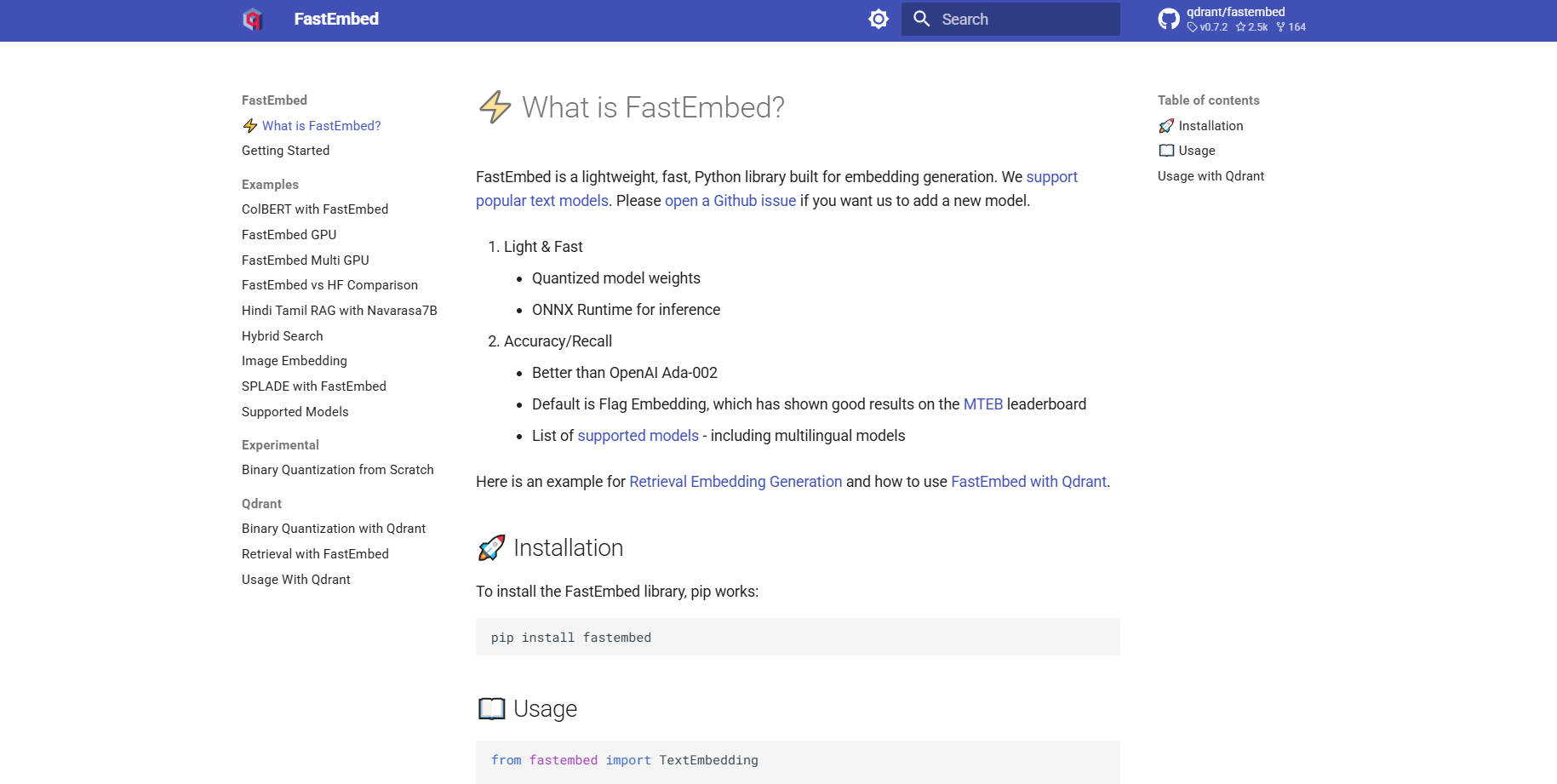

What is FastEmbed?

FastEmbed は、多様なモダリティに対応した高速かつ正確な埋め込み生成のために特別に開発された、強力でありながら驚くほど軽量な Python ライブラリです。効率的な ONNX Runtime を活用することで、従来の深層学習ライブラリで課題となりがちな、パフォーマンスや依存関係の肥大化といった問題を解消します。開発者やMLOpsチーム向けに設計された FastEmbed は、本番環境対応のベクトル埋め込みを迅速に生成するため、堅牢な Retrieval-Augmented Generation (RAG) システムや効率的なサーバーレスアプリケーションの構築に最適な基盤となります。

主要機能

FastEmbed は、現代の RAG パイプラインの複雑な処理に対応できるよう設計されており、最小限のフットプリントを維持しながら、さまざまな埋め込みタイプと最適化手法に対して堅牢なサポートを提供します。

⚡️ 最適化されたテキスト埋め込み(高密度&スパース)

FastEmbed は、人気のテキストモデルを使用した高密度ベクトル生成をサポートしており、高性能な Flag Embedding をデフォルトの選択肢としています。さらに重要なことに、SPLADE++ のようなスパース埋め込みもサポートしているため、高密度なセマンティック類似性または効率的なキーワードマッチングのいずれに焦点を当てるかに関わらず、最適な検索戦略を選択する柔軟性を提供し、カスタムモデルもスムーズに統合できます。

🖼️ 包括的なマルチモーダルサポート

テキストだけでなく、検索機能をさらに拡張しましょう。FastEmbed は、画像埋め込み生成(例:CLIP モデルを使用)や高度な Late Interaction Multimodal Models (ColPali) のための専門的なサポートを組み込んでいます。これにより、画像とテキストクエリを横断するインデックス作成を統一し、単一のフレームワーク内で複雑なマルチモーダル検索を可能にします。

🚀 ONNX Runtime によるパフォーマンス加速

重い PyTorch 依存関係に依存するライブラリとは異なり、FastEmbed は合理化された ONNX Runtime を利用しています。この技術選択により、ライブラリサイズが劇的に削減され、外部依存関係を最小限に抑え、実行速度が加速されるため、従来の埋め込みパイプラインと比較して、初期化の高速化とスループットの向上を実現します。

⚙️ 組み込みの再ランキングおよびインタラクションモデル

統合された TextCrossEncoder ユーティリティを使用して、検索結果の精度を向上させましょう。これは最先端の再ランキングモデルをサポートしています。さらに、このライブラリは Late Interaction Models (ColBERT のような) をサポートしており、検索後にクエリと取得されたパッセージの間で、より微妙な、文脈を考慮したスコアリングを可能にします。

📈 スケーラブルなデータ並列処理

大量のデータセットを扱うユーザーの場合、FastEmbed はテキストの大規模バッチをエンコードする際に、データ並列処理を自動的に採用します。この機能により、高スループット処理が保証され、利用可能なリソースの効率的な利用が可能になるため、大規模プロジェクトの初期ベクトル化およびインデックス作成フェーズを大幅に高速化します。

ユースケース

FastEmbed は、パフォーマンス、サイズ、精度が妥協できない環境に最適化されています。

1. 高効率なサーバーレスデプロイメント

FastEmbed の軽量なアーキテクチャと ONNX Runtime への依存は、AWS Lambda のようなサーバーレス環境に最適な候補となります。数ギガバイトに及ぶ依存関係パッケージを気にすることなく、埋め込み生成サービスをマイクロサービスとしてデプロイできるため、迅速なコールドスタートと費用対効果の高いスケーリングを保証します。

2. エンタープライズRAGシステムのための高速インデックス作成

大規模な企業知識ベースを移行または更新する際、高速性が不可欠です。FastEmbed のデータ並列処理機能を利用して、数百万ものドキュメントを迅速にベクトルにエンコードできます。ベクトルデータベース (Qdrant クライアントなど) と直接統合することで、高品質で最適化された埋め込みでコレクションを迅速に構築でき、RAGアプリケーションのデプロイまでの期間を短縮します。

3. 高度なマルチモーダル検索

アプリケーションがテキストと画像の両方を含むドキュメントを横断して検索する必要がある場合(例:技術マニュアルや製品カタログ)、FastEmbed は必要なツールを提供します。ColPali モデルを活用し、視覚データとテキストデータに対して、関連性がありながらも区別された埋め込みを生成することで、両方のモダリティにわたる洗練されたクエリを可能にし、非常に高い関連性を持つ結果を提供することが可能になります。

FastEmbed を選ぶ理由

FastEmbed は Qdrant によってメンテナンスされており、本番環境対応のベクトル検索アプリケーションを構築する開発者が直面する、共通のボトルネックを克服するために特別に構築されています。

比類なき効率性(軽量フットプリント): FastEmbed は、一般的な深層学習フレームワークにつきものの、重い依存関係の負荷を回避します。ONNX Runtime を使用し、外部パッケージの要件を少なくすることで、ライブラリサイズを劇的に削減し、高いポータビリティを実現し、リソース制約のある環境に最適です。

卓越した速度とスループット: ONNX と最適化されたデータ並列処理を活用することで、FastEmbed は速度を重視して設計されています。この性能への重点は、直接的にクエリ応答時間の高速化とバッチ処理の高いスループットにつながり、貴重な計算時間を節約します。

実証された精度とモデルの多様性: FastEmbed は、多言語オプションを含む、常に拡大する高品質モデルセットをサポートしています。重要なことに、そのデフォルトモデルは、OpenAI Ada-002 のような確立された商用ベースラインを上回る精度を提供することがベンチマークで証明されており、これにより、検索システムが正確なセマンティックデータに基づいて構築されることを保証します。

本番環境対応の統合: GPU アクセラレーション (

fastembed-gpu経由) のオプションサポートと、Qdrant、Langchain、および Llama Index とのシームレスでサポートされた統合により、FastEmbed は、エンタープライズグレードの AI インフラストラクチャの中核コンポーネントとして、すぐにデプロイ可能です。

結論

FastEmbed は、現代のベクトル検索および RAG アプリケーションに不可欠な、速度、サイズ、精度のバランスを絶妙に提供します。ONNX Runtime を介してパフォーマンスを最適化し、多様なモデルとモダリティに対して堅牢なサポートを提供することで、埋め込みパイプラインを簡素化し、信頼性が高く高品質な結果を確実に提供します。

More information on FastEmbed

FastEmbed 代替ソフト

もっと見る 代替ソフト-

Embedchain: パーソナライズされたLLMアプリの構築とデプロイを簡素化するオープンソースのRAGフレームワーク。プロトタイプからプロダクションまで、簡単かつ思いのままに。

-

Snowflake Arctic embed:RAGおよびセマンティック検索に最適な、高性能かつ効率的なオープンソースのテキスト埋め込み。AIの精度を向上させ、コストを削減します。

-

EmbeddingGemma: 端末内で完結する、プライバシー重視のAIアプリ向け多言語テキスト埋め込み。オフライン環境でも、クラス最高水準のパフォーマンスと効率性を提供します。

-

Superlinkedは、構造化データと非構造化データを組み合わせた高性能な検索・レコメンデーションアプリケーションを構築するAIエンジニア向けのPythonフレームワークです。

-