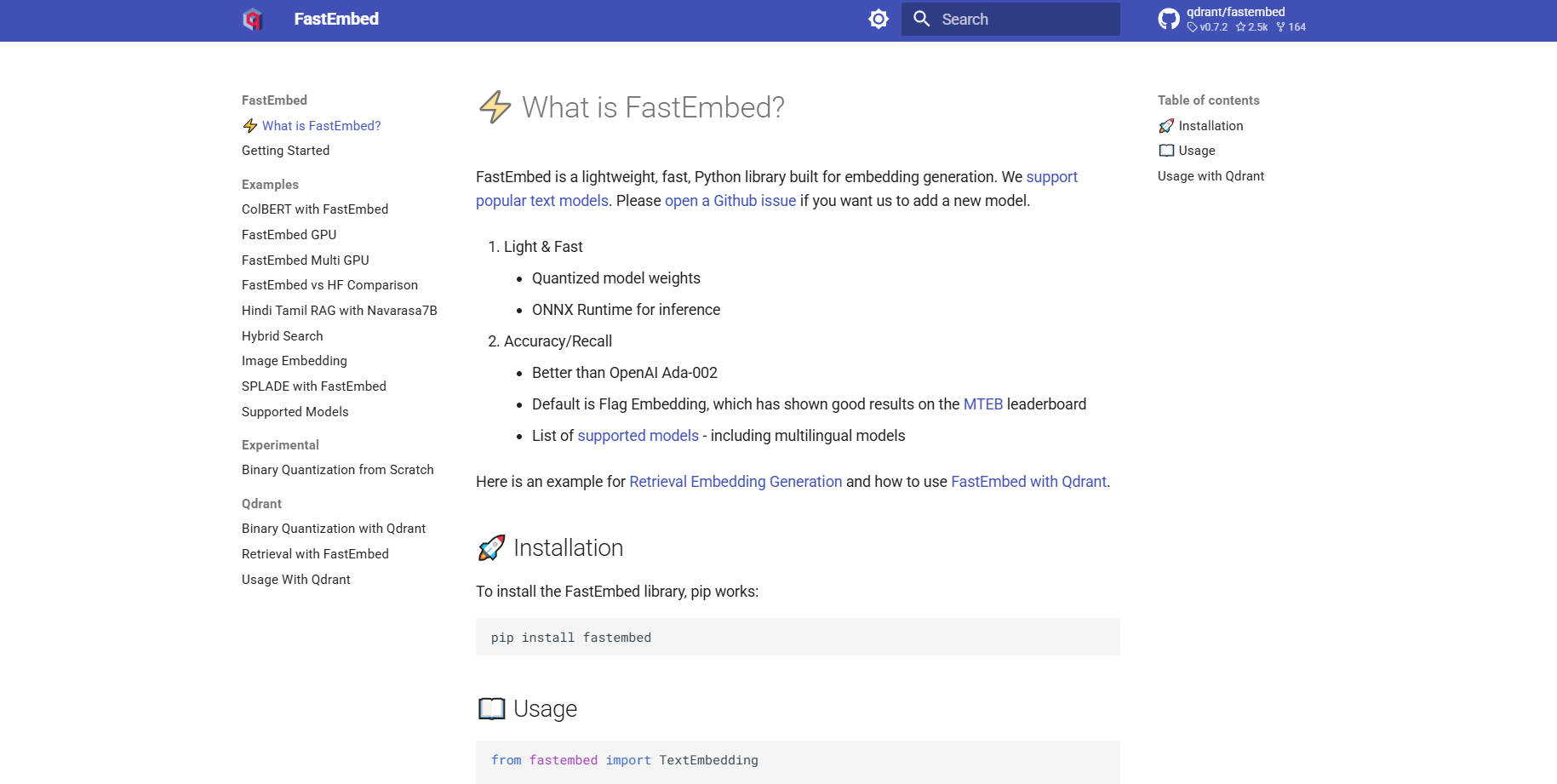

What is FastEmbed?

FastEmbed est une bibliothèque Python puissante, mais remarquablement légère, conçue spécifiquement pour générer des embeddings rapidement et avec précision, à travers diverses modalités. Elle résout les problèmes courants de performance et de prolifération des dépendances rencontrés avec les bibliothèques de deep learning traditionnelles, en s'appuyant sur l'efficace ONNX Runtime. Conçue pour les développeurs et les équipes MLOps, FastEmbed fournit rapidement des embeddings vectoriels prêts pour la production, ce qui en fait la base idéale pour construire des systèmes de génération augmentée par la récupération (RAG) robustes et des applications serverless efficaces.

Caractéristiques Principales

FastEmbed est conçue pour gérer la complexité des pipelines RAG modernes, offrant un support robuste pour divers types d'embeddings et techniques d'optimisation, tout en conservant une empreinte minimale.

⚡️ Embedding de Texte Optimisé (Dense & Sparse)

FastEmbed prend en charge la génération de vecteurs denses à l'aide de modèles de texte populaires, avec Flag Embedding, très performant, comme choix par défaut. De manière cruciale, elle prend également en charge les embeddings épars comme SPLADE++, vous offrant la flexibilité de choisir la stratégie de récupération optimale — qu'il s'agisse de se concentrer sur la similarité sémantique à haute densité ou sur la correspondance de mots-clés efficace — et permettant l'intégration transparente de modèles personnalisés.

🖼️ Support Multimodal Complet

Élargissez vos capacités de récupération au-delà du texte. FastEmbed intègre un support spécialisé pour la génération d'embeddings d'images (par exemple, en utilisant des modèles CLIP) et de modèles multimodaux à interaction tardive avancés (ColPali). Cela vous permet d'unifier l'indexation des requêtes textuelles et d'images, rendant possible une recherche multimodale complexe au sein d'un cadre unique.

🚀 Accélération des Performances via ONNX Runtime

Contrairement aux bibliothèques qui s'appuient sur de lourdes dépendances PyTorch, FastEmbed utilise l'ONNX Runtime épuré. Ce choix technique réduit drastiquement la taille de la bibliothèque, minimise les dépendances externes et accélère la vitesse d'exécution, garantissant une initialisation plus rapide et un débit supérieur par rapport aux pipelines d'embedding conventionnels.

⚙️ Modèles de Reranking et d'Interaction Intégrés

Améliorez la précision de vos résultats de recherche en utilisant l'utilitaire intégré TextCrossEncoder, qui prend en charge des modèles de reranking à la pointe de la technologie. De plus, la bibliothèque prend en charge les modèles à interaction tardive (tels que ColBERT), permettant une évaluation plus nuancée et contextuellement pertinente entre les requêtes et les passages récupérés post-récupération.

📈 Parallélisme des Données Évolutif

Pour les utilisateurs travaillant avec des ensembles de données massifs, FastEmbed utilise automatiquement le parallélisme des données lors de l'encodage de grands lots de texte. Cette fonctionnalité assure un traitement à haut débit et une utilisation efficace des ressources disponibles, accélérant considérablement les phases initiales de vectorisation et d'indexation des projets à grande échelle.

Cas d'Utilisation

FastEmbed est optimisée pour les environnements où la performance, la taille et la précision ne peuvent être compromises.

1. Déploiement Serverless à Haute Efficacité

L'architecture légère de FastEmbed et sa dépendance à l'ONNX Runtime en font un excellent candidat pour les environnements serverless, tels qu'AWS Lambda. Vous pouvez déployer des services de génération d'embeddings sous forme de microservices sans vous soucier de paquets de dépendances de plusieurs gigaoctets, garantissant des démarrages à froid rapides et une mise à l'échelle rentable.

2. Indexation Rapide pour les Systèmes RAG d'Entreprise

Lors de la migration ou de la mise à jour d'une vaste base de connaissances d'entreprise, la rapidité est essentielle. Exploitez les capacités de parallélisme des données de FastEmbed pour encoder rapidement des millions de documents en vecteurs. En s'intégrant directement avec des bases de données vectorielles (comme le client Qdrant), vous pouvez rapidement peupler des collections avec des embeddings optimisés et de haute qualité, accélérant ainsi le délai de déploiement de vos applications RAG.

3. Recherche Multimodale Avancée

Si votre application nécessite de rechercher dans des documents contenant à la fois du texte et des images (par exemple, des manuels techniques ou des catalogues de produits), FastEmbed fournit les outils nécessaires. Exploitez les modèles ColPali pour générer des embeddings distincts, mais liés, pour les données visuelles et textuelles, permettant des requêtes sophistiquées qui englobent les deux modalités pour fournir des résultats très pertinents.

Pourquoi Choisir FastEmbed ?

FastEmbed est maintenue par Qdrant et conçue spécifiquement pour surmonter les goulots d'étranglement courants rencontrés par les développeurs qui créent des applications de recherche vectorielle prêtes pour la production.

Efficacité Inégalée (Faible Empreinte) : FastEmbed évite la lourde charge de dépendances des frameworks de deep learning typiques. En utilisant l'ONNX Runtime et en nécessitant peu de paquets externes, elle réduit drastiquement la taille de la bibliothèque, la rendant très portable et idéale pour les environnements aux ressources limitées.

Vitesse et Débit Supérieurs : S'appuyant sur ONNX et un parallélisme des données optimisé, FastEmbed est conçue pour la vitesse. Cette focalisation sur la performance se traduit directement par des temps de réponse aux requêtes plus rapides et un débit plus élevé pour le traitement par lots, économisant un temps de calcul précieux.

Précision Prouvée et Diversité des Modèles : FastEmbed prend en charge un ensemble de modèles de haute qualité en constante expansion, y compris des options multilingues. De manière cruciale, ses modèles par défaut sont évalués pour offrir une précision supérieure aux bases de référence commerciales établies, telles qu'OpenAI Ada-002, garantissant que vos systèmes de récupération sont construits sur des données sémantiques précises.

Intégration Prête pour la Production : Avec un support optionnel pour l'accélération GPU (via

fastembed-gpu) et une intégration fluide et prise en charge avec Qdrant, Langchain et Llama Index, FastEmbed est prête à être déployée comme composant essentiel d'une infrastructure d'IA de niveau entreprise.

Conclusion

FastEmbed offre l'équilibre critique entre vitesse, taille et précision, indispensable pour les applications modernes de recherche vectorielle et de RAG. En optimisant les performances via l'ONNX Runtime et en offrant un support robuste pour divers modèles et modalités, elle simplifie le pipeline d'embedding et assure des résultats fiables et de haute qualité.

More information on FastEmbed

FastEmbed Alternatives

Plus Alternatives-

Embedchain : Le framework RAG open-source pour simplifier la création et le déploiement d'applications LLM personnalisées. Passez du prototype à la production en toute simplicité et avec une maîtrise totale.

-

Snowflake Arctic embed : Des embeddings de texte open source performants et efficaces, optimisés pour le RAG et la recherche sémantique. Améliorez la précision de votre IA et réduisez vos coûts.

-

EmbeddingGemma : Des embeddings textuels multilingues embarqués, conçus pour les applications d'IA privilégiant la confidentialité. Bénéficiez de performances et d'une efficacité de pointe, même hors ligne.

-

Superlinked est un framework Python à l'intention des ingénieurs en IA, leur permettant de développer des applications de recherche et de recommandation ultra-performantes, capables d'intégrer harmonieusement des données structurées et non structurées.

-

Infinity est une base de données native de l'IA de pointe, offrant une vaste gamme de capacités de recherche pour des types de données riches : vecteurs denses, vecteurs creux, tenseurs, texte intégral et données structurées. Elle apporte un soutien solide à diverses applications de LLM, y compris la recherche, les systèmes de recommandation, la réponse aux questions, l'IA conversationnelle, les copilotes, la génération de contenu, et bien d'autres applications de RAG (Génération augmentée par la Récupération).