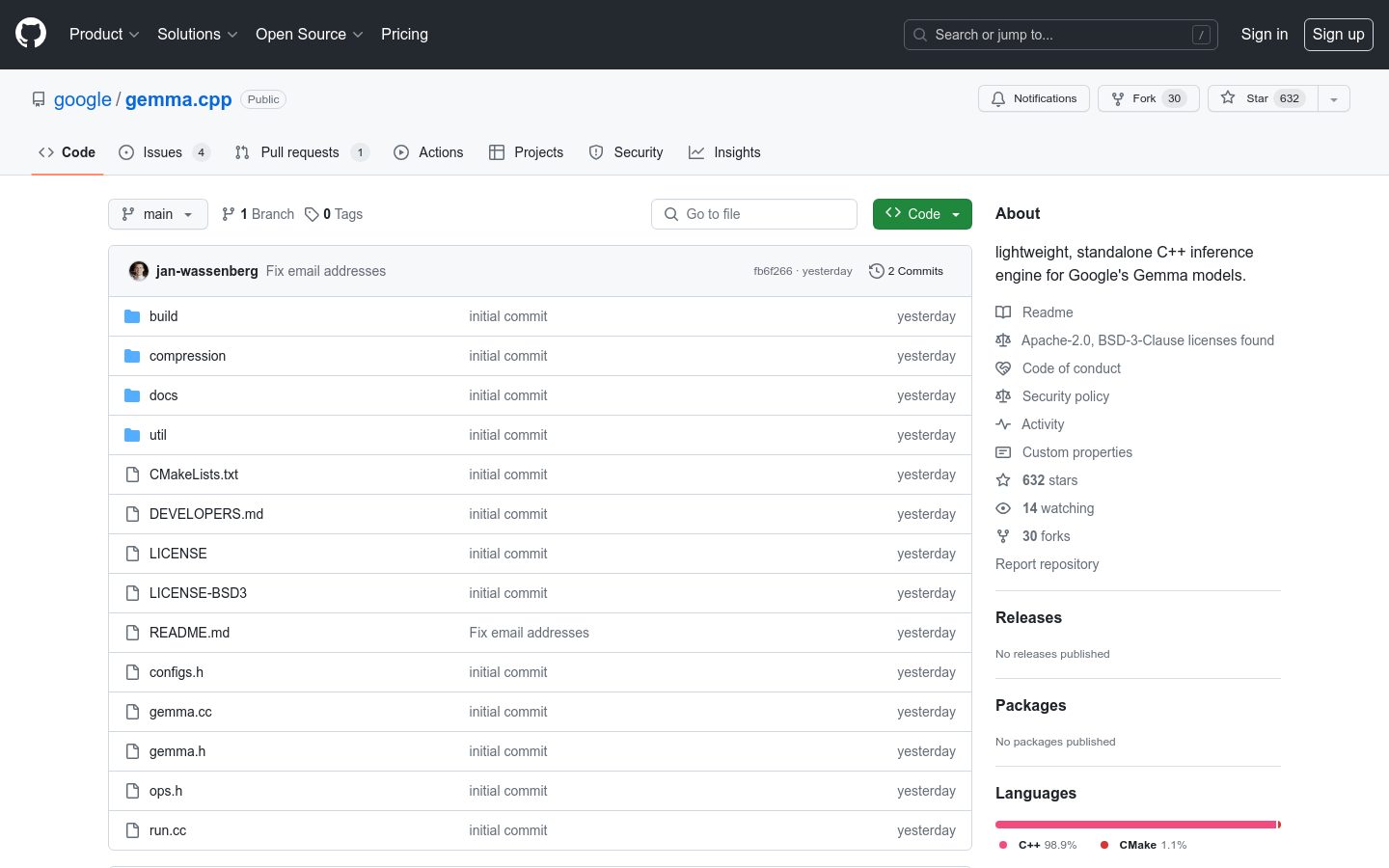

What is Gemma.cpp?

gemma.cpp es un motor de inferencia C++ ligero e independiente diseñado para los modelos de base de Gemma de Google. Ofrece una implementación simplificada de los modelos Gemma 2B y 7B, priorizando la sencillez y la inmediatez. Con gemma.cpp, los investigadores y desarrolladores pueden experimentar fácilmente con los modelos de Gemma e incorporarlos en sus proyectos, a la vez que se benefician de sus dependencias mínimas y portabilidad. Se recomienda para casos de uso de experimentación e investigación, mientras que las implementaciones de vanguardia orientadas a la producción son más adecuadas para marcos de trabajo de Python como JAX, Keras, PyTorch y Transformers.

Características Clave:

? Implementación minimalista: gemma.cpp proporciona una implementación simplificada de los modelos Gemma 2B y 7B, centrándose en la sencillez y la inmediatez.

? Experimentación e Investigación: Está diseñado para casos de uso de experimentación e investigación, lo que permite a los usuarios integrarlo fácilmente en otros proyectos con dependencias mínimas.

? SIMD portátil: gemma.cpp aprovecha la biblioteca Google Highway para utilizar SIMD portátil para la inferencia de la CPU, lo que garantiza un rendimiento eficiente y optimizado.

Casos de uso:

Investigación y experimentación: gemma.cpp es ideal para investigadores y desarrolladores que desean experimentar con modelos de Gemma y explorar nuevos algoritmos. Proporciona una plataforma sencilla y directa para probar y modificar modelos de Gemma con dependencias mínimas.

Incorporación de modelos: gemma.cpp se puede incorporar fácilmente a otros proyectos, lo que permite a los desarrolladores incorporar modelos de Gemma en sus propias aplicaciones y sistemas. Esto permite el uso de las capacidades de Gemma sin necesidad de modificaciones exhaustivas o dependencias adicionales.

Inferencia portátil: con gemma.cpp, los usuarios pueden realizar inferencias de CPU utilizando SIMD portátil, lo que garantiza un rendimiento eficiente y optimizado en diferentes sistemas y arquitecturas. Esto lo hace adecuado para implementaciones de vanguardia donde la eficiencia de los recursos y el rendimiento son cruciales.

Conclusión:

gemma.cpp es un motor de inferencia C++ ligero e independiente diseñado específicamente para los modelos de base de Gemma de Google. Su implementación minimalista, centrada en la sencillez y la inmediatez, lo convierte en una excelente opción para investigadores y desarrolladores que buscan experimentar con modelos de Gemma. Con gemma.cpp, los usuarios pueden incorporar fácilmente modelos de Gemma en sus proyectos, beneficiándose de sus dependencias mínimas y SIMD portátil para una inferencia eficiente de la CPU. Si bien gemma.cpp se centra en casos de uso de experimentación e investigación, se recomienda utilizar marcos de trabajo de Python para implementaciones de vanguardia orientadas a la producción. ¡Aproveche el potencial de gemma.cpp y revolucione sus procesos de investigación y desarrollo hoy mismo! Visite ai.google.dev/gemma para obtener más información.

More information on Gemma.cpp

Gemma.cpp Alternativas

Más Alternativas-

Gemma es una familia de modelos abiertos y livianos que se crearon a partir de la investigación y tecnología que Google usó para crear los modelos Gemini.

-

-

-

Gemma 3 270M: IA compacta e hiper-eficiente para tareas especializadas. Afínela para un seguimiento preciso de instrucciones y una implementación de bajo costo directamente en el dispositivo.

-