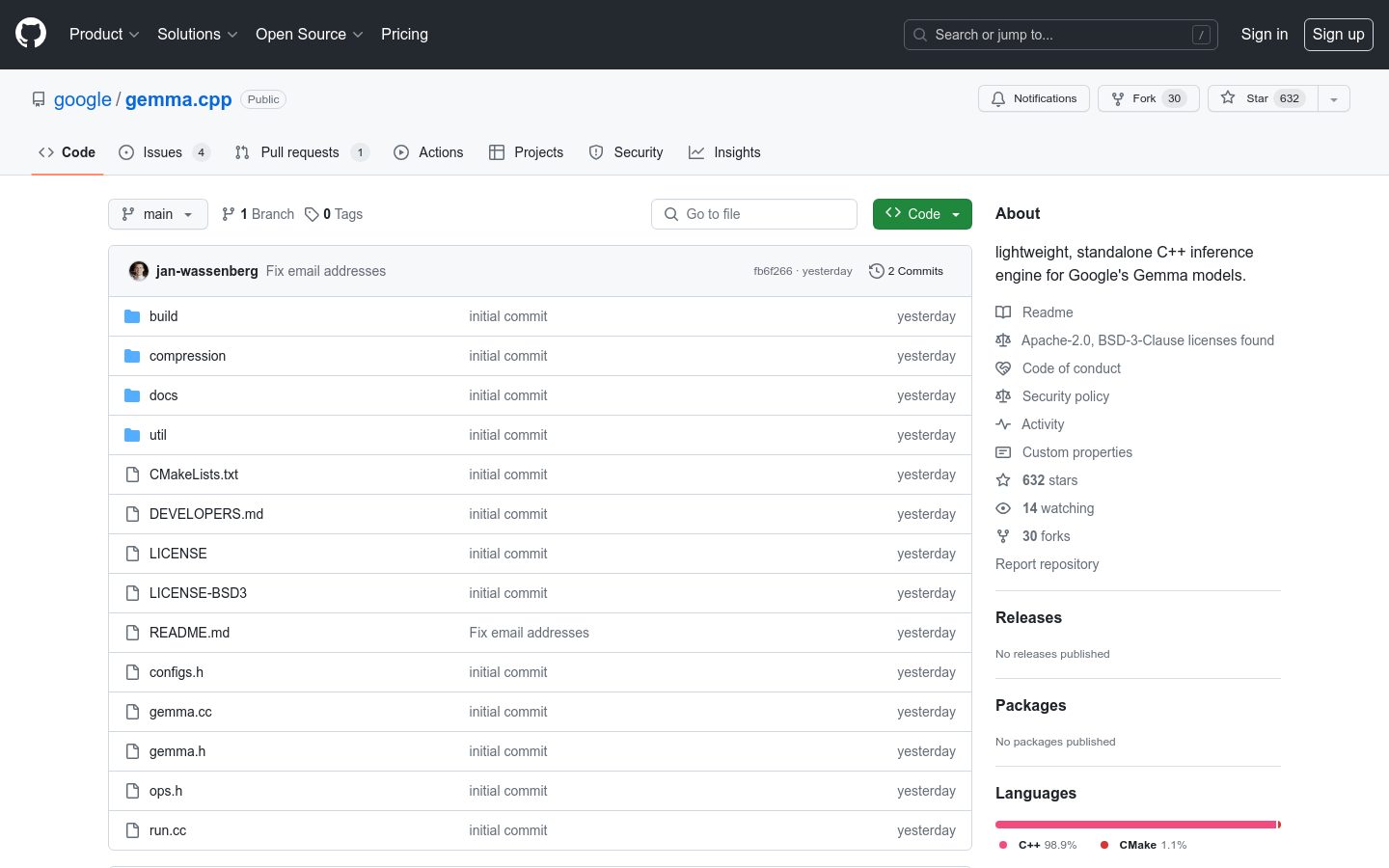

What is Gemma.cpp?

gemma.cpp est un moteur d'inférence C++ léger et autonome conçu pour les modèles fondamentaux de Gemma de Google. Il offre une implémentation simplifiée des modèles Gemma 2B et 7B, privilégiant la simplicité et la rapidité. Avec gemma.cpp, les chercheurs et les développeurs peuvent aisément expérimenter et intégrer les modèles Gemma à leurs projets, tout en bénéficiant de ses dépendances minimales et de sa portabilité. Il est recommandé pour l'expérimentation et les cas d'utilisation de la recherche, tandis que les déploiements de pointe orientés vers la production sont mieux adaptés aux frameworks Python comme JAX, Keras, PyTorch et Transformers.

Principales fonctionnalités :

? Implémentation minimaliste : gemma.cpp fournit une implémentation simplifiée des modèles Gemma 2B et 7B, en mettant l'accent sur la simplicité et la rapidité.

? Expérimentation et recherche : Il est conçu pour l'expérimentation et les cas d'utilisation de la recherche, permettant aux utilisateurs de l'intégrer facilement à d'autres projets avec des dépendances minimales.

? SIMD portable : gemma.cpp exploite la bibliothèque Google Highway pour tirer parti du SIMD portable pour l'inférence du processeur, garantissant des performances efficaces et optimisées.

Cas d'utilisation :

Recherche et expérimentation : gemma.cpp est idéal pour les chercheurs et les développeurs qui souhaitent expérimenter les modèles Gemma et explorer de nouveaux algorithmes. Il fournit une plateforme simple et directe pour tester et modifier les modèles Gemma avec des dépendances minimales.

Intégration du modèle : gemma.cpp peut être facilement intégré à d'autres projets, permettant aux développeurs d'incorporer les modèles Gemma dans leurs propres applications et systèmes. Cela permet d'utiliser les capacités de Gemma sans avoir besoin de modifications approfondies ou de dépendances supplémentaires.

Inférence portable : Avec gemma.cpp, les utilisateurs peuvent effectuer une inférence du processeur en utilisant le SIMD portable, garantissant des performances efficaces et optimisées sur différents systèmes et architectures. Cela le rend approprié pour les déploiements de pointe où l'efficacité des ressources et les performances sont essentielles.

Conclusion :

gemma.cpp est un moteur d'inférence C++ léger et autonome spécialement conçu pour les modèles fondamentaux de Gemma de Google. Son implémentation minimaliste, axée sur la simplicité et la rapidité, en fait un excellent choix pour les chercheurs et les développeurs qui cherchent à expérimenter les modèles Gemma. Avec gemma.cpp, les utilisateurs peuvent facilement intégrer les modèles Gemma à leurs projets, bénéficiant de ses dépendances minimales et de son SIMD portable pour une inférence efficace du processeur. Alors que gemma.cpp cible l'expérimentation et les cas d'utilisation de la recherche, il est recommandé d'utiliser les frameworks Python pour les déploiements de pointe orientés vers la production. Exploitez le potentiel de gemma.cpp et révolutionnez vos processus de recherche et de développement dès aujourd'hui ! Visitez ai.google.dev/gemma pour plus d'informations.

More information on Gemma.cpp

Gemma.cpp Alternatives

Plus Alternatives-

Gemma est une famille de modèles légers et ouverts construits à partir des recherches et de la technologie que Google a utilisées pour créer les modèles Gemini.

-

-

-

Gemma 3 270M : IA compacte et hyper-efficace pour les tâches spécialisées. Idéale pour un affinage précis des instructions et un déploiement économique embarqué.

-