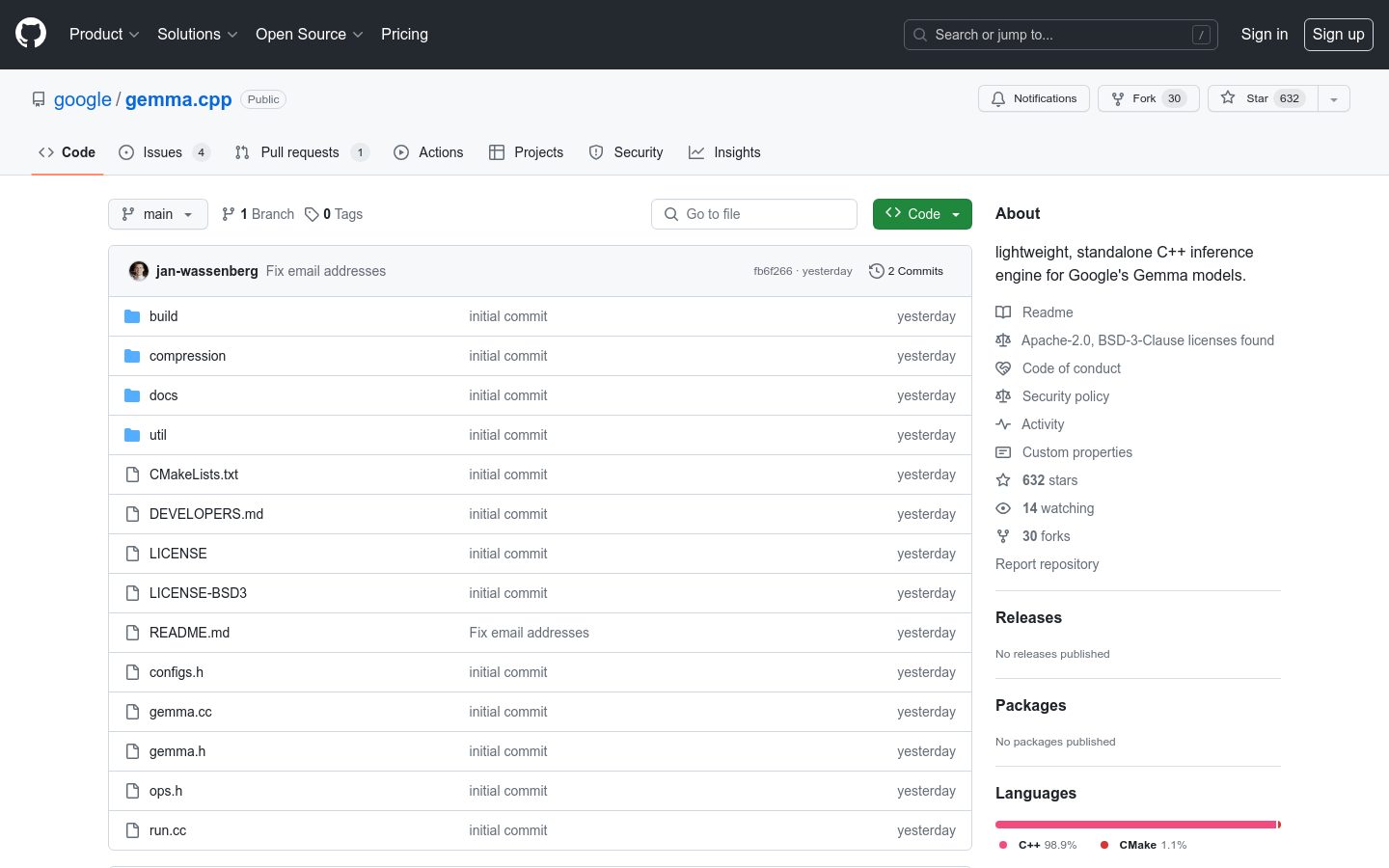

What is Gemma.cpp?

gemma.cpp는 Google의 Gemma 기반 모델을 위해 고안된 경량 독립형 C++ 추론 엔진입니다. Gemma 2B 및 7B 모델을 간소하게 구현하여 단순성과 직접성을 우선시 합니다. gemma.cpp를 사용하면 연구원과 개발자가 쉽게 Gemma 모델을 실험하고 프로젝트에 임베딩하여 이점을 얻을 수 있으며, 최소한의 종속성과 이식성도 갖추고 있습니다. 실험과 연구에 적합하지만, 프로덕션 지향 에지 배포에는 JAX, Keras, PyTorch와 Transformer 같은 Python 프레임워크가 더 적합합니다.

주요 특징:

? 최소한의 구현: gemma.cpp는 Gemma 2B 및 7B 모델을 간소하게 구현하여 단순성과 직접성에 중점을 맞춥니다.

? 실험 및 연구: 실험과 연구에 맞게 설계되어 사용자가 최소한의 종속성을 지닌 다른 프로젝트에 쉽게 임베딩할 수 있습니다.

? 휴대용 SIMD: gemma.cpp는 Google Highway 라이브러리를 활용하여 CPU 추론을 위한 휴대용 SIMD의 장점을 활용하여 효율적이고 최적화된 성능을 보장합니다.

사용 사례:

연구 및 실험: gemma.cpp는 Gemma 모델을 실험하고 새로운 알고리즘을 탐색하고자 하는 연구원과 개발자에게 이상적입니다. 최소한의 종속성으로 Gemma 모델을 테스트하고 수정하기 위한 간단하고 직관적인 플랫폼을 제공합니다.

모델 임베딩: gemma.cpp는 다른 프로젝트에 쉽게 임베딩되어 개발자가 Gemma 모델을 자체 애플리케이션과 시스템에 통합할 수 있습니다. 이렇게 하면 광범위한 수정이나 추가 종속성 없이도 Gemma의 기능을 활용할 수 있습니다.

휴대용 추론: gemma.cpp를 통해 사용자는 휴대용 SIMD를 사용하여 CPU 추론을 수행할 수 있으므로 다양한 시스템과 아키텍처에서 효율적이고 최적화된 성능을 보장합니다. 이는 리소스 효율성과 성능이 중요한 에지 배포에 적합합니다.

결론:

gemma.cpp는 Google의 Gemma 기반 모델을 위해 특별히 설계된 경량 독립형 C++ 추론 엔진입니다. 단순성과 직접성에 중점을 둔 최소한의 구현은 Gemma 모델을 실험하고자 하는 연구원과 개발자에게 최적의 선택입니다. gemma.cpp를 통해 사용자는 Gemma 모델을 프로젝트에 쉽게 임베딩하고 효율적인 CPU 추론을 위한 최소한의 종속성과 휴대용 SIMD의 이점을 누릴 수 있습니다. gemma.cpp는 실험 및 연구에 초점을 맞추고 있지만, 프로덕션 지향 에지 배포에는 Python 프레임워크를 사용하는 것이 좋습니다. 오늘 gemma.cpp의 잠재력을 받아들여 연구 및 개발 프로세스에 혁신을 일으키세요! 자세한 내용은 ai.google.dev/gemma를 방문하세요.