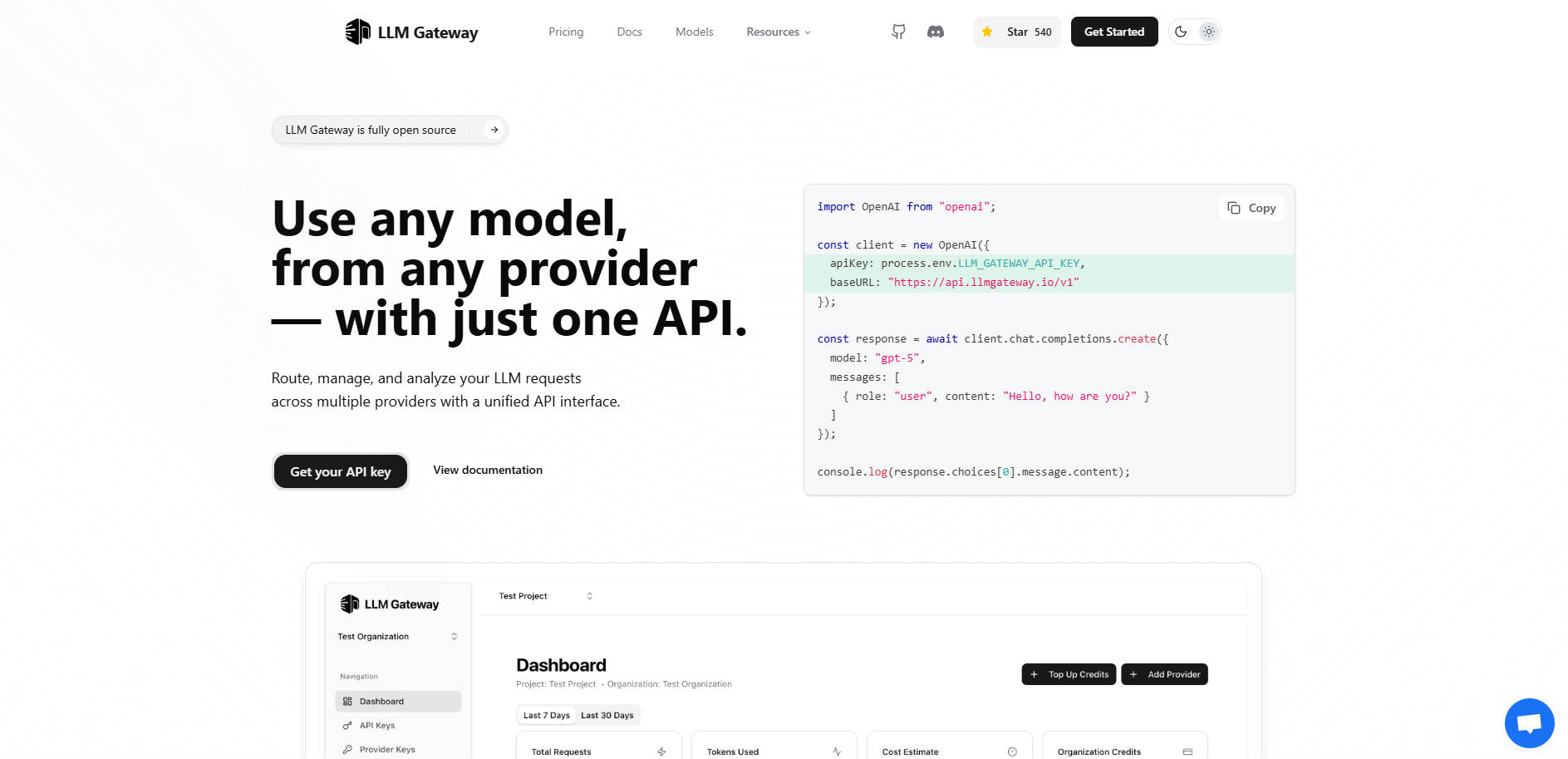

What is LLMGateway?

LLM Gateway es una pasarela API robusta y de código abierto, diseñada para actuar como un middleware inteligente entre su aplicación y el diverso ecosistema de proveedores de Modelos de Lenguaje Grandes (LLM). Si está desarrollando aplicaciones que dependen de múltiples modelos de IA (como OpenAI, Anthropic o Google AI Studio), integrarlos directamente genera complejidad, riesgo de dependencia del proveedor (vendor lock-in) y un seguimiento de costos fragmentado.

LLM Gateway centraliza toda su infraestructura LLM, permitiéndole enrutar, gestionar credenciales, rastrear el uso y analizar el rendimiento en todos los proveedores a través de una interfaz única y unificada. Obtiene control inmediato sobre los costos y la optimización del rendimiento sin cambios complejos en el código.

Características Clave

🌐 Interfaz API Unificada para una Migración sin Esfuerzo

LLM Gateway mantiene compatibilidad con el formato ampliamente adoptado de la API de OpenAI. Esta característica fundamental significa que puede conectarse a cualquier proveedor compatible —independientemente de su SDK nativo— utilizando una estructura de solicitud única y estandarizada. Puede cambiar de modelos o proveedores al instante sin reescribir la lógica central de su aplicación ni migrar código complejo específico del proveedor.

🚦 Enrutamiento Inteligente de Múltiples Proveedores

Enrute solicitudes dinámicamente al proveedor LLM óptimo basándose en criterios como la disponibilidad del modelo, el costo o los requisitos de rendimiento. El Gateway gestiona las conexiones subyacentes a proveedores como OpenAI, Anthropic y Google Vertex AI, asegurando que su aplicación permanezca agnóstica al proveedor y sea resistente a interrupciones de un solo proveedor.

💰 Análisis Centralizado de Uso y Seguimiento de Costos

Obtenga una visibilidad profunda de su consumo de LLM. LLM Gateway rastrea automáticamente métricas clave de uso —incluyendo el número de solicitudes, tokens consumidos y costos reales— en todos los modelos y proveedores. Este panel de control centralizado le permite monitorear el gasto en tiempo real y tomar decisiones presupuestarias informadas basadas en datos verificables.

⏱️ Monitorización y Comparación del Rendimiento

Identifique los modelos más eficientes para tareas específicas analizando los tiempos de respuesta y la rentabilidad. El Gateway proporciona seguimiento comparativo del rendimiento, ayudándole a comparar diferentes modelos con sus datos de uso reales para que pueda optimizar sus estrategias de prompts y seleccionar modelos que ofrezcan el mejor equilibrio entre velocidad y valor.

⚙️ Opciones de Despliegue Flexibles

Elija el método de despliegue que se adapte a sus necesidades de seguridad y control. Puede comenzar inmediatamente con la Versión Alojada para una configuración cero, o desplegar la versión Autoalojada (núcleo de código abierto) en su propia infraestructura. El autoalojamiento garantiza la máxima privacidad de los datos y un control total sobre la configuración y el flujo de tráfico.

Casos de Uso

1. Pruebas A/B y Comparación de Modelos

En lugar de configurar y ejecutar pruebas separadas manualmente para diferentes modelos, puede enrutar prompts idénticos a través de LLM Gateway, especificando diferentes modelos subyacentes (por ejemplo,gpt-4o frente a un modelo Anthropic de alto rendimiento). El seguimiento de rendimiento integrado compara instantáneamente la latencia, el uso de tokens y el costo, permitiéndole seleccionar el modelo de producción definitivo basado en métricas del mundo real.

2. Simplificación de la Migración y Conmutación por Error de Proveedores

Cuando un nuevo modelo más rentable es lanzado por un proveedor diferente, o si necesita una estrategia de conmutación por error, LLM Gateway elimina la necesidad de una refactorización extensa. Dado que su aplicación solo se comunica con la API unificada del Gateway, simplemente actualiza la configuración de enrutamiento o el parámetro del modelo dentro de la capa del Gateway, logrando una migración instantánea o protección contra fallos.

3. Gestión Presupuestaria en Tiempo Real

Para equipos de desarrollo que gestionan múltiples proyectos, LLM Gateway proporciona una vista consolidada del gasto. Puede monitorear qué aplicaciones o claves API específicas están impulsando el mayor uso de tokens, permitiendo a los propietarios de productos identificar rápidamente ineficiencias, implementar límites de uso o ajustar las elecciones de modelos para mantenerse dentro de las restricciones presupuestarias definidas.

¿Por Qué Elegir LLM Gateway?

LLM Gateway ofrece una combinación única de flexibilidad, control y profundidad funcional que lo diferencia de la conexión directa a las API de proveedores individuales.

Núcleo de Código Abierto con Opciones Empresariales: La funcionalidad central de enrutamiento y monitorización es de código abierto (AGPLv3), dando a los equipos técnicos total transparencia y control sobre el flujo de tráfico de sus LLM. Para organizaciones más grandes, la licencia Enterprise proporciona características críticas como facturación avanzada, gestión de equipos y soporte prioritario.

Verdadero Agnosticismo de Proveedor: Al utilizar el estándar de la API de OpenAI para todos los proveedores, LLM Gateway prepara su arquitectura de aplicación para el futuro. Su base de código permanece estable incluso mientras experimenta o migra por completo a nuevos proveedores de LLM.

Control de Datos: La opción de despliegue autoalojado asegura que los datos de sus solicitudes LLM y el tráfico de la API permanezcan dentro de su infraestructura existente, satisfaciendo estrictos requisitos de cumplimiento y seguridad.

Conclusión

LLM Gateway proporciona el plano de control esencial necesario para construir aplicaciones de IA sofisticadas y multimodelo de manera eficiente y rentable. Transforma un conjunto fragmentado de integraciones de API en una capa de servicio única, manejable y altamente optimizada. Tome el control de su estrategia LLM, simplifique su arquitectura y comience a optimizar su rendimiento hoy mismo.

Descubra cómo LLM Gateway puede centralizar su infraestructura de IA.

More information on LLMGateway

Top 5 Countries

Traffic Sources

LLMGateway Alternativas

LLMGateway Alternativas-

Helicone AI Gateway: Unifica y optimiza tus APIs de LLM para producción. Potencia el rendimiento, reduce costes y garantiza la fiabilidad con enrutamiento inteligente y almacenamiento en caché.

-

Envoy AI Gateway es un proyecto de código abierto para utilizar Envoy Gateway en la gestión del tráfico de solicitudes desde clientes de aplicaciones hacia servicios de IA generativa.

-

Lanza funciones de IA más rápido con la puerta de enlace unificada de MegaLLM. Accede a Claude, GPT-5, Gemini, Llama y más de 70 modelos mediante una única API. Incluye análisis integrados, mecanismos inteligentes de respaldo y seguimiento del uso.

-

LangDB AI Gateway es tu centro de mando integral para flujos de trabajo de IA. Ofrece acceso unificado a más de 150 modelos, ahorros de hasta el 70% en costos gracias al enrutamiento inteligente e integración perfecta.

-

Deja de gestionar múltiples APIs de LLM. Requesty unifica el acceso, optimiza los costes y garantiza la fiabilidad para tus aplicaciones de IA.