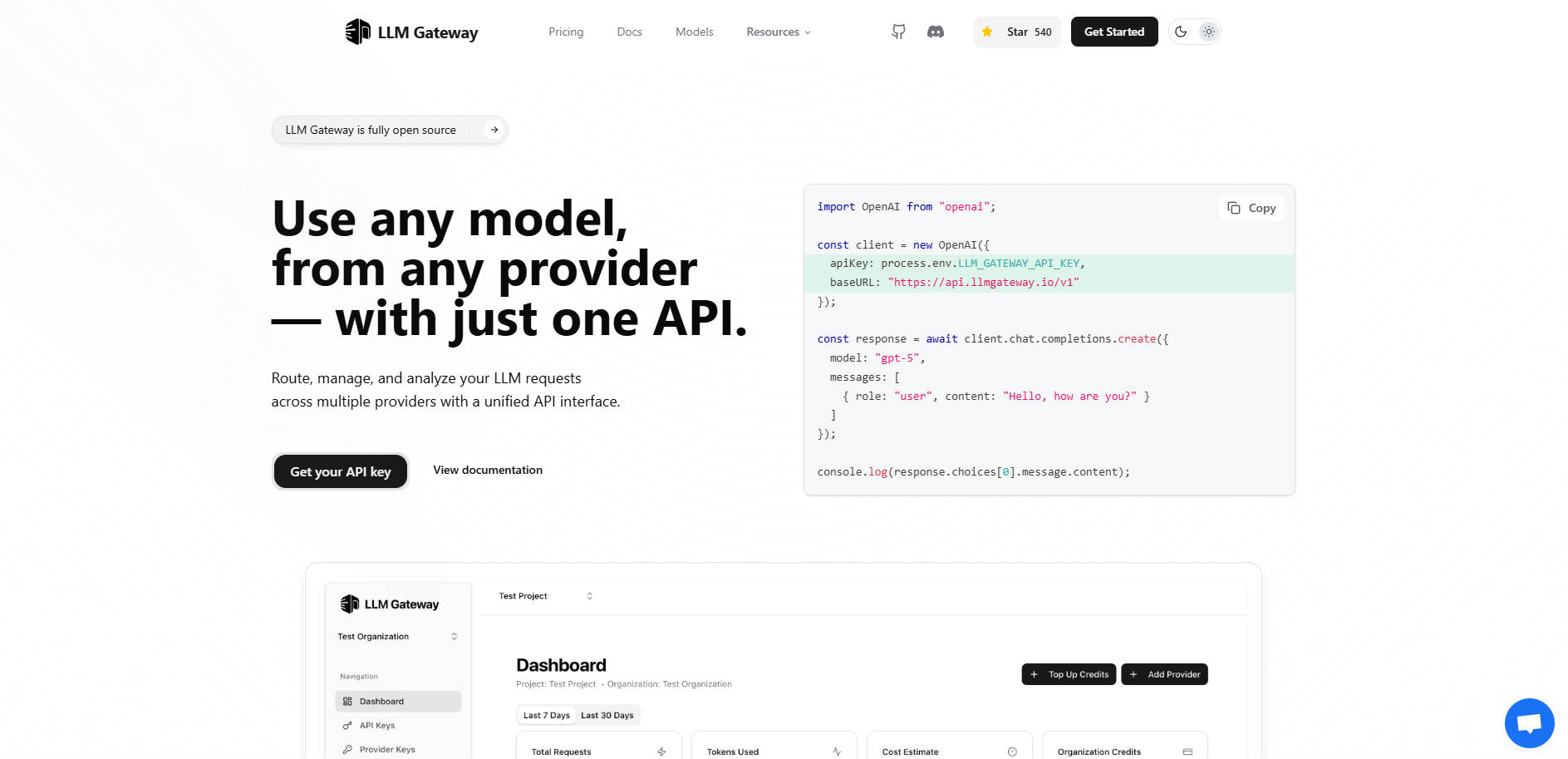

What is LLMGateway?

LLM Gatewayは、アプリケーションと多様な大規模言語モデル(LLM)プロバイダーのエコシステムとの間で、インテリジェントなミドルウェアとして機能するよう設計された、堅牢なオープンソースのAPIゲートウェイです。OpenAI、Anthropic、Google AI Studioなどの複数のAIモデルに依存するアプリケーションを構築している場合、それらを直接統合すると、複雑さが増し、ベンダーロックインのリスクが生じ、コスト追跡が分断されてしまいます。

LLM Gatewayは、お客様のLLMインフラストラクチャ全体を一元化し、単一の統合インターフェースを通じて、すべてのプロバイダーに対するルーティング、認証情報の管理、使用状況の追跡、パフォーマンス分析を可能にします。複雑なコード変更をすることなく、コストとパフォーマンスの最適化を即座にコントロールできます。

Key Features

🌐 シームレスな移行を実現する統合APIインターフェース

LLM Gatewayは、広く採用されているOpenAI API形式との互換性を維持しています。この重要な機能により、単一の標準化されたリクエスト構造を使用することで、プロバイダー固有のSDKに依存することなく、サポートされている任意のプロバイダーに接続できます。アプリケーションのコアロジックを書き換えたり、複雑なプロバイダー固有のコードを移行したりすることなく、モデルやプロバイダーを瞬時に切り替えることが可能になります。

🚦 インテリジェントなマルチプロバイダー・ルーティング

モデルの可用性、コスト、パフォーマンス要件などの基準に基づき、リクエストを最適なLLMプロバイダーに動的にルーティングします。GatewayがOpenAI、Anthropic、Google Vertex AIといったプロバイダーへの基盤となる接続を管理することで、お客様のアプリケーションはプロバイダー非依存性を保ち、単一ベンダーの障害に対する耐性を確保します。

💰 使用状況分析とコスト追跡の一元化

LLM消費に関する詳細な可視性を獲得します。LLM Gatewayは、すべてのモデルとプロバイダーにわたって、リクエスト数、消費されたトークン、実際のコストといった主要な使用状況メトリクスを自動的に追跡します。この一元化されたダッシュボードを利用することで、リアルタイムで支出を監視し、検証可能なデータに基づいて情報に基づいた予算決定を行うことができます。

⏱️ パフォーマンス監視と比較

応答時間と費用対効果を分析することで、特定のタスクに最も効率的なモデルを特定します。Gatewayは比較パフォーマンス追跡を提供し、実際の使用データに基づいて異なるモデルをベンチマークするのに役立ちます。これにより、プロンプト戦略を最適化し、速度と価値の最適なバランスを提供するモデルを選択できます。

⚙️ 柔軟なデプロイオプション

セキュリティと制御のニーズに合わせたデプロイ方法を選択してください。セットアップ不要の Hosted Version ですぐに開始することも、あるいは、お客様自身のインフラストラクチャに Self-Hosted (オープンソースコア)バージョンをデプロイすることも可能です。セルフホスティングは、最大限のデータプライバシーと、設定およびトラフィックフローの完全な制御を保証します。

Use Cases

1. A/Bテストとモデルのベンチマーク

異なるモデルに対して手動で個別のテストを設定・実行する代わりに、LLM Gatewayを通じて同一のプロンプトをルーティングし、異なる基盤モデル(例:gpt-4o と高性能なAnthropicモデルを比較)を指定することができます。内蔵のパフォーマンス追跡機能は、レイテンシ、トークン使用量、コストを即座に比較し、実際のメトリクスに基づいて最終的な本番モデルを選択することを可能にします。

2. ベンダー移行とフェイルオーバーの簡素化

異なるベンダーからより費用対効果の高い新しいモデルがリリースされた場合や、フェイルオーバー戦略が必要な場合でも、LLM Gatewayは大規模なリファクタリングの必要性を排除します。お客様のアプリケーションはGatewayの統合APIとのみ通信するため、Gatewayレイヤー内でルーティング設定またはモデルパラメータを更新するだけで、瞬時の移行やフェイルオーバー保護が実現します。

3. リアルタイムでの予算管理

複数のプロジェクトを管理する開発チームにとって、LLM Gatewayは支出の統合されたビューを提供します。どのアプリケーションや特定のAPIキーが最も高いトークン使用量を引き起こしているかを監視でき、これにより、プロダクトオーナーは非効率性を迅速に特定し、使用量の上限を設定したり、定義された予算制約内に収まるようにモデルの選択を調整したりすることができます。

Why Choose LLM Gateway?

LLM Gatewayは、個々のプロバイダーAPIに直接接続する場合とは異なり、柔軟性、制御性、機能の深さを独自に組み合わせたものを提供します。

オープンソースコアとエンタープライズオプション: コアとなるルーティングと監視機能はオープンソース(AGPLv3)であり、技術チームにLLMトラフィックフローに対する完全な透明性と制御を提供します。大規模な組織向けには、エンタープライズライセンスが高度な請求、チーム管理、優先サポートといった重要な機能を提供します。

真のベンダー非依存性: すべてのプロバイダーにOpenAI API標準を利用することで、LLM Gatewayはお客様のアプリケーションアーキテクチャを将来にわたって対応可能なものにします。新しいLLMプロバイダーを試したり、完全に移行したりする場合でも、お客様のコードベースは安定したままです。

データ制御: セルフホスト型のデプロイオプションにより、お客様のLLMリクエストデータとAPIトラフィックは既存のインフラストラクチャ内に保持され、厳格なコンプライアンス要件とセキュリティ要件を満たします。

Conclusion

LLM Gatewayは、洗練されたマルチモデルAIアプリケーションを効率的かつ費用対効果の高い方法で構築するために必要な、不可欠なコントロールプレーンを提供します。これにより、分断されたAPI統合が、単一で管理しやすく、高度に最適化されたサービスレイヤーへと変革されます。LLM戦略を掌握し、アーキテクチャを簡素化し、今日からパフォーマンスの最適化を始めましょう。

LLM Gatewayがお客様のAIインフラストラクチャをどのように一元化できるか、ぜひご確認ください。