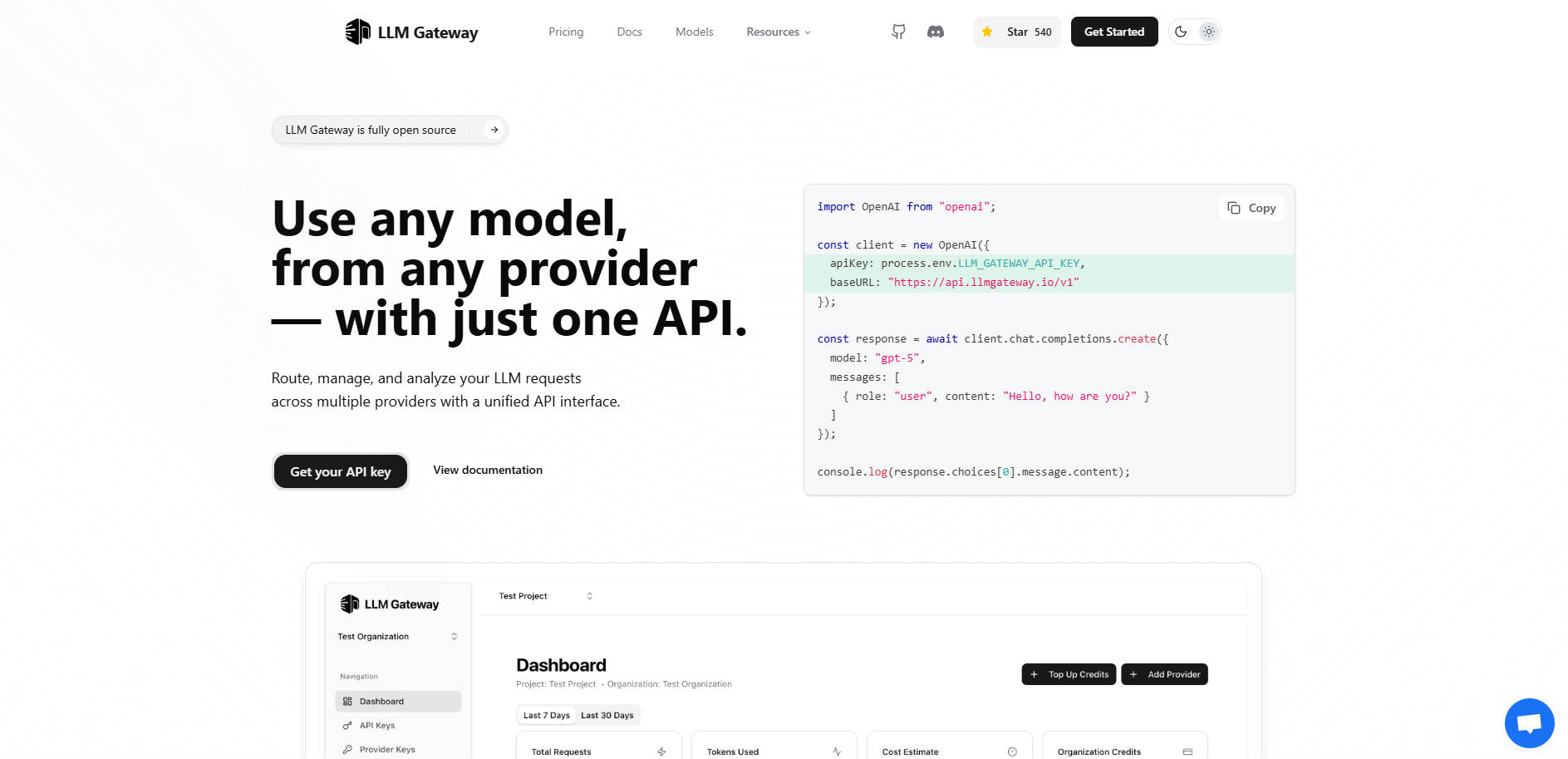

What is LLMGateway?

LLM Gateway – это мощный API-шлюз с открытым исходным кодом, разработанный для работы в качестве интеллектуальной прослойки между вашим приложением и разнообразной экосистемой поставщиков больших языковых моделей (LLM). Если вы создаете приложения, которые опираются на несколько моделей ИИ (таких как OpenAI, Anthropic или Google AI Studio), их прямая интеграция создает сложности, риск привязки к поставщику и разрозненный учет затрат.

LLM Gateway централизует всю вашу инфраструктуру LLM, позволяя маршрутизировать запросы, управлять учетными данными, отслеживать использование и анализировать производительность для всех поставщиков через единый унифицированный интерфейс. Вы получаете мгновенный контроль над расходами и оптимизацией производительности без сложных изменений в коде.

Ключевые особенности

🌐 Единый API-интерфейс для бесшовной миграции

LLM Gateway поддерживает совместимость с широко используемым форматом OpenAI API. Эта ключевая особенность означает, что вы можете подключаться к любому поддерживаемому поставщику — независимо от его нативного SDK — используя единую, стандартизированную структуру запросов. Вы можете мгновенно переключаться между моделями или поставщиками без переписывания основной логики вашего приложения или миграции сложного кода, специфичного для конкретного поставщика.

🚦 Интеллектуальная маршрутизация между несколькими поставщиками

Динамически маршрутизируйте запросы к оптимальному поставщику LLM на основе таких критериев, как доступность модели, стоимость или требования к производительности. Gateway управляет базовыми соединениями с такими поставщиками, как OpenAI, Anthropic и Google Vertex AI, гарантируя, что ваше приложение остается независимым от поставщика и устойчивым к сбоям у отдельного поставщика.

💰 Централизованная аналитика использования и отслеживание затрат

Получите глубокое понимание потребления LLM. LLM Gateway автоматически отслеживает ключевые метрики использования — включая количество запросов, потребленных токенов и фактические затраты — по всем моделям и поставщикам. Эта централизованная панель мониторинга позволяет отслеживать расходы в реальном времени и принимать обоснованные бюджетные решения на основе проверяемых данных.

⏱️ Мониторинг и сравнение производительности

Определяйте наиболее эффективные модели для конкретных задач, анализируя время отклика и экономическую эффективность. Gateway обеспечивает сравнительное отслеживание производительности, помогая вам сравнивать различные модели с вашими фактическими данными использования, чтобы вы могли оптимизировать стратегии промптов и выбирать модели, обеспечивающие наилучший баланс скорости и ценности.

⚙️ Гибкие варианты развертывания

Выберите метод развертывания, который соответствует вашим потребностям в безопасности и контроле. Вы можете начать сразу с Hosted Version без необходимости настройки, или развернуть Self-Hosted (ядро с открытым исходным кодом) версию в вашей собственной инфраструктуре. Самостоятельное размещение обеспечивает максимальную конфиденциальность данных и полный контроль над конфигурацией и потоком трафика.

Варианты использования

1. A/B-тестирование и сравнительный анализ моделей

Вместо ручной настройки и проведения отдельных тестов для разных моделей, вы можете маршрутизировать идентичные запросы через LLM Gateway, указывая различные базовые модели (например, gpt-4o по сравнению с высокопроизводительной моделью Anthropic). Встроенное отслеживание производительности мгновенно сравнивает задержку, использование токенов и стоимость, позволяя вам выбрать окончательную производственную модель на основе реальных метрик.

2. Упрощение миграции поставщиков и отказоустойчивость

Когда выпускается новая, более экономичная модель от другого поставщика, или если вам нужна стратегия аварийного переключения, LLM Gateway устраняет необходимость в обширном рефакторинге. Поскольку ваше приложение взаимодействует только с унифицированным API Gateway, вы просто обновляете конфигурацию маршрутизации или параметры модели на уровне Gateway, достигая мгновенной миграции или защиты от сбоев.

3. Управление бюджетом в реальном времени

Для команд разработки, управляющих несколькими проектами, LLM Gateway предоставляет консолидированное представление о расходах. Вы можете отслеживать, какие приложения или конкретные API-ключи приводят к наибольшему использованию токенов, что позволяет владельцам продуктов быстро выявлять неэффективность, внедрять лимиты использования или корректировать выбор моделей, чтобы оставаться в рамках определенных бюджетных ограничений.

Почему стоит выбрать LLM Gateway?

LLM Gateway предлагает уникальное сочетание гибкости, контроля и функциональной глубины, что отличает его от прямого подключения к API отдельных поставщиков.

Ядро с открытым исходным кодом и корпоративные опции: Основная функциональность маршрутизации и мониторинга имеет открытый исходный код (AGPLv3), предоставляя техническим командам полную прозрачность и контроль над потоком их LLM-трафика. Для крупных организаций корпоративная лицензия предоставляет такие важные функции, как расширенное выставление счетов, управление командами и приоритетная поддержка.

Истинная независимость от поставщика: Используя стандарт OpenAI API для всех поставщиков, LLM Gateway обеспечивает архитектуру вашего приложения, готовую к будущему. Ваша кодовая база остается стабильной, даже когда вы экспериментируете с новыми поставщиками LLM или полностью переходите на них.

Контроль данных: Опция самостоятельного развертывания гарантирует, что данные ваших запросов LLM и API-трафик остаются в вашей существующей инфраструктуре, соответствуя строгим требованиям соответствия и безопасности.

Заключение

LLM Gateway предоставляет необходимый уровень управления, требуемый для эффективного и экономически выгодного создания сложных, многомодельных приложений ИИ. Он превращает разрозненный набор API-интеграций в единый, управляемый и высокооптимизированный сервисный уровень. Возьмите под контроль свою стратегию LLM, упростите свою архитектуру и начните оптимизировать свою производительность уже сегодня.

Узнайте, как LLM Gateway может централизовать вашу инфраструктуру ИИ.

More information on LLMGateway

Top 5 Countries

Traffic Sources

LLMGateway Альтернативи

Больше Альтернативи-

Helicone AI Gateway: Унифицируйте и оптимизируйте ваши API LLM для продакшена. Повысьте производительность, снизьте затраты, обеспечьте надежность благодаря интеллектуальной маршрутизации и кэшированию.

-

Envoy AI Gateway является проектом с открытым исходным кодом, предназначенным для использования Envoy Gateway для обработки трафика запросов от клиентских приложений к сервисам Generative AI.

-

-

-