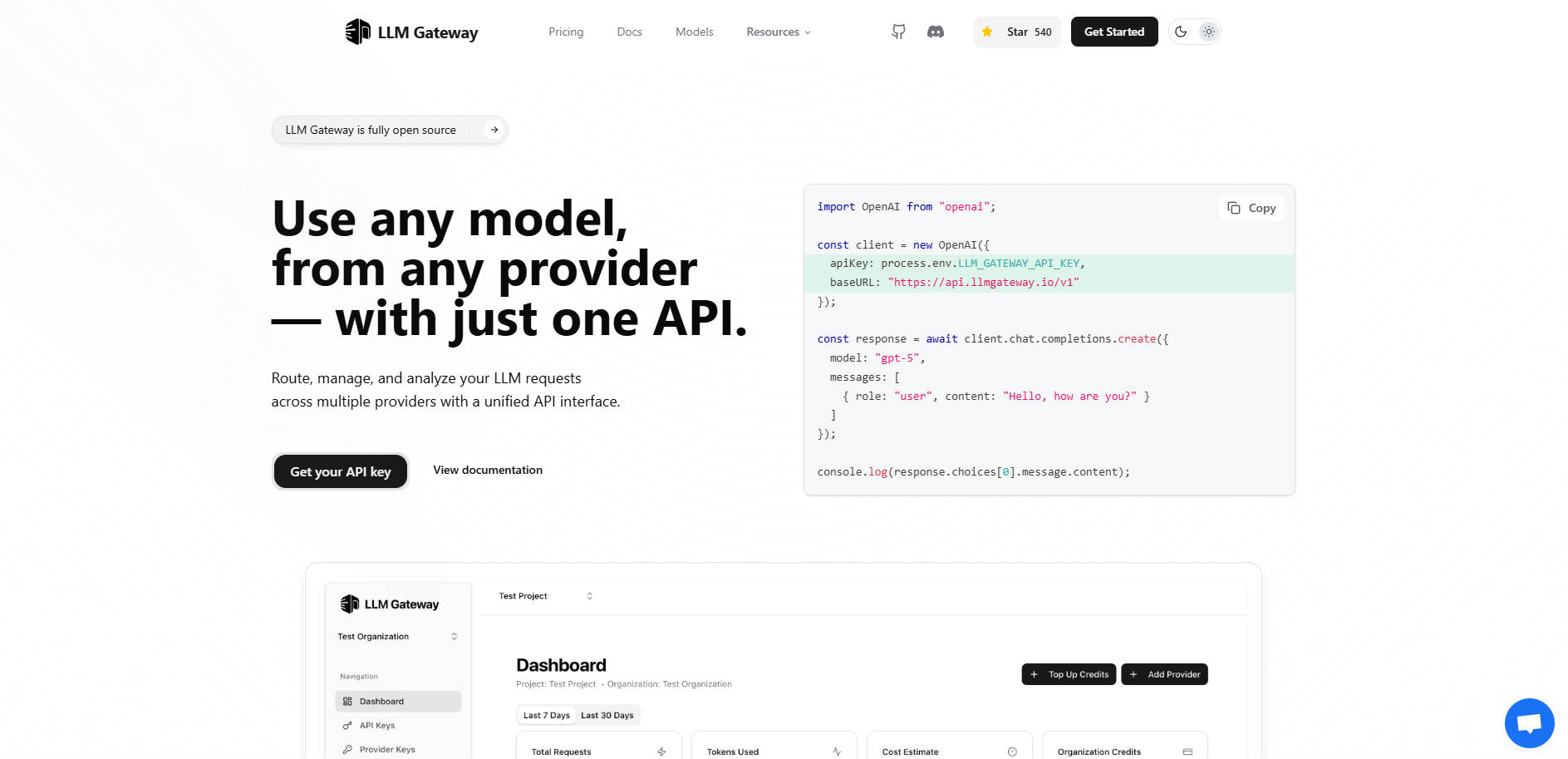

What is LLMGateway?

LLM Gateway 是一款强大而开源的 API 网关,旨在充当您的应用程序与庞大的大型语言模型(LLM)提供商生态系统之间的智能中间件。如果您的应用程序依赖于多个 AI 模型(例如 OpenAI、Anthropic 或 Google AI Studio),直接集成这些模型会带来复杂性、供应商锁定风险以及碎片化的成本追踪。

LLM Gateway 集中管理您的整个 LLM 基础设施,让您能够通过一个统一的接口,跨所有提供商进行路由、管理凭证、追踪用量和分析性能。您可以立即掌控成本和性能优化,而无需进行复杂的代码改动。

核心功能

🌐 统一API接口,实现无缝迁移

LLM Gateway 兼容业界广泛采用的 OpenAI API 格式。这一关键特性意味着,无论提供商的原生SDK如何,您都可以通过单一、标准化的请求结构连接到任何受支持的提供商。您可以即时切换模型或提供商,无需重写核心应用逻辑或迁移复杂的特定于提供商的代码。

🚦 智能多提供商路由

根据模型可用性、成本或性能要求等标准,动态地将请求路由到最优的 LLM 提供商。Gateway 管理与 OpenAI、Anthropic 和 Google Vertex AI 等提供商的底层连接,确保您的应用程序与特定提供商无关,并能抵御单一供应商中断。

💰 集中用量分析与成本追踪

深入洞察您的 LLM 消耗情况。LLM Gateway 自动追踪所有模型和提供商的关键用量指标,包括请求数量、消耗的 token 以及实际成本。这一集中式仪表板允许您实时监控支出,并基于可验证数据做出明智的预算决策。

⏱️ 性能监控与比较

通过分析响应时间与成本效益,识别特定任务最有效的模型。Gateway 提供比较性性能追踪,帮助您根据实际使用数据对不同模型进行基准测试,从而优化提示策略,并选择在速度和价值之间实现最佳平衡的模型。

⚙️ 灵活部署选项

选择符合您安全和控制需求的部署方式。您可以立即使用**托管版本**,实现零配置快速上手;或在您自己的基础设施上部署**自托管**(开源核心)版本。自托管能确保最大程度的数据隐私,并对配置和流量拥有完全控制权。

应用场景

1. A/B 测试与模型基准化

无需手动为不同模型配置和运行单独的测试,您可以通过 LLM Gateway 路由相同的提示,并指定不同的底层模型(例如 gpt-4o 与高性能 Anthropic 模型)。内置的性能追踪功能会即时比较延迟、token 用量和成本,从而帮助您根据真实世界指标选择最终的生产模型。

2. 简化供应商迁移与故障转移

当不同供应商发布了新的、更具成本效益的模型,或者您需要故障转移策略时,LLM Gateway 消除了进行大量重构的必要。因为您的应用程序只与 Gateway 的统一 API 通信,您只需在 Gateway 层内更新路由配置或模型参数,即可实现即时迁移或故障转移保护。

3. 实时预算管理

对于管理多个项目的开发团队,LLM Gateway 提供集中的支出视图。您可以监控哪些应用程序或特定的 API 密钥导致了最高的 token 使用量,从而让产品负责人能够迅速发现低效率问题、设置使用上限或调整模型选择,以便在既定的预算限制内运行。

为何选择 LLM Gateway?

LLM Gateway 提供了灵活性、控制力和功能深度的独特组合,使其有别于直接连接单个提供商 API 的方式。

开源核心,兼具企业级选项: 核心路由和监控功能是开源的 (AGPLv3),让技术团队对其 LLM 流量拥有完全的透明度和控制权。对于大型组织,企业许可证提供关键功能,例如高级计费、团队管理和优先支持。

真正的供应商无关性: 通过对所有提供商采用 OpenAI API 标准,LLM Gateway 使您的应用架构具备面向未来的能力。即使您尝试或完全转向新的 LLM 提供商,您的代码库也能保持稳定。

数据自主控制: 自托管部署选项确保您的 LLM 请求数据和 API 流量保留在您现有的基础设施中,满足严格的合规性和安全要求。

总结

LLM Gateway 提供了构建高效且经济的多模型 AI 应用程序所需的核心控制平面。它将零散的 API 集成转化为一个单一、易于管理且高度优化的服务层。掌控您的 LLM 策略,简化您的架构,并立即开始优化您的性能。

探索 LLM Gateway 如何集中管理您的 AI 基础设施。