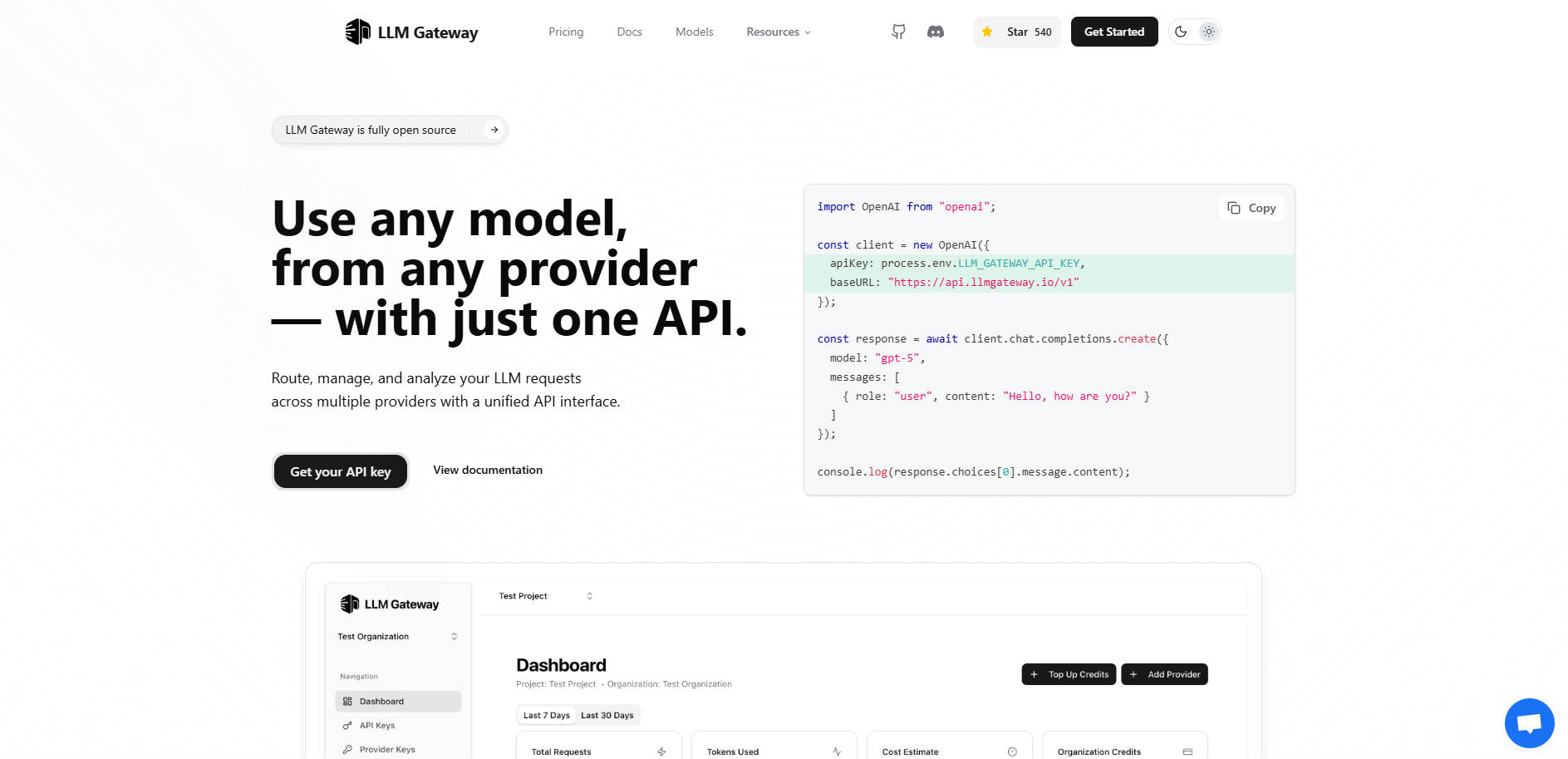

What is LLMGateway?

LLM Gateway est une passerelle API robuste et open-source, conçue pour agir comme un intergiciel intelligent entre votre application et l'écosystème diversifié des fournisseurs de modèles de langage de grande taille (LLM). Si vous développez des applications qui reposent sur plusieurs modèles d'IA (tels que OpenAI, Anthropic ou Google AI Studio), les intégrer directement engendre de la complexité, un risque de dépendance vis-à-vis d'un fournisseur unique (vendor lock-in) et un suivi des coûts fragmenté.

LLM Gateway centralise l'intégralité de votre infrastructure LLM, vous permettant d'acheminer les requêtes, de gérer les identifiants, de suivre l'utilisation et d'analyser les performances à travers tous les fournisseurs via une interface unique et unifiée. Vous obtenez un contrôle immédiat sur les coûts et l'optimisation des performances sans modifications complexes de votre code.

Principales Fonctionnalités

🌐 Interface API Unifiée pour une Migration Transparente

LLM Gateway maintient la compatibilité avec le format d'API OpenAI largement adopté. Cette fonctionnalité essentielle signifie que vous pouvez vous connecter à n'importe quel fournisseur pris en charge — indépendamment de son SDK natif — en utilisant une structure de requête unique et standardisée. Vous pouvez changer de modèle ou de fournisseur instantanément sans réécrire la logique principale de votre application ni migrer de code complexe spécifique à un fournisseur.

🚦 Routage Intelligent Multi-Fournisseurs

Acheminez les requêtes de manière dynamique vers le fournisseur LLM optimal en fonction de critères tels que la disponibilité du modèle, le coût ou les exigences de performance. La Gateway gère les connexions sous-jacentes aux fournisseurs comme OpenAI, Anthropic et Google Vertex AI, garantissant que votre application reste indépendante des fournisseurs et résiliente aux pannes d'un fournisseur unique.

💰 Analyse Centralisée de l'Utilisation et Suivi des Coûts

Obtenez une visibilité approfondie sur votre consommation de LLM. LLM Gateway suit automatiquement les métriques d'utilisation clés — y compris le nombre de requêtes, les jetons consommés et les coûts réels — pour tous les modèles et fournisseurs. Ce tableau de bord centralisé vous permet de surveiller les dépenses en temps réel et de prendre des décisions budgétaires éclairées basées sur des données vérifiables.

⏱️ Suivi et Comparaison des Performances

Identifiez les modèles les plus efficaces pour des tâches spécifiques en analysant les temps de réponse et la rentabilité. La Gateway fournit un suivi comparatif des performances, vous aidant à évaluer différents modèles par rapport à vos données d'utilisation réelles afin d'optimiser les stratégies de prompt et de sélectionner les modèles offrant le meilleur équilibre entre vitesse et valeur.

⚙️ Options de Déploiement Flexibles

Choisissez la méthode de déploiement qui correspond à vos besoins en matière de sécurité et de contrôle. Vous pouvez démarrer immédiatement avec la Hosted Version pour une mise en service instantanée, ou déployer la version Self-Hosted (noyau open-source) sur votre propre infrastructure. L'auto-hébergement garantit une confidentialité maximale des données et un contrôle total sur la configuration et le flux de trafic.

Cas d'Usage

1. Tests A/B et Évaluation Comparative des Modèles

Au lieu de configurer et d'exécuter manuellement des tests distincts pour différents modèles, vous pouvez acheminer des prompts identiques via LLM Gateway, en spécifiant différents modèles sous-jacents (par exemple, gpt-4o vs. un modèle Anthropic haute performance). Le suivi des performances intégré compare instantanément la latence, l'utilisation des jetons et le coût, vous permettant de sélectionner le modèle de production définitif basé sur des métriques réelles.

2. Simplification de la Migration et du Basculement (Failover) entre Fournisseurs

Lorsqu'un nouveau modèle plus rentable est publié par un fournisseur différent, ou si vous avez besoin d'une stratégie de basculement, LLM Gateway élimine le besoin de refactorisation poussée. Étant donné que votre application ne communique qu'avec l'API unifiée de la Gateway, il vous suffit de mettre à jour la configuration de routage ou le paramètre du modèle au sein de la couche Gateway, réalisant ainsi une migration instantanée ou une protection par basculement.

3. Gestion Budgétaire en Temps Réel

Pour les équipes de développement gérant plusieurs projets, LLM Gateway offre une vue consolidée des dépenses. Vous pouvez surveiller quelles applications ou clés API spécifiques sont à l'origine de la plus forte consommation de jetons, permettant aux chefs de produit d'identifier rapidement les inefficacités, de mettre en œuvre des plafonds d'utilisation ou d'ajuster les choix de modèles pour rester dans les limites budgétaires définies.

Pourquoi Choisir LLM Gateway ?

LLM Gateway offre une combinaison unique de flexibilité, de contrôle et de profondeur fonctionnelle qui le distingue de la connexion directe aux API de fournisseurs individuels.

Noyau Open-Source avec Options Entreprise : La fonctionnalité de routage et de surveillance est open-source (AGPLv3), offrant aux équipes techniques une transparence et un contrôle total sur le flux de trafic de leurs LLM. Pour les grandes organisations, la licence Entreprise offre des fonctionnalités essentielles telles que la facturation avancée, la gestion d'équipe et le support prioritaire.

Véritable Agnosticisme Fournisseur : En utilisant le standard OpenAI API pour tous les fournisseurs, LLM Gateway pérennise l'architecture de votre application. Votre base de code reste stable même lorsque vous expérimentez ou passez entièrement à de nouveaux fournisseurs de LLM.

Contrôle des Données : L'option de déploiement auto-hébergé garantit que vos données de requête LLM et votre trafic API restent au sein de votre infrastructure existante, satisfaisant ainsi aux exigences strictes de conformité et de sécurité.

Conclusion

LLM Gateway fournit le plan de contrôle essentiel nécessaire pour construire des applications d'IA sophistiquées et multi-modèles de manière efficace et économique. Il transforme un ensemble fragmenté d'intégrations API en une couche de service unique, gérable et hautement optimisée. Prenez le contrôle de votre stratégie LLM, simplifiez votre architecture et commencez à optimiser vos performances dès aujourd'hui.

Découvrez comment LLM Gateway peut centraliser votre infrastructure d'IA.

More information on LLMGateway

Top 5 Countries

Traffic Sources

LLMGateway alternatives

LLMGateway alternatives-

Helicone AI Gateway : Unifiez et optimisez vos API LLM pour la production. Améliorez les performances, réduisez les coûts et garantissez la fiabilité grâce au routage intelligent et à la mise en cache.

-

Envoy AI Gateway est un projet open source destiné à utiliser Envoy Gateway pour prendre en charge le trafic de requêtes provenant des applications clientes vers les services d'IA générative.

-

Déployez plus rapidement vos fonctionnalités d’IA grâce à la passerelle unifiée de MegaLLM. Accédez à Claude, GPT-5, Gemini, Llama et plus de 70 modèles via une seule API. Inclut des analyses intégrées, des mécanismes intelligents de repli et un suivi de l’utilisation.

-

LangDB AI Gateway est votre centre de commande tout-en-un pour les flux de travail d'IA. Il offre un accès unifié à plus de 150 modèles, des économies de coûts allant jusqu'à 70 % grâce au routage intelligent, et une intégration transparente.

-

Ne gérez plus de multiples API LLM. Requesty unifie l'accès, optimise les coûts et assure la fiabilité de vos applications d'IA.