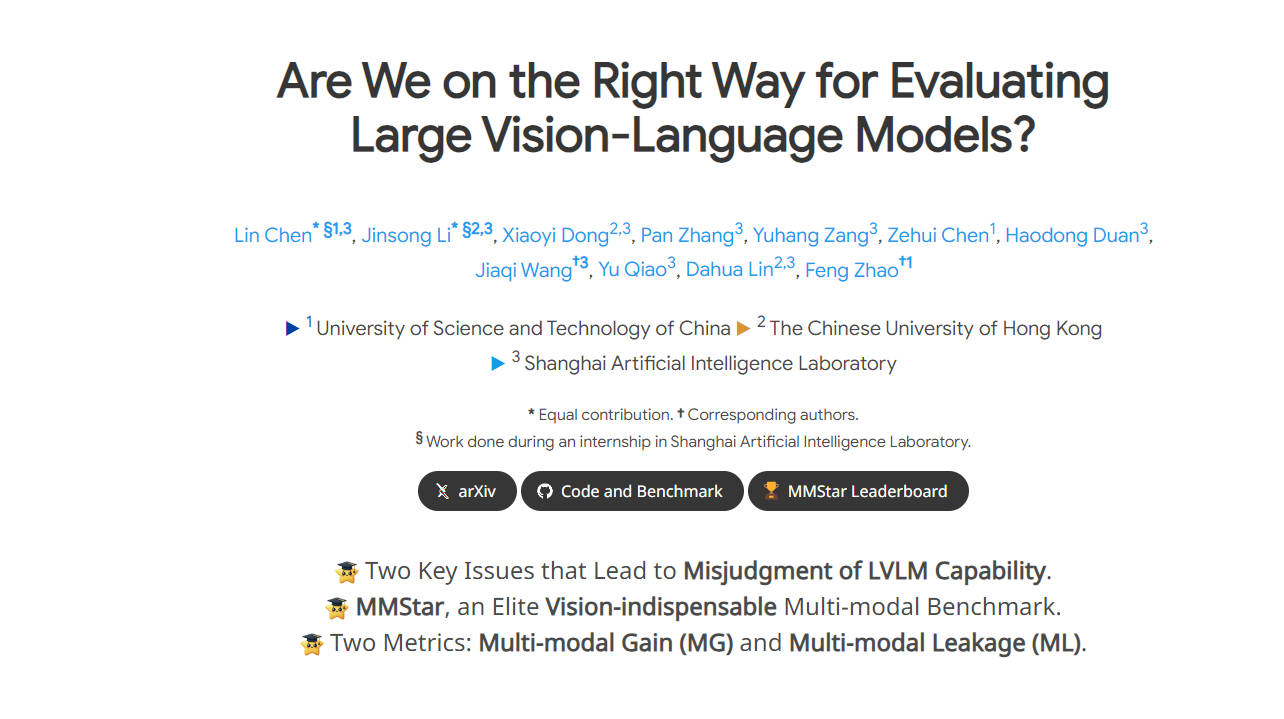

What is MMStar?

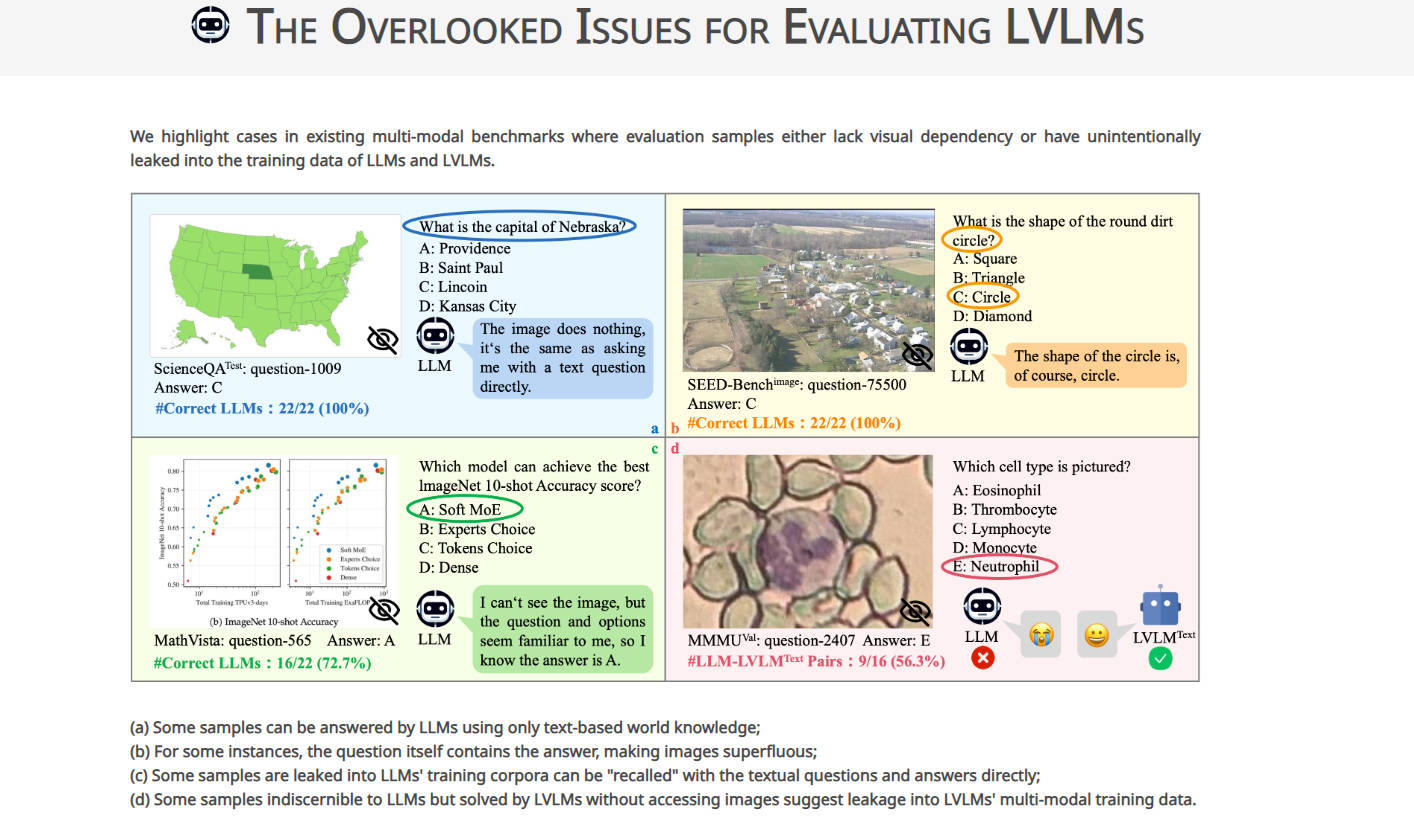

MMStar es un punto de referencia innovador diseñado para abordar problemas clave en la evaluación de los Grandes Modelos de Lenguaje de Visión (LVLMs). Selecciona meticulosamente muestras de desafío para evaluar las capacidades multimodales de los LVLMs, con el objetivo de eliminar la filtración de datos y medir con precisión las ganancias de rendimiento. Al proporcionar un conjunto de muestras equilibrado y purificado, MMStar mejora la credibilidad de la evaluación de LVLM, ofreciendo información valiosa para la comunidad investigadora.

Características principales:

-

Muestras meticulosamente seleccionadas: MMStar comprende 1500 muestras de desafío elegidas meticulosamente para exhibir dependencia visual y capacidades multimodales avanzadas. ?

-

Evaluación integral: MMStar evalúa los LVLMs en 6 capacidades principales y 18 ejes detallados, asegurando una evaluación exhaustiva del rendimiento multimodal. ?

-

Nuevas métricas de evaluación: Además de las métricas de precisión tradicionales, MMStar introduce dos métricas para medir la filtración de datos y la ganancia de rendimiento real en la formación multimodal, proporcionando información más profunda sobre las capacidades de LVLM. ?

Casos de uso:

-

Investigación académica: Los investigadores pueden utilizar MMStar para evaluar con precisión las capacidades multimodales de los LVLMs, guiando nuevos avances en el campo.

-

Desarrollo de modelos: Los desarrolladores pueden aprovechar MMStar para identificar áreas de mejora en los LVLMs y refinar sus modelos para un rendimiento multimodal mejorado.

-

Comparación de puntos de referencia: MMStar permite el análisis comparativo del rendimiento de los LVLMs en diferentes puntos de referencia, lo que facilita la toma de decisiones informada en la selección de modelos.

Conclusión:

MMStar revoluciona la evaluación de los Grandes Modelos de Lenguaje de Visión al abordar problemas críticos de filtración de datos y medición del rendimiento. Con sus muestras meticulosamente seleccionadas y nuevas métricas de evaluación, MMStar permite a los investigadores y desarrolladores tomar decisiones informadas e impulsar los avances en la tecnología de IA multimodal. Únase a nosotros en la adopción de MMStar para desbloquear todo el potencial de los LVLMs e impulsar el campo hacia adelante.