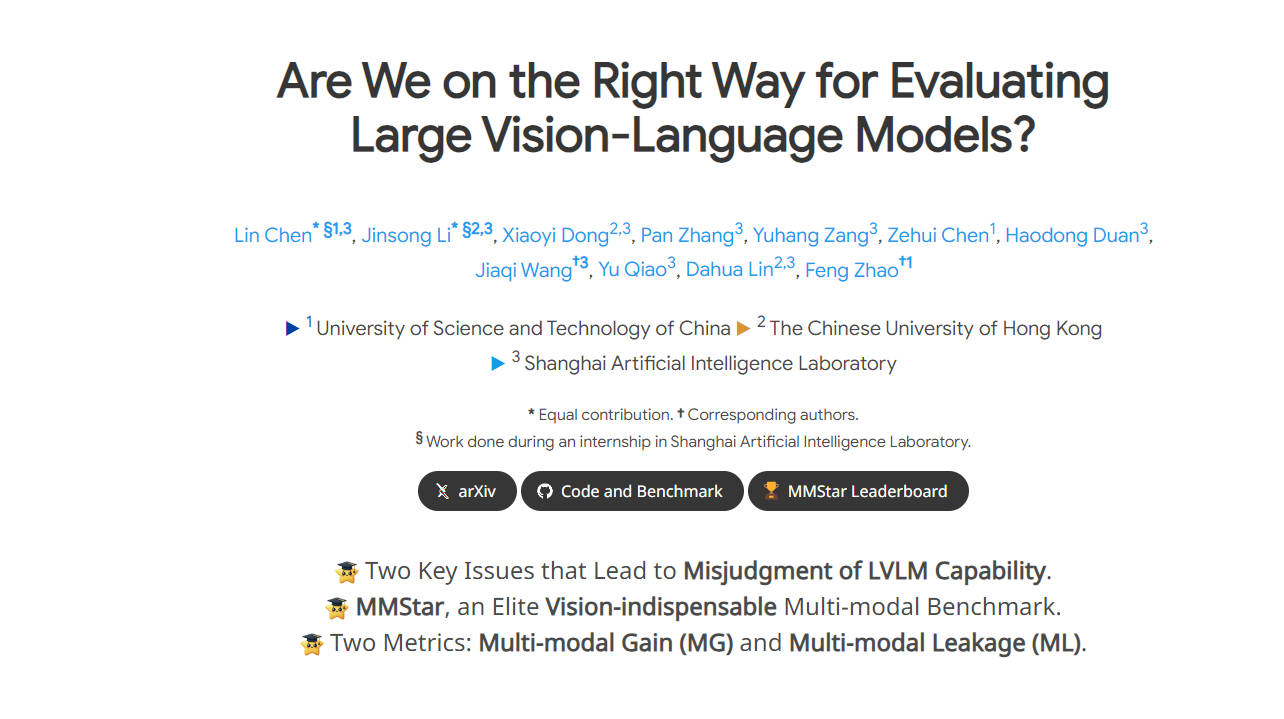

What is MMStar?

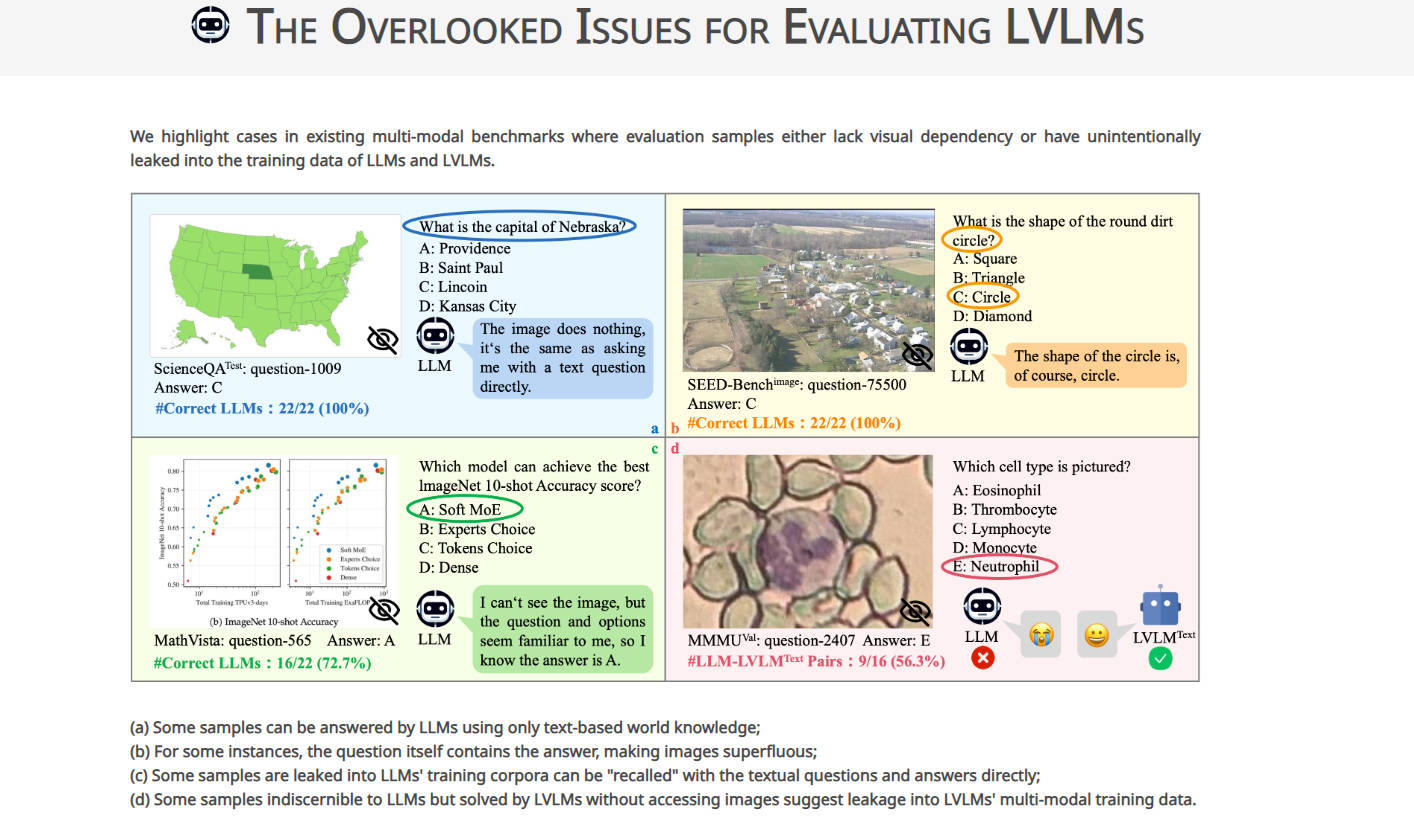

MMStar est une référence révolutionnaire conçue pour aborder les questions clés de l'évaluation des grands modèles de vision-langage (LVLMs). Il sélectionne minutieusement des échantillons de défis pour évaluer les capacités multimodales des LVLMs, visant à éliminer les fuites de données et à mesurer avec précision les gains de performance. En fournissant un ensemble d'échantillons équilibré et purifié, MMStar renforce la crédibilité de l'évaluation LVLM, offrant des informations précieuses à la communauté des chercheurs.

Caractéristiques principales :

Échantillons méticuleusement sélectionnés : MMStar comprend 1 500 échantillons de défis soigneusement choisis pour présenter une dépendance visuelle et des capacités multimodales avancées. ?

Évaluation complète : MMStar évalue les LVLMs sur 6 capacités de base et 18 axes détaillés, garantissant une évaluation approfondie des performances multimodales. ?

Métriques d'évaluation innovantes : outre les métriques de précision traditionnelles, MMStar introduit deux métriques pour mesurer les fuites de données et les gains de performances réels dans la formation multimodale, fournissant des informations plus approfondies sur les capacités des LVLMs. ?

Cas d'utilisation :

Recherche universitaire : les chercheurs peuvent utiliser MMStar pour évaluer avec précision les capacités multimodales des LVLMs, guidant les progrès futurs dans ce domaine.

Développement de modèles : les développeurs peuvent exploiter MMStar pour identifier les domaines à améliorer dans les LVLMs et affiner leurs modèles pour des performances multimodales améliorées.

Comparaison de référence : MMStar permet une analyse comparative des performances des LVLMs sur différentes références, facilitant la prise de décision éclairée dans la sélection des modèles.

Conclusion :

MMStar révolutionne l'évaluation des grands modèles de vision-langage en abordant les questions critiques des fuites de données et de la mesure des performances. Avec ses échantillons soigneusement sélectionnés et ses nouvelles métriques d'évaluation, MMStar permet aux chercheurs et aux développeurs de prendre des décisions éclairées et de faire progresser la technologie de l'IA multimodale. Rejoignez-nous pour adopter MMStar afin de libérer tout le potentiel des LVLMs et de faire avancer le secteur.