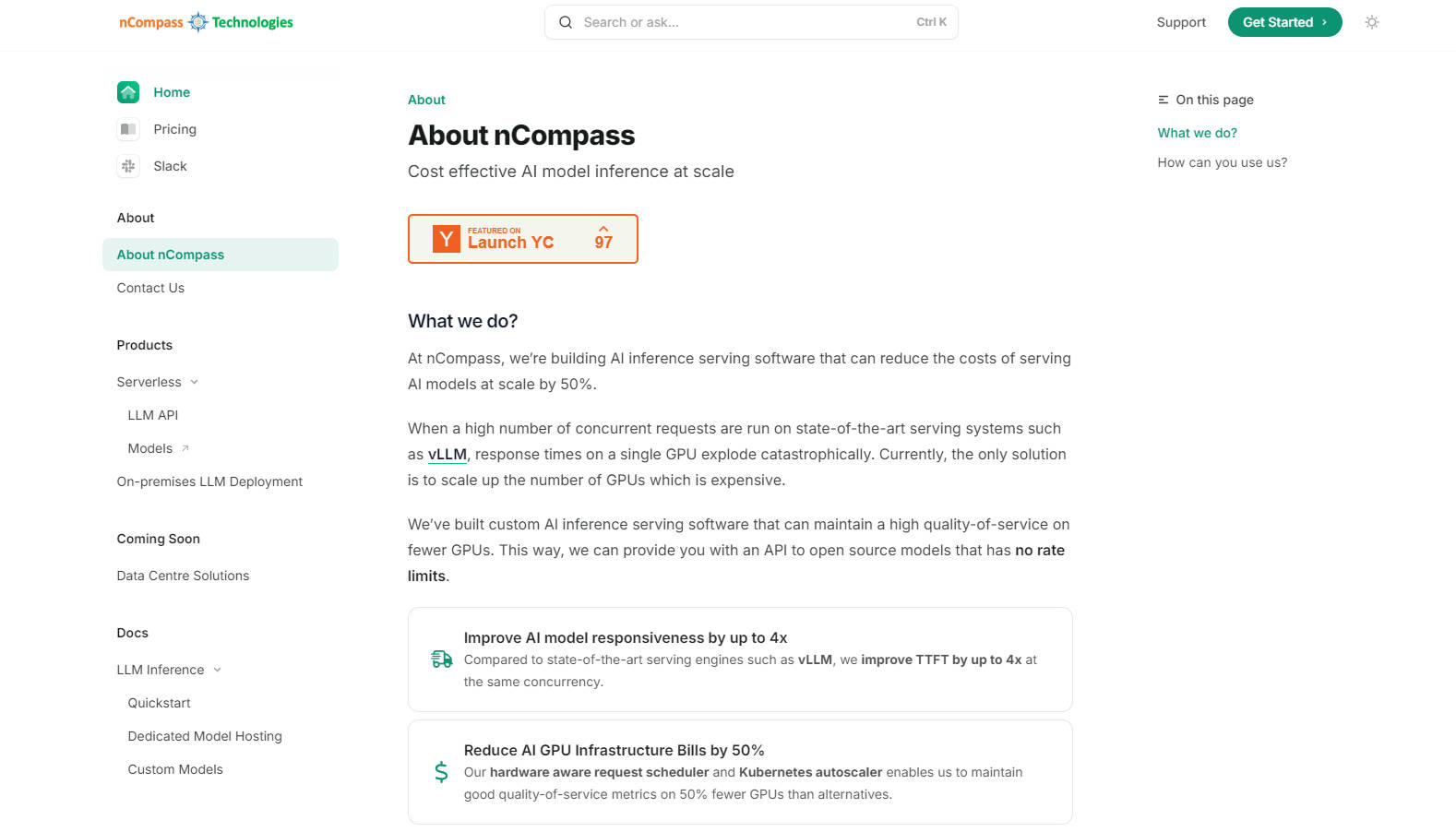

What is NCompass?

nCompass ofrece una solución optimizada para alojar y acelerar modelos de lenguaje extenso (LLM) de código abierto y personalizados. Elimina la complejidad de gestionar la infraestructura de IA a la vez que proporciona acceso rápido a la API, sin límites de velocidad, a modelos potentes. Con nCompass, puede seleccionar el modelo deseado, establecer los requisitos de rendimiento y presupuesto, e integrarlo a la perfección en su pipeline de IA, todo ello con costes predecibles y una mayor capacidad de respuesta.

Características principales:

? Alojamiento acelerado de modelos: nCompass proporciona un alojamiento optimizado para modelos de código abierto, reduciendo los tiempos de respuesta hasta en 4 veces en comparación con otros motores de servicio.

? Escalado rentable: Reduzca los costes de infraestructura de GPU en un 50 % con el software de inferencia de IA personalizado de nCompass, que maximiza la eficiencia con menos GPUs.

? API sin límites de velocidad: Disfrute de un acceso fluido y escalable a los LLM sin límites de velocidad, garantizando un rendimiento fiable incluso con una alta demanda.

?️ Implementación flexible: Elija entre servicios totalmente gestionados u opciones autogestionadas para un mayor control sobre su infraestructura.

Casos de uso:

Startups de IA: Una startup de IA en crecimiento que utiliza productos basados en LLM se enfrenta a tiempos de respuesta lentos y límites de velocidad con modelos de código cerrado. Al cambiar a nCompass, pueden alojar modelos de código abierto con tiempos de respuesta más rápidos y costes de infraestructura reducidos, lo que les permite centrarse en el desarrollo de productos.

Soluciones empresariales: Una gran empresa necesita una solución LLM personalizada con implementación local para la privacidad y el control de los datos. La opción autogestionada de nCompass les permite integrar el servicio de IA optimizado en su infraestructura existente manteniendo un alto rendimiento.

Instituciones de investigación: Un equipo de investigación necesita acceder a varios modelos de código abierto para sus experimentos. Con nCompass, pueden cambiar fácilmente entre modelos, establecer restricciones de rendimiento y presupuesto, y escalar sus esfuerzos de investigación sin preocuparse por la gestión de la infraestructura.

Conclusión:

nCompass simplifica el proceso de alojamiento y aceleración de LLM de código abierto y personalizados, ofreciendo una solución rentable, escalable y de alto rendimiento. Al elegir nCompass, obtiene acceso a modelos potentes sin la carga de gestionar una infraestructura compleja, lo que le permite concentrarse en sus objetivos principales de negocio o investigación.

More information on NCompass

Top 5 Countries

Traffic Sources

NCompass Alternativas

Más Alternativas-

-

LLM Gateway: Unifica y optimiza las APIs de LLM de múltiples proveedores. Enruta de forma inteligente, monitoriza los costes y potencia el rendimiento para OpenAI, Anthropic y más. De código abierto.

-

OpenCompass es un conjunto de aplicaciones y una plataforma de evaluación completa, eficiente y de código abierto, diseñado para grandes modelos.

-

Helicone AI Gateway: Unifica y optimiza tus APIs de LLM para producción. Potencia el rendimiento, reduce costes y garantiza la fiabilidad con enrutamiento inteligente y almacenamiento en caché.

-