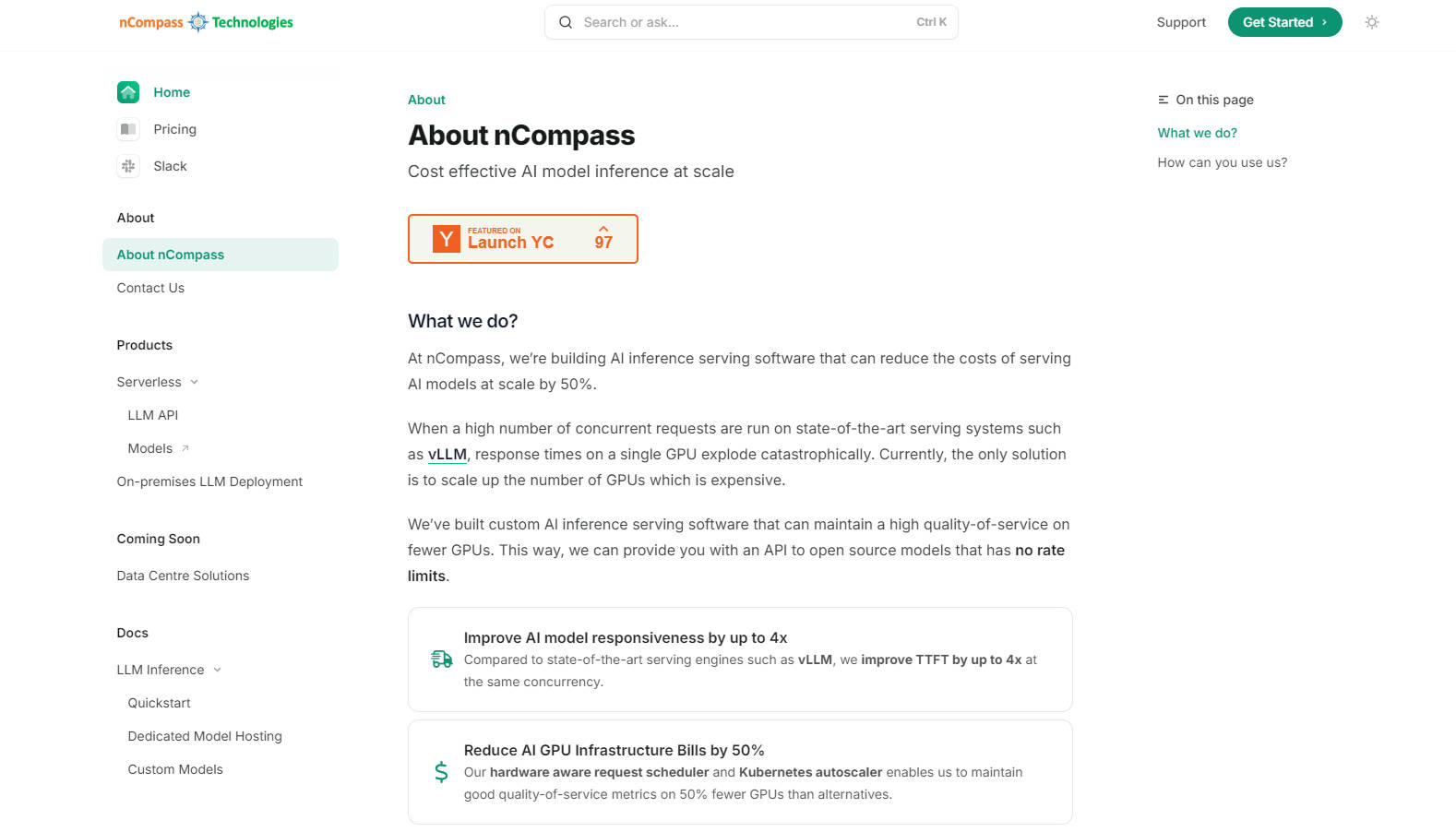

What is NCompass?

nCompass 提供了一种简化的解决方案,用于托管和加速开源和自定义大型语言模型 (LLM)。它消除了管理 AI 基础设施的麻烦,同时提供对强大模型的快速、无速率限制的 API 访问。使用 nCompass,您可以选择所需的模型,设置性能和预算要求,并将其无缝集成到您的 AI 管道中——所有这些都具有可预测的成本和更高的响应速度。

主要功能:

? 加速模型托管:nCompass 为开源模型提供优化的托管,与其他服务引擎相比,响应时间缩短高达 4 倍。

? 经济高效的扩展:使用 nCompass 的自定义 AI 推理软件,将 GPU 基础设施成本降低 50%,从而在更少的 GPU 上实现效率最大化。

? 无速率限制的 API:享受无缝、可扩展的 LLM 访问,无需速率限制,即使在高需求下也能确保可靠的性能。

?️ 灵活的部署:在完全托管的服务和自托管选项之间进行选择,以便更好地控制您的基础设施。

使用案例:

AI 初创公司:一家使用基于 LLM 的产品的快速发展的 AI 初创公司面临着闭源模型响应时间慢和速率限制的问题。通过切换到 nCompass,他们可以使用开源模型获得更快的响应时间和降低的基础设施成本,从而专注于产品开发。

企业解决方案:大型企业需要具有本地部署的自定义 LLM 解决方案,以确保数据隐私和控制。nCompass 的自托管选项允许他们将优化的 AI 服务集成到其现有基础设施中,同时保持高性能。

研究机构:一个研究团队需要访问各种开源模型进行实验。使用 nCompass,他们可以轻松地在模型之间切换,设置性能和预算限制,并在无需担心基础设施管理的情况下扩展其研究工作。

结论:

nCompass 简化了托管和加速开源和自定义 LLM 的过程,提供了一种经济高效、可扩展且高性能的解决方案。选择 nCompass,您可以访问强大的模型,而无需承担管理复杂基础设施的负担,从而能够专注于您的核心业务或研究目标。