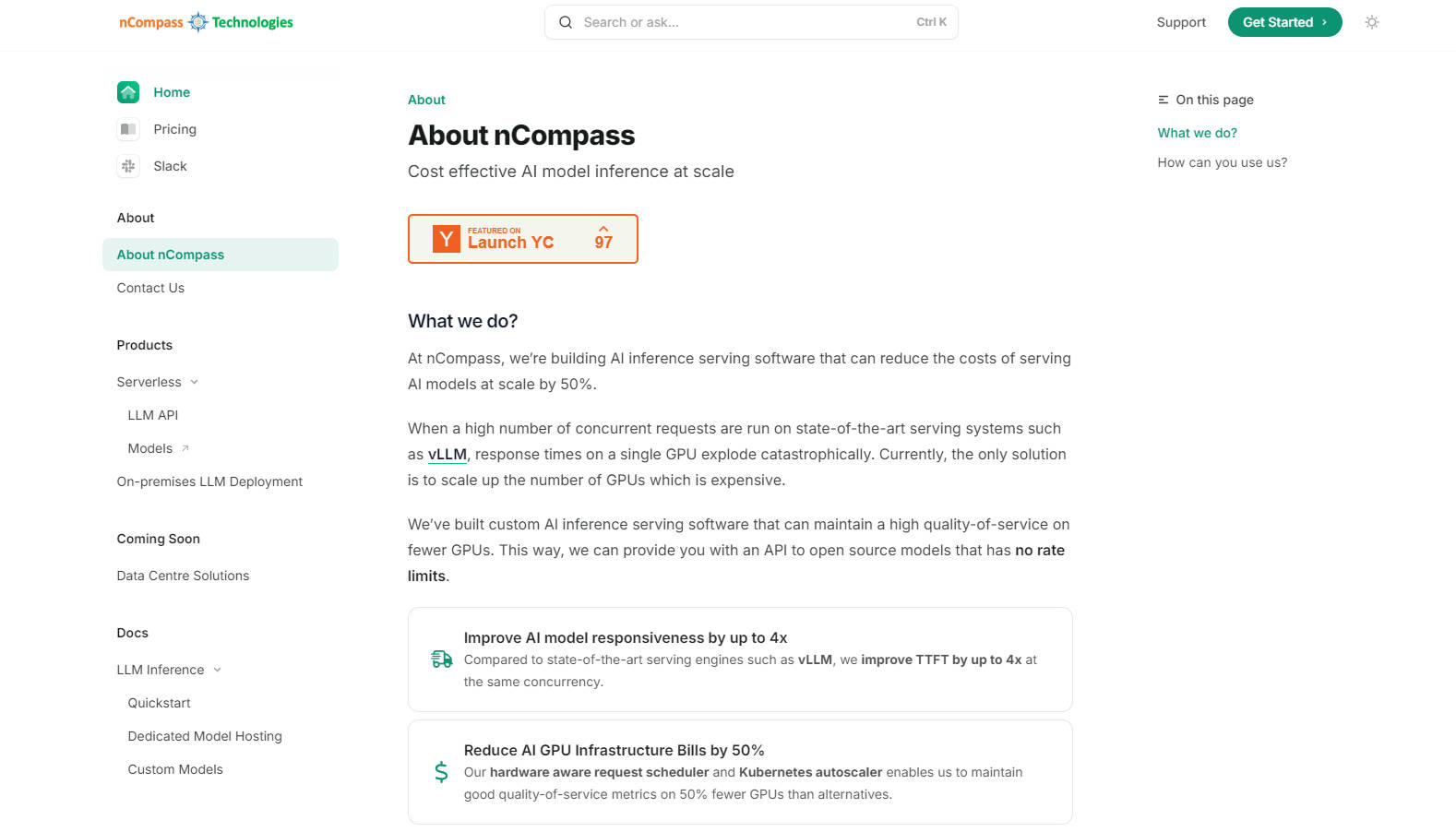

What is NCompass?

nCompass offre une solution simplifiée pour l'hébergement et l'accélération de modèles linguistiques volumineux (LLM) open-source et personnalisés. Il élimine les tracas liés à la gestion de l'infrastructure IA tout en fournissant un accès API rapide et sans limitation de débit à des modèles puissants. Avec nCompass, vous pouvez sélectionner le modèle souhaité, définir les exigences de performance et de budget, et l'intégrer de manière transparente à votre pipeline IA – le tout avec des coûts prévisibles et une meilleure réactivité.

Fonctionnalités clés :

? Hébergement accéléré des modèles : nCompass fournit un hébergement optimisé pour les modèles open-source, réduisant les temps de réponse jusqu'à 4 fois par rapport aux autres moteurs de service.

? Mise à l'échelle économique : Réduisez les coûts d'infrastructure GPU de 50 % grâce au logiciel d'inférence IA personnalisé de nCompass, qui maximise l'efficacité avec moins de GPU.

? API sans limitation de débit : Bénéficiez d'un accès transparent et évolutif aux LLM sans limitation de débit, garantissant des performances fiables même en cas de forte demande.

?️ Déploiement flexible : Choisissez entre des services entièrement gérés ou des options autogérées pour un meilleur contrôle de votre infrastructure.

Cas d'utilisation :

Startups IA : Une startup IA en pleine croissance utilisant des produits basés sur les LLM est confrontée à des temps de réponse lents et à des limitations de débit avec les modèles propriétaires. En passant à nCompass, elle peut héberger des modèles open-source avec des temps de réponse plus rapides et des coûts d'infrastructure réduits, lui permettant de se concentrer sur le développement de produits.

Solutions d'entreprise : Une grande entreprise a besoin d'une solution LLM personnalisée avec un déploiement sur site pour la confidentialité et le contrôle des données. L'option autogérée de nCompass lui permet d'intégrer un service IA optimisé à son infrastructure existante tout en maintenant des performances élevées.

Instituts de recherche : Une équipe de recherche a besoin d'accéder à divers modèles open-source pour ses expériences. Avec nCompass, elle peut facilement passer d'un modèle à un autre, définir des contraintes de performance et de budget, et adapter ses efforts de recherche sans se soucier de la gestion de l'infrastructure.

Conclusion :

nCompass simplifie le processus d'hébergement et d'accélération des LLM open-source et personnalisés, offrant une solution économique, évolutive et performante. En choisissant nCompass, vous accédez à des modèles puissants sans le fardeau de la gestion d'une infrastructure complexe, vous permettant de vous concentrer sur vos objectifs commerciaux ou de recherche.

More information on NCompass

Top 5 Countries

Traffic Sources

NCompass Alternatives

Plus Alternatives-

-

LLM Gateway : Unifiez et optimisez les API de LLM multi-fournisseurs. Acheminez intelligemment les requêtes, suivez les coûts et boostez les performances pour OpenAI, Anthropic et bien d'autres. Open-source.

-

OpenCompass est une suite et une plateforme d'évaluation complète, efficace et open-source, conçue pour les modèles volumineux.

-

Helicone AI Gateway : Unifiez et optimisez vos API LLM pour la production. Améliorez les performances, réduisez les coûts et garantissez la fiabilité grâce au routage intelligent et à la mise en cache.

-