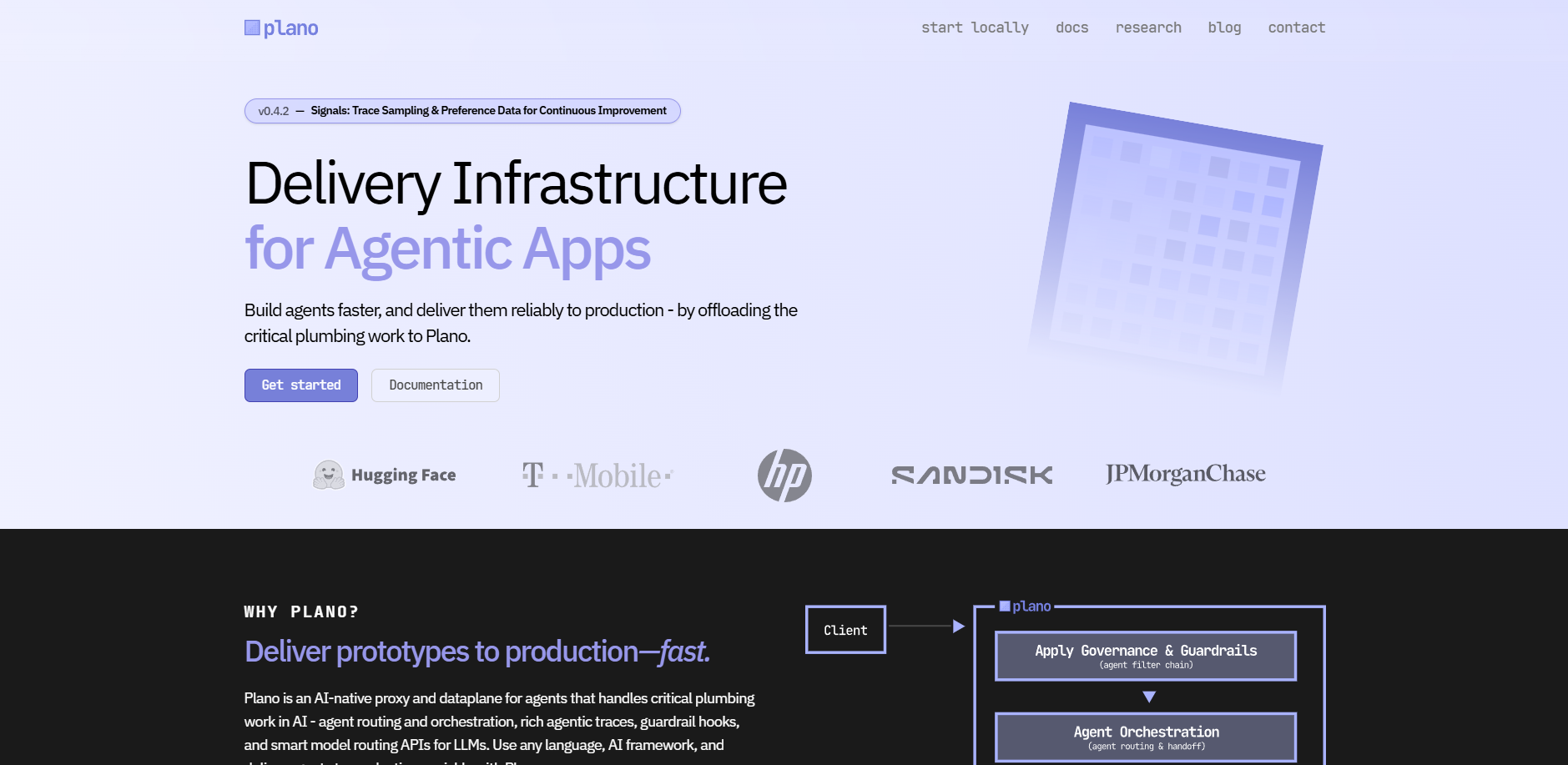

What is Plano ?

Construir un prototipo de agente de IA suele ser sencillo, pero llevar ese agente a un entorno de producción es notoriamente complejo. Los desarrolladores suelen quedar atrapados construyendo una «capa intermedia oculta de IA»: la plomería repetitiva necesaria para enrutamiento, salvaguardas de seguridad y observabilidad que normalmente ensucia el código de la aplicación.

Plano es una infraestructura de entrega nativa para IA y un plano de datos diseñado para asumir esta plomería crítica. Al actuar como un proxy profesional entre tu aplicación y tus modelos de lenguaje (LLMs), Plano centraliza la orquestación, la seguridad y la monitorización. Así, tu equipo puede centrarse en perfeccionar la lógica del agente y la experiencia del usuario, en lugar de gestionar la sobrecarga de infraestructura.

Características clave

- 🚦 Orquestación independiente del framework: Plano gestiona el enrutamiento de baja latencia entre múltiples agentes y LLMs sin requerir cambios en el código de tu aplicación. Al trasladar la orquestación a un plano de datos centralizado, puedes evolucionar tus estrategias de enrutamiento y añadir nuevos agentes sin riesgo de acoplamiento estrecho ni duplicación de código.

- 🛡️ Salvaguardas y filtros centralizados: Protege tus aplicaciones con protección integrada contra jailbreaks, políticas de contenido y flujos contextuales. Estas «cadenas de filtros» se aplican a nivel del plano de datos, garantizando seguridad y gobernanza coherentes en toda tu pila sin reimplementar lógica en cada servicio.

- 🔗 Agilidad de modelo independiente del proveedor: Enruta solicitudes por nombre de modelo, alias semántico o preferencia automática para mantenerte desacoplado de proveedores específicos. El enrutamiento inteligente y la API unificada de Plano te permiten cambiar o añadir modelos al instante, gestionando automáticamente reintentos y conmutaciones por fallo para asegurar disponibilidad continua.

- 🕵 Señales Agentic™ sin código: Captura automáticamente trazas detalladas de comportamiento, uso de tokens y métricas de rendimiento en cada interacción. Basado en los estándares OpenTelemetry y W3C, Plano ofrece una visibilidad profunda del rendimiento y latencia del agente (TFT/TOT) sin necesidad de instrumentación manual.

- 🏗️ Arquitectura sidecar nativa del protocolo: Construido sobre Envoy Proxy, probado en entornos exigentes, Plano se ejecuta como un proceso autónomo junto a tu aplicación. Este modelo sidecar evita la «tasa de bibliotecas», permitiéndole funcionar con cualquier lenguaje de programación —incluidos Python, Java y Go— mientras escala linealmente con tu tráfico.

Casos de uso

Escalar flujos de trabajo multiagente

En sistemas complejos donde distintos agentes manejan codificación, investigación e introducción de datos, Plano actúa como controlador de tráfico. Analiza la intención del usuario y el contexto de la conversación para enrutar la solicitud al agente más adecuado o a una secuencia de agentes, garantizando la mayor precisión posible para la tarea específica.

Estandarizar la seguridad empresarial

Para equipos de ingeniería que operan en entornos regulados, Plano ofrece un único punto de control para políticas de seguridad. Puedes aplicar enmascaramiento, ganchos de recuperación y filtros anti-jailbreak en todas las interacciones agentic de la empresa, asegurando que el cumplimiento normativo se aplique a nivel de infraestructura, en lugar de depender de implementaciones individuales por parte de los desarrolladores.

Benchmarking y migración rápida de modelos

Si se lanza un nuevo LLM más rentable, puedes usar Plano para redirigir un porcentaje de tu tráfico al nuevo proveedor para pruebas. Como tu aplicación se comunica con la API unificada de Plano, puedes cambiar proveedores backend o actualizar versiones de modelos directamente en el archivo de configuración, sin refactorizar ni una sola línea de código de la aplicación.

¿Por qué elegir Plano?

Plano se distingue al alejarse de las frágiles abstracciones basadas en bibliotecas que actualmente dominan el panorama de la IA.

- Base preparada para producción: Mientras muchas herramientas se construyen como envoltorios alrededor de frameworks de IA específicos, Plano se basa en Envoy Proxy, la misma tecnología utilizada por empresas como Google, Stripe y Netflix para gestionar tráfico a escala masiva.

- Modelos de lenguaje especializados por tarea (TLMs): A diferencia de los proxies convencionales, Plano emplea modelos especializados de alta eficiencia (como Plano-Orchestrator), diseñados específicamente para enrutamiento rápido y preciso, así como para llamadas a funciones.

- Desacoplamiento operativo: Al ejecutarse fuera del proceso de la aplicación, Plano permite actualizar tu infraestructura de IA, modificar políticas de seguridad o ajustar el enrutamiento de modelos de forma independiente del ciclo de despliegue de tu aplicación. Esto reduce drásticamente el «dolor insoportable» de gestionar dependencias de bibliotecas entre múltiples microservicios.

Conclusión

Plano transforma la manera en que los equipos pasan de experimentos de IA a aplicaciones fiables y escalables en producción. Al estandarizar la «capa intermedia oculta» de las aplicaciones agentic, proporciona la estabilidad y observabilidad necesarias para una entrega profesional de software. Obtienes la libertad de iterar sobre la inteligencia central de tus agentes, confiando en una base robusta y escalable que gestiona las complejidades del moderno stack de IA.

More information on Plano

Plano Alternativas

Plano Alternativas-

Plandex AI: Agente de codificación de IA. Desarrolle software del mundo real de manera productiva con inteligencia artificial. Gestione proyectos de gran envergadura y controle las modificaciones impulsadas por la IA con un flujo de trabajo diseñado para desarrolladores.

-

PilottAI es un framework de Python diseñado para la creación de sistemas multiagente autónomos con capacidades de orquestación avanzadas. Ofrece funcionalidades de nivel empresarial para el desarrollo de aplicaciones de IA escalables impulsadas por modelos de lenguaje de gran tamaño.

-

Pylar se sitúa entre tus agentes y tus bases de datos. Tú defines qué datos pueden acceder, construyes herramientas personalizadas sobre ellos y obtienes observabilidad completa en todas tus implementaciones de IA.

-

TaskingAI aporta la simplicidad de Firebase al desarrollo de aplicaciones nativas de IA. Inicia tu proyecto seleccionando un modelo LLM, desarrolla un asistente responsivo respaldado por APIs con estado, y potencia sus capacidades con memoria gestionada, integraciones de herramientas y un sistema de generación aumentada.

-

Crea agentes de IA y aplicaciones LLM con observabilidad, evaluaciones y analítica de repetición. Olvídate de las cajas negras y las conjeturas al crear *prompts*.