What is StreamingLLM?

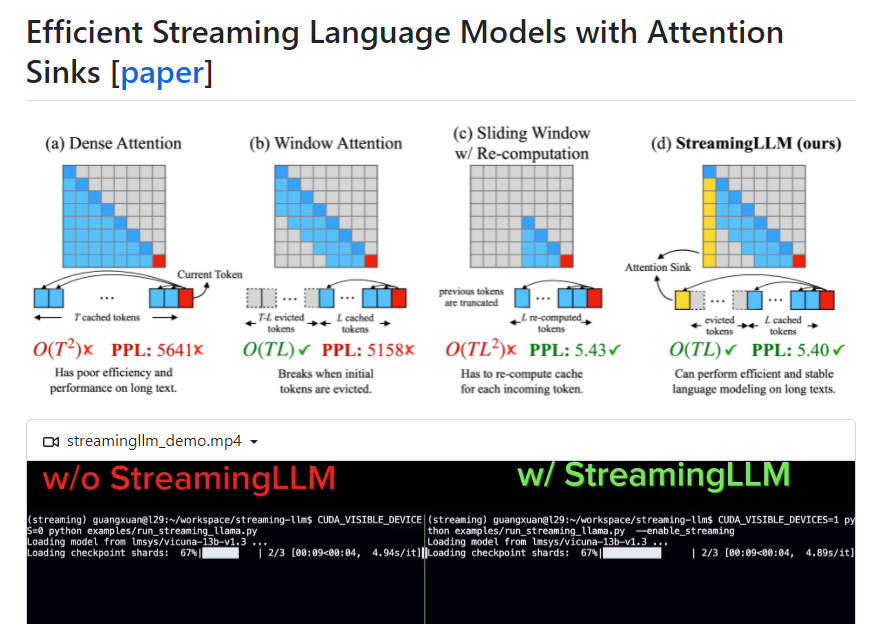

StreamingLLM es un marco de trabajo eficiente que permite implementar modelos de lenguaje grande (LLM) en aplicaciones de transmisión sin sacrificar la eficiencia ni el rendimiento. Aborda los desafíos del almacenamiento en caché de estados de valores y claves (KV) de tokens anteriores durante la decodificación y la incapacidad de los LLM populares para generalizarse a textos más largos que su longitud de secuencia de entrenamiento. Al introducir sumideros de atención y conservar los KV de tokens iniciales, StreamingLLM permite que los LLM entrenados con una ventana de atención de longitud finita manejen longitudes de secuencia infinitas sin ajustes. Supera las líneas de base de recálculo de ventanas deslizantes con una aceleración de hasta 22,2 x.

Características clave:

1. Implementación eficiente: StreamingLLM permite que los LLM se utilicen en aplicaciones de transmisión sin comprometer la eficiencia o el rendimiento.

2. Sumideros de atención: al mantener los KV de tokens iniciales como sumideros de atención, StreamingLLM recupera el rendimiento de la atención de la ventana incluso cuando la longitud del texto supera el tamaño de la caché.

3. Generalización a longitud de secuencia infinita: con StreamingLLM, los LLM pueden manejar entradas de cualquier longitud sin necesidad de un restablecimiento de caché o sacrificar la coherencia.

4. Implementación de transmisión mejorada: agregar un token de marcador de posición como sumidero de atención dedicado durante el preentrenamiento mejora aún más la implementación de transmisión.

5. Optimización de la velocidad: en configuraciones de transmisión, StreamingLLM logra una aceleración de hasta 22,2 x en comparación con las líneas de base de recálculo de ventanas deslizantes.

Casos de uso:

1. Diálogos multironda: StreamingLLM está optimizado para escenarios donde los modelos necesitan un funcionamiento continuo sin un uso extensivo de memoria o dependencia de datos pasados, lo que lo hace ideal para diálogos multironda.

2. Asistentes diarios basados en LLM: con StreamingLLM, los asistentes diarios pueden funcionar continuamente y generar respuestas basadas en conversaciones recientes sin requerir actualizaciones de caché o recálculos que consuman mucho tiempo.

StreamingLLM es un marco de trabajo eficiente que permite la implementación de LLM en aplicaciones de transmisión manteniendo un alto rendimiento y eficiencia. Al introducir sumideros de atención y conservar los KV de tokens iniciales, StreamingLLM permite que los LLM manejen longitudes de secuencia infinitas sin ajustes. Es particularmente útil para diálogos multironda y asistentes diarios basados en LLM, ofreciendo una implementación de transmisión mejorada y optimizaciones de velocidad significativas en comparación con los métodos tradicionales.