What is StreamingLLM?

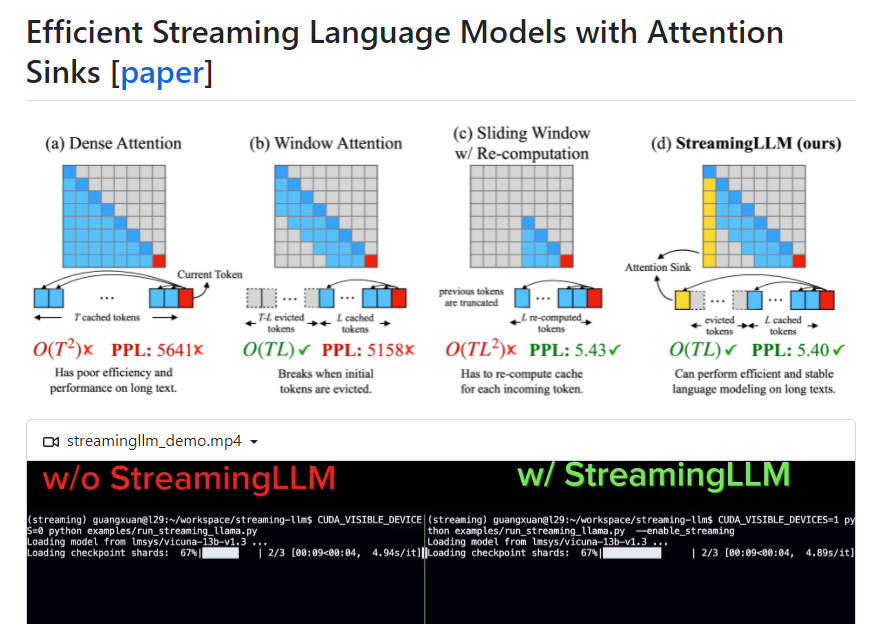

StreamingLL 是一个有效框架,支持在大规模语言模型 (LLM) 中使用流式应用,而不会影响效率和性能。它解决了之前的令牌、键值状态 (KV) 在流式应用中的挑战,并允许流行的 LLM 处理比其训练序列长度更长的文本。通过将最初令牌的注意吸入点和缓存保留,StreamingLL 使 LLM 得以使用有限长度的注意窗口来处理无限序列,而无需微调。与窗口重新计算基准相比,其性能提升最多可达 100 倍。

主要功能

* 效率:StreamingLL 使 LLM 可用于流式应用,而不会影响其效率或性能。 * 注意吸入点:通过将最初令牌保留为注意吸入点,StreamingLL 即使在文本长度超过缓存大小时,也能保持窗口注意的性能。 * 概括无限序列长度:使用 StreamingLL,LLM 可以处理任何长度的输入,而无需缓存重置或时间重置。 * 流式优化:在流式设置中,StreamingLL 的速度优化在与窗口重新计算基准的对比中提升了最多 100 倍。用例

* 多轮流式应用:StreamingLL 针对多轮应用进行了优化,模型在其中持续运行,而无需大量内存使用或依赖过去数据,这使其非常适合多轮流式应用。 * 基于 LLM 的日常辅助工具:使用 StreamingLL,每日辅助工具可以在不需缓存刷新或时间重置的情况下持续运行,并在近期对话的基础上生成回复。 StreamingLL 是一个有效框架,支持在流式应用中使用 LLM,同时保持高性能和高效率。通过将最初令牌的注意吸入点和缓存保留,StreamingLL 使 LLM 得以利用有限长度的注意窗口处理无限序列,而无需微调。它特别适用于多轮流式应用和基于 LLM 的日常辅助工具,与传统方法相比,其流式化和速度均有显著优化。

More information on StreamingLLM

Launched

2024

Pricing Model

Free

Starting Price

Global Rank

Follow

Month Visit

<5k

Tech used

Related Searches