What is StreamingLLM?

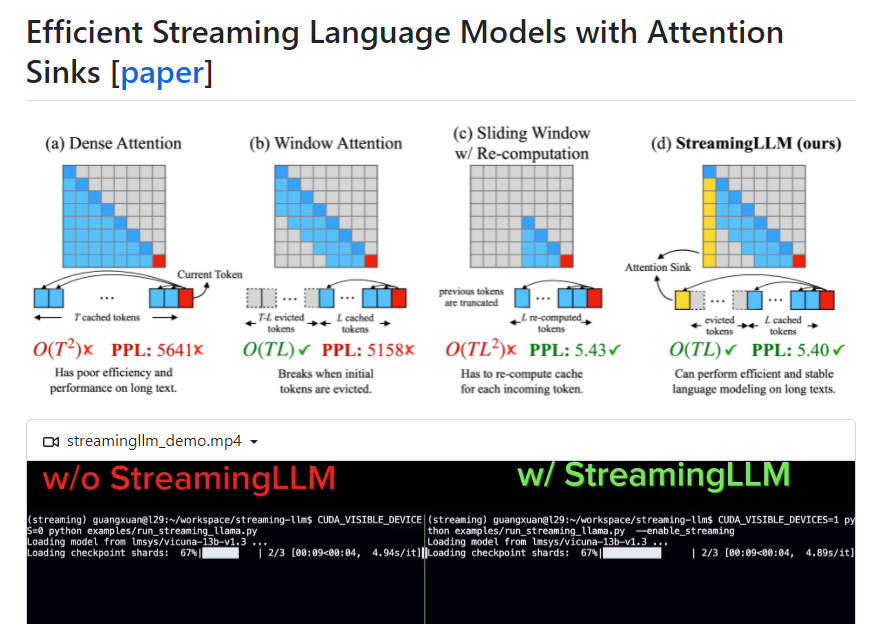

StreamingLLMは、効率性とパフォーマンスを犠牲にすることなく、大規模言語モデル(LLM)をストリーミングアプリケーションで展開できるようにする効率的なフレームワークです。デコーディング中に以前のトークンのキーと値の状態(KV)をキャッシュすることの課題と、人気のあるLLMがトレーニングシーケンスの長さよりも長いテキストに一般化できないという問題に対処します。StreamingLLMはアテンションシンクを導入し、初期トークンのKVを保持することで、有限の長さのアテンションウィンドウでトレーニングされたLLMが微調整することなく無限のシーケンス長を処理できるようにします。スライドウィンドウの再計算ベースラインよりも最大22.2倍高速化します。

主な機能:

1. 効率的な展開: StreamingLLMにより、効率性やパフォーマンスを損なうことなく、ストリーミングアプリケーションでLLMを使用できます。

2. アテンションシンク: 初期トークンのKVをアテンションシンクとして保持することで、StreamingLLMはテキストの長さがキャッシュサイズを超えても、ウィンドウアテンションのパフォーマンスを回復します。

3. 無限のシーケンス長への一般化: StreamingLLMを使用すると、LLMはキャッシュのリセットや首尾一貫性の損失を必要とせずに任意の長さの入力を処理できます。

4. ストリーミング展開の改善: 事前トレーニング中に専用のアテンションシンクとしてプレースホルダートークンを追加することで、ストリーミング展開がさらに強化されます。

5. 速度の最適化: ストリーミング設定では、StreamingLLMはスライドウィンドウ再計算ベースラインと比較して最大22.2倍の高速化を実現します。

ユースケース:

1. マルチラウンドダイアログ: StreamingLLMは、モデルが大量のメモリ使用や過去のデータへの依存なしに継続的な操作を必要とするシナリオ用に最適化されており、マルチラウンドダイアログに最適です。

2. LLMベースの日常アシスタント: StreamingLLMを使用すると、日常アシスタントは継続的に機能し、キャッシュの更新や時間のかかる再計算を必要とせずに、最近の会話に基づいて応答を生成できます。

StreamingLLMは、高性能と効率性を維持しながら、ストリーミングアプリケーションでのLLMの展開を可能にする効率的なフレームワークです。アテンションシンクを導入し、初期トークンのKVを保持することで、StreamingLLMはLLMが微調整することなく無限のシーケンス長を処理できるようにします。これは、マルチラウンドダイアログやLLMベースの日常アシスタントに特に有用であり、従来の方法と比較してストリーミング展開の改善と大幅な速度の最適化を提供します。