What is StreamingLLM?

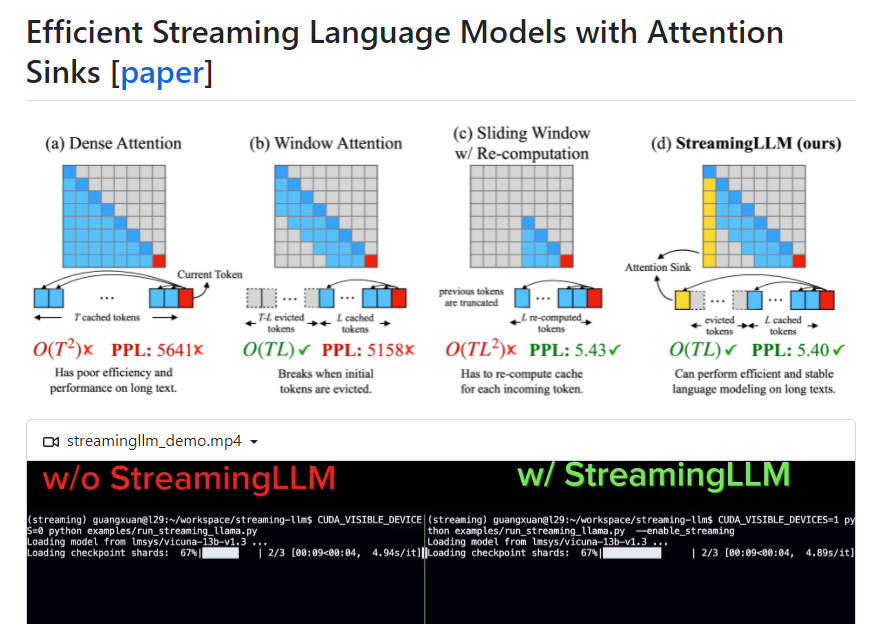

StreamingLLM은 효율성과 성능을 저하시키지 않고 스트리밍 애플리케이션에 대형 언어 모델(LLM)을 배포할 수 있게 해주는 효율적인 프레임워크입니다. 이 프레임워크는 디코딩 중에 이전 토큰의 키 및 값 상태(KV)를 캐싱하는 과제와 인기 있는 LLM이 해당 모델의 훈련 시퀀스 길이보다 긴 텍스트를 일반화할 수 없다는 점을 해결합니다. 주의 싱크를 도입하고 초기 토큰의 KV를 유지함으로써 StreamingLLM은 유한 길이 주의 창으로 훈련된 LLM이 미세 조정 없이도 무한한 시퀀스 길이를 처리할 수 있게 해줍니다. 이는 슬라이딩 윈도우 재계산 기준선보다 최대 22.2배 더 빠른 속도를 제공합니다.

주요 특징:

1. 효율적인 배포: StreamingLLM은 효율성이나 성능을 손상시키지 않고 스트리밍 애플리케이션에서 LLM을 사용할 수 있도록 해줍니다.

2. 주의 싱크: 초기 토큰의 KV를 주의 싱크로 유지함으로써 StreamingLLM은 텍스트 길이가 캐시 크기를 초과하더라도 윈도우 주의의 성능을 복구합니다.

3. 무한 시퀀스 길이로의 일반화: StreamingLLM을 사용하면 LLM이 캐시를 재설정하거나 일관성을 저하시키지 않고도 임의의 길이의 입력을 처리할 수 있습니다.

4. 개선된 스트리밍 배포: 사전 훈련 중에 전용 주의 싱크로서 플레이스홀더 토큰을 추가하면 스트리밍 배포가 더욱 향상됩니다.

5. 속도 최적화: 스트리밍 설정에서 StreamingLLM은 슬라이딩 윈도우 재계산 기준선 대비 최대 22.2배의 속도 향상을 달성합니다.

사용 사례:

1. 여러 라운드 대화: StreamingLLM은 모델이 과도한 메모리 사용이나 과거 데이터에 대한 의존 없이 지속적으로 작동해야 하는 시나리오에 최적화되어 있어 여러 라운드 대화에 이상적입니다.

2. LLM 기반 일상 업무 비서: StreamingLLM을 사용하면 일상 업무 비서가 캐시 새로 고침이나 시간 소모적인 재계산 없이 최근 대화를 기반으로 지속적으로 기능하고 응답을 생성할 수 있습니다.

StreamingLLM은 고성능과 효율성을 유지하면서 LLM을 스트리밍 애플리케이션에 배포할 수 있도록 해주는 효율적인 프레임워크입니다. StreamingLLM은 주의 싱크를 도입하고 초기 토큰의 KV를 유지함으로써 LLM이 미세 조정 없이도 무한한 시퀀스 길이를 처리할 수 있도록 해줍니다. 이 프레임워크는 특히 여러 라운드 대화와 LLM 기반 일상 업무 비서에 유용하며 전통적인 방법에 비해 개선된 스트리밍 배포와 상당한 속도 최적화를 제공합니다.