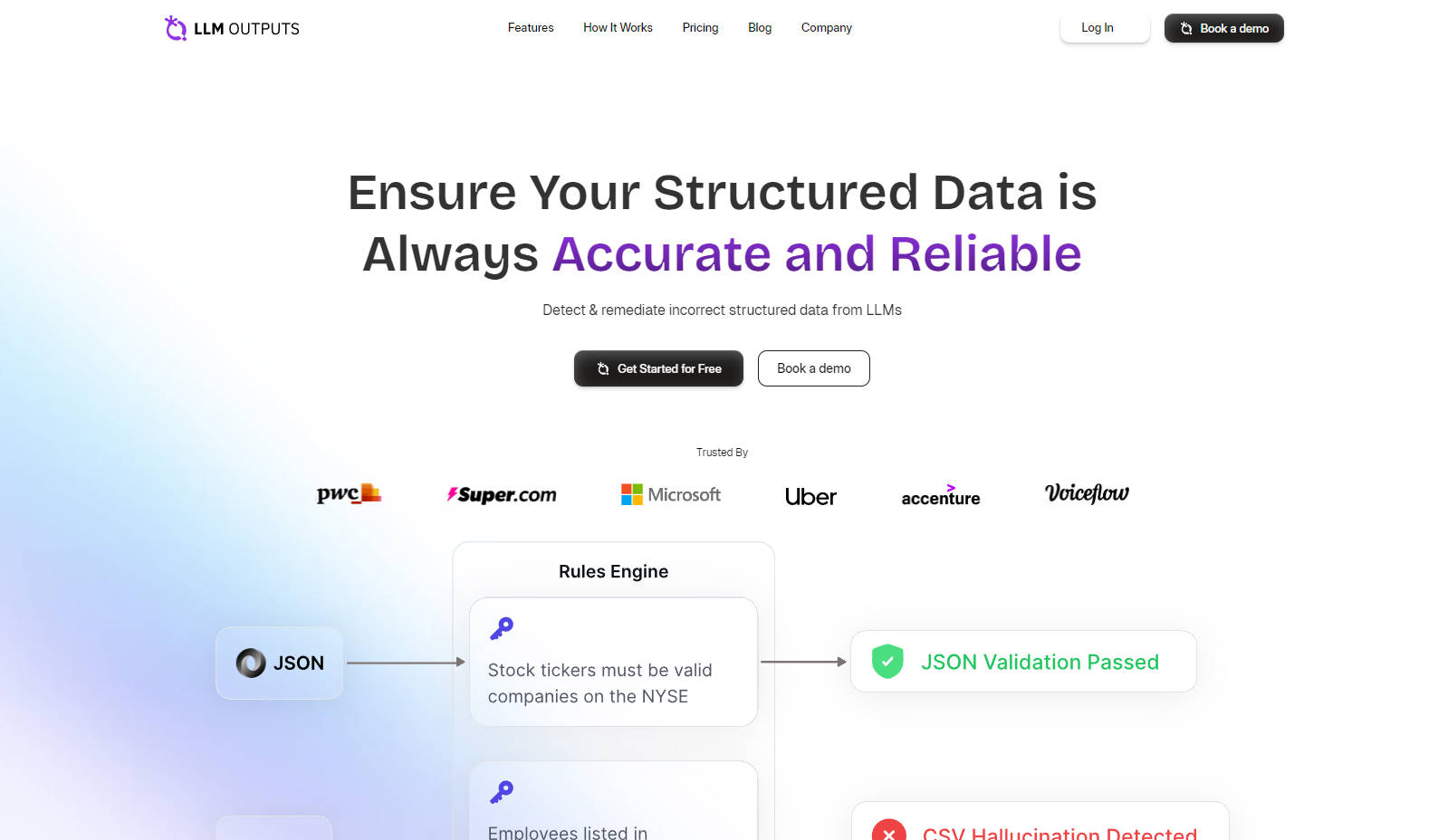

What is LLM Outputs?

LLM Outputs révolutionne l'intégrité des données structurées générées par l'IA en offrant une surveillance en temps réel et une intégration transparente pour détecter et éliminer les hallucinations. Cela garantit que les données sur lesquelles vous vous appuyez sont non seulement précises et fiables, mais également pertinentes dans leur contexte. En prévenant les erreurs et les fabrications, LLM Outputs améliore l'efficacité opérationnelle et la fiabilité des données, ce qui en fait un outil indispensable pour toute organisation utilisant des modèles de langage de grande taille.

Fonctionnalités clés :

Conformité du format : Garantit que les données structurées respectent les formats spécifiés tels que JSON, CSV ou XML, à chaque fois, éliminant ainsi les erreurs de format.

Détection des hallucinations : Utilise des modèles d'IA avancés pour identifier et rectifier les hallucinations de données, préservant ainsi l'intégrité de vos données structurées.

Précision contextuelle : Maintient la pertinence et la précision des données pour l'utilisation prévue en les alignant sur le bon contexte.

Intégration transparente : Fournit des extraits de code faciles à injecter pour une intégration rapide dans les systèmes existants, avec une approche conviviale pour les développeurs.

Surveillance en temps réel : Offre des API à faible latence pour la détection et la correction immédiates des divergences dans les données structurées.

Cas d'utilisation :

Intégrité des données IA : Garantit que les données utilisées pour former les modèles d'IA sont exactes, ce qui conduit à des performances et une fiabilité améliorées.

Validation des données financières : Protège contre les données financières erronées qui pourraient entraîner des erreurs coûteuses ou des problèmes de conformité.

Canalisations de données d'entreprise : Rationalise les flux de travail des données dans les grandes organisations en validant les données structurées en temps réel.

Conclusion :

LLM Outputs est la référence pour le maintien de la précision des données structurées, offrant aux organisations une solution innovante qui s'intègre facilement aux flux de travail existants. Grâce au pouvoir de la validation en temps réel, vous pouvez faire confiance à vos données comme jamais auparavant. Prêt à améliorer la précision de vos données ? Essayez LLM Outputs gratuitement dès aujourd'hui et transformez la façon dont vous gérez vos données structurées.

FAQ :

Q : Qu'est-ce que l'hallucination dans les données structurées et pourquoi est-il important de la détecter ?

A :L'hallucination dans les données structurées fait référence à l'introduction d'inexactitudes ou de fabrications par les modèles d'IA. Détecter ces problèmes est crucial car ils peuvent compromettre la fiabilité des données et entraîner une prise de décision erronée. LLM Outputs est spécialisé dans l'identification de ces problèmes afin de maintenir l'intégrité des données.

Q : Comment LLM Outputs s'intègre-t-il aux systèmes existants ?

A :LLM Outputs s'intègre de manière transparente à vos systèmes actuels en fournissant des extraits de code que vous pouvez injecter dans votre flux de travail. Il fonctionne en parallèle de vos outils pour valider les données structurées, assurant ainsi la précision sans perturber vos opérations.

Q : Qu'est-ce qui rend les modèles de détection d'hallucination de LLM Outputs supérieurs ?

A :LLM Outputs utilise une technologie d'IA de pointe qui est affinée pour détecter et éliminer les hallucinations dans les données structurées. Ses modèles sont inégalés pour garantir une précision et une fiabilité constantes, établissant une nouvelle norme pour la validation des données dans le contenu généré par l'IA.

More information on LLM Outputs

LLM Outputs Alternatives

Plus Alternatives-

Deepchecks : La plateforme de bout en bout pour l'évaluation des LLM. Testez, comparez et supervisez systématiquement vos applications IA, du développement à la production. Réduisez les hallucinations et accélérez vos déploiements.

-

Les entreprises de toutes tailles utilisent Confident AI pour justifier la mise en production de leur LLM.

-

-

-