What is Confident AI?

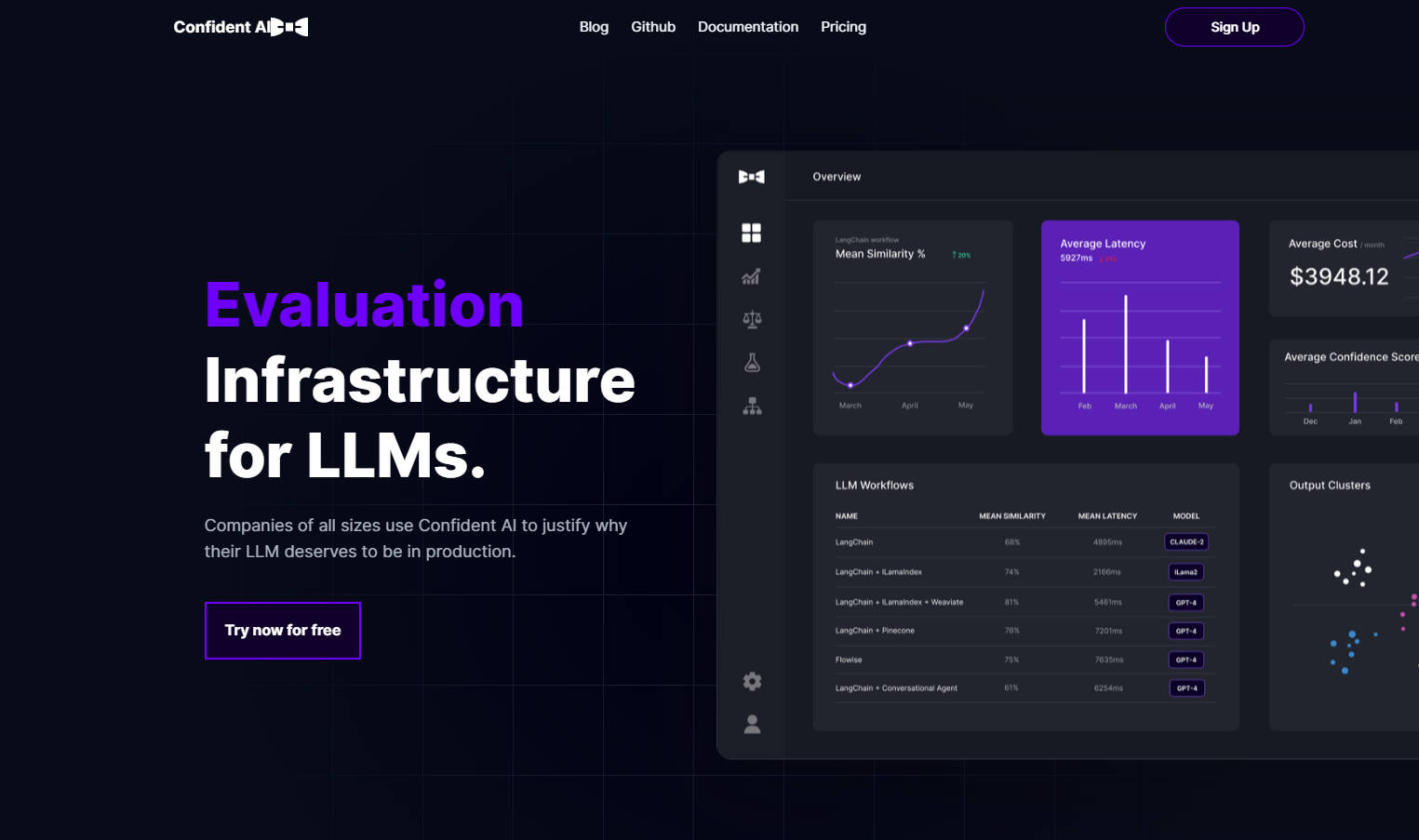

Confident AI 是一款开放源码评估基础设施,用于语言模型模型 (LLM)。它提供了一个集中式平台,用于自信地评估和部署 LLM 解决方案。该软件提供高级功能,如定义基本事实、全面分析以及用于将 LLM 生产化的强大工具。借助 Confident AI,用户可以针对预期基准评估其 LLM 输出,通过详细监控找出改进领域,并使用 A/B 测试和输出分类优化其工作流程。

主要特点:

1. 定义基本事实:Confident AI 允许用户将基本事实定义为基准,以评估其 LLM 输出的性能。通过将实际输出与预期输出进行比较,用户可以精确定位需要迭代和改进的领域。

2. 全面分析:该软件提供开箱即用的可观察性,使用户能够识别和评估为其企业带来最大投资回报率 (ROI) 的用例。用户可以利用详细的分析来随着时间的推移降低成本并减少延迟。

3. 用于将 LLM 生产化的强大工具:Confident AI 提供了多个强大功能,以帮助用户自信地在生产环境中部署 LLM 解决方案。这些功能包括:通过评估指标将不同的工作流进行比较并将其与基本事实进行量化和基准测试的 A/B 测试、发现用于优化目的的重复查询和响应、用于洞察成本降低机会的报告仪表板、用于评估目的的自动数据集生成以及识别工作流瓶颈的详细监控功能。

用例:

- 评估迭代:通过跟踪提示模板之间的差异或选择合适的知识库,Confident AI 使用户能够迭代到最优配置。

- 最大化投资回报率:通过利用 A/B 测试功能以及 Confident AI 报告仪表板提供的全面分析,企业可以通过识别性能最高的 LLM 工作流来最大化投资回报率。

- 性能基准测试:用户可以使用 Confident AI 提供的各种评估指标针对预期基本事实量化其 LLM 模型的性能。

- 工作流优化:该软件帮助用户通过详细监控识别 LLM 工作流中的瓶颈,从而有针对性地进行迭代和改进。

Confident AI 是一款用户友好的开放源码评估基础设施,使用户能够自信地部署和优化其 LLM 解决方案。凭借其全面的分析、强大的生产化工具以及定义基本事实的能力,Confident AI 可确保在解决 LLM 实施中的任何弱点时带来实质性好处。无论是要针对预期输出评估性能,还是找出需要重点优化的地方,Confident AI 都提供必要的特性来增强语言模型的有效性。立即开始使用 Confident AI,释放 LLM 应用程序的全部潜力。