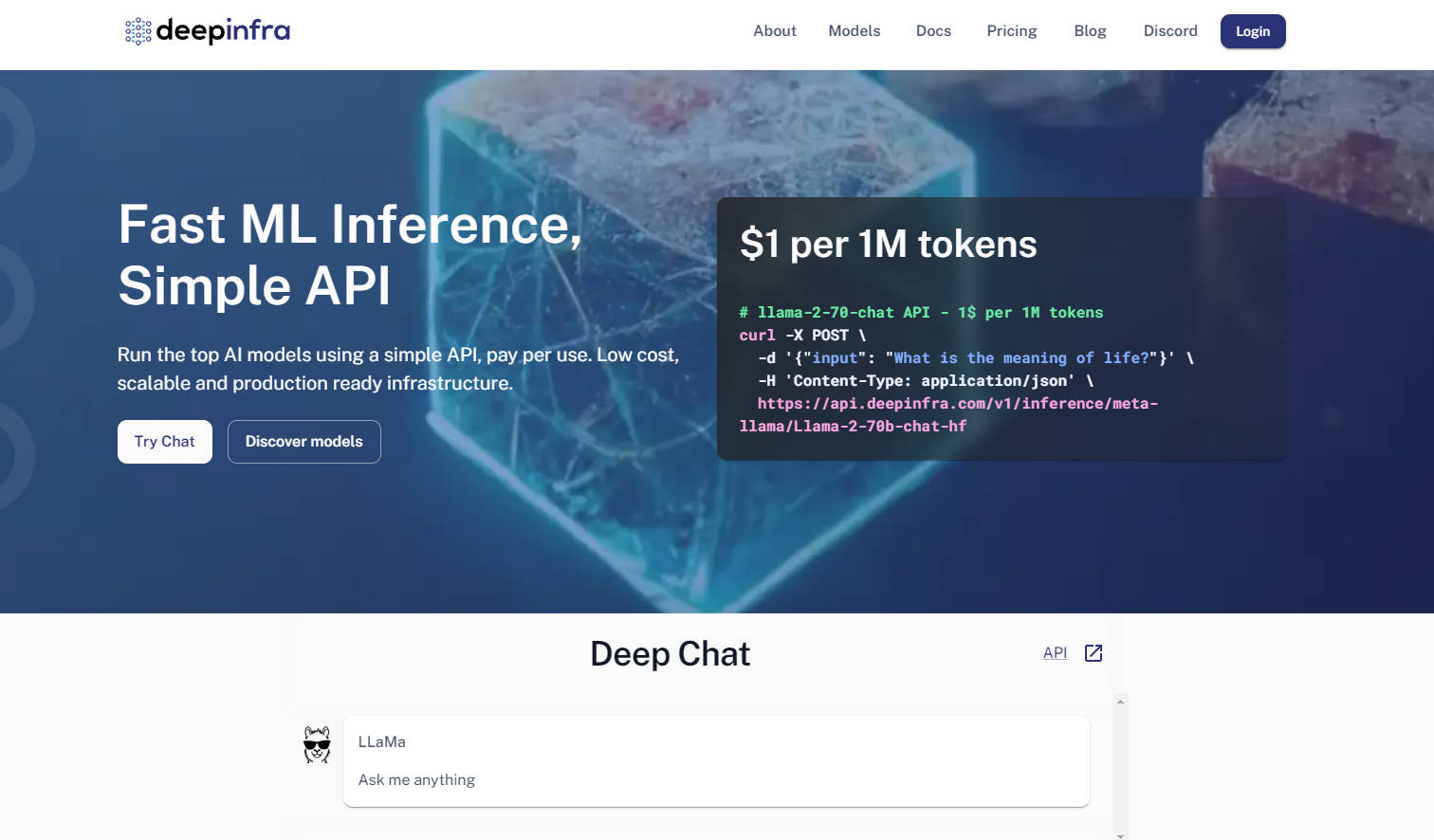

What is DeepInfra?

Los desarrolladores que trabajan con modelos de lenguaje grandes (LLM) a menudo se enfrentan a un doble desafío: desplegar modelos de manera eficiente en producción y mantener la flexibilidad dentro del dinámico ecosistema de código abierto. DeepInfra ofrece una infraestructura de nube de inferencia dedicada, diseñada para resolver estos problemas, convirtiéndola en tu plataforma de referencia para el despliegue de modelos de IA de código abierto listos para producción.

Características Principales

Compatibilidad con la API de OpenAI y API Multimodal: Aprovecha las API familiares compatibles con OpenAI (REST, Python, JS SDKs) para tareas de texto, imagen, embedding (incrustación) y voz. Esto permite una migración e integración sin esfuerzo, minimizando los cambios en el código si ya utilizas el ecosistema de OpenAI.

Catálogo de Modelos Amplio y Personalizable: Accede a un extenso catálogo de modelos de código abierto populares como Qwen, Mistral, Llama y DeepSeek, constantemente actualizado con las últimas versiones. También puedes subir tus modelos personalizados o versiones LoRA ajustadas, otorgándote un control y una flexibilidad sin igual.

Infraestructura Optimizada en Costos y Autoescalable: Benefíciate de costos de inferencia significativamente más bajos, especialmente para servicios de embedding (incrustación) y escenarios de alto rendimiento (throughput), en comparación con muchas alternativas. El autoescalado integrado y las instancias de GPU sin servidor de DeepInfra garantizan que solo pagues por el cómputo que utilizas, eliminando el desperdicio por inactividad.

Instancias de GPU Dedicadas para Cargas de Trabajo Avanzadas: Obtén acceso exclusivo a instancias de GPU dedicadas dentro de contenedores, adecuadas tanto para inferencia de alto rendimiento como para entrenamiento a pequeña escala. Esto proporciona un mayor control y potencia para necesidades complejas de investigación y desarrollo que van más allá de las llamadas API estándar.

Casos de Uso

Potenciando Agentes de IA Avanzados: Despliega modelos de código abierto de vanguardia para tus agentes de IA o sistemas de Generación Aumentada por Recuperación (RAG), aprovechando servicios de embedding de alto rendimiento y una inferencia de bajo costo para procesar grandes volúmenes de datos de manera eficiente.

Despliegue de Modelos Personalizados para Tareas Especializadas: Aloja fácilmente tus modelos propietarios ajustados (por ejemplo, adaptaciones LoRA) en una plataforma segura y escalable. Esto permite a las empresas desplegar soluciones de IA específicas de dominio sin la sobrecarga de gestionar una infraestructura de GPU compleja.

Prototipado Rápido y Aplicaciones de IA Escalables: Prueba y escala rápidamente nuevas aplicaciones de IA utilizando una amplia selección de modelos de código abierto populares. La API flexible y las capacidades de autoescalado de DeepInfra aceleran tu ciclo de desarrollo desde el concepto hasta la producción.

¿Por qué elegir DeepInfra?

DeepInfra se distingue por centrarse en las necesidades críticas de la comunidad de IA de código abierto y los entornos de producción:

Eficiencia de Costos: DeepInfra se distingue por su estrategia de precios competitiva, ofreciendo costos de inferencia significativamente más bajos, particularmente para tareas de embedding y despliegues a gran escala. Esto puede traducirse en ahorros sustanciales, haciendo que la IA avanzada sea accesible para más desarrolladores y empresas.

Flexibilidad de Modelos Inigualable: A diferencia de muchos proveedores de nube, DeepInfra prioriza el ecosistema de código abierto, proporcionando acceso rápido a los modelos más recientes como DeepSeek-V3.1 y Qwen 2.5. También obtienes la capacidad única de desplegar endpoints privados con pesos personalizados o versiones LoRA ajustadas, ofreciendo una adaptabilidad sin igual.

Optimización Orientada a Producción: Desarrollado por un equipo con profunda experiencia en sistemas de baja latencia y gran escala, el stack de optimización de inferencia de DeepInfra (TensorRT-LLM, Triton, cuantificación FP8/INT8) garantiza que tus modelos funcionen más rápido y de manera más eficiente en producción. Este enfoque en la optimización a nivel de kernel se traduce en un mayor rendimiento (throughput) y menores costos operativos para ti.

Privacidad de Datos y Cumplimiento Empresarial: DeepInfra enfatiza la privacidad de los datos al no almacenar información de las solicitudes de los usuarios, un aspecto crítico para clientes empresariales que requieren estrictos estándares de cumplimiento y seguridad.

Conclusión

DeepInfra empodera a los desarrolladores para aprovechar todo el potencial de los modelos de IA de código abierto sin las complejidades de despliegue típicas ni los costos prohibitivos. Proporciona la infraestructura robusta, flexible y rentable necesaria para llevar tus innovaciones de IA a producción, impulsando la próxima ola de aplicaciones inteligentes. Explora DeepInfra hoy mismo y transforma tu estrategia de despliegue de IA de código abierto.

More information on DeepInfra

Top 5 Countries

Traffic Sources

DeepInfra Alternativas

Más Alternativas-

-

-

-

-

Genere contenido multimedia de gran calidad mediante una API rápida y asequible. Desde la generación de imágenes en fracciones de segundo hasta la inferencia de vídeo avanzada, todo ello impulsado por hardware personalizado y energía renovable. Sin necesidad de infraestructura ni conocimientos en ML.