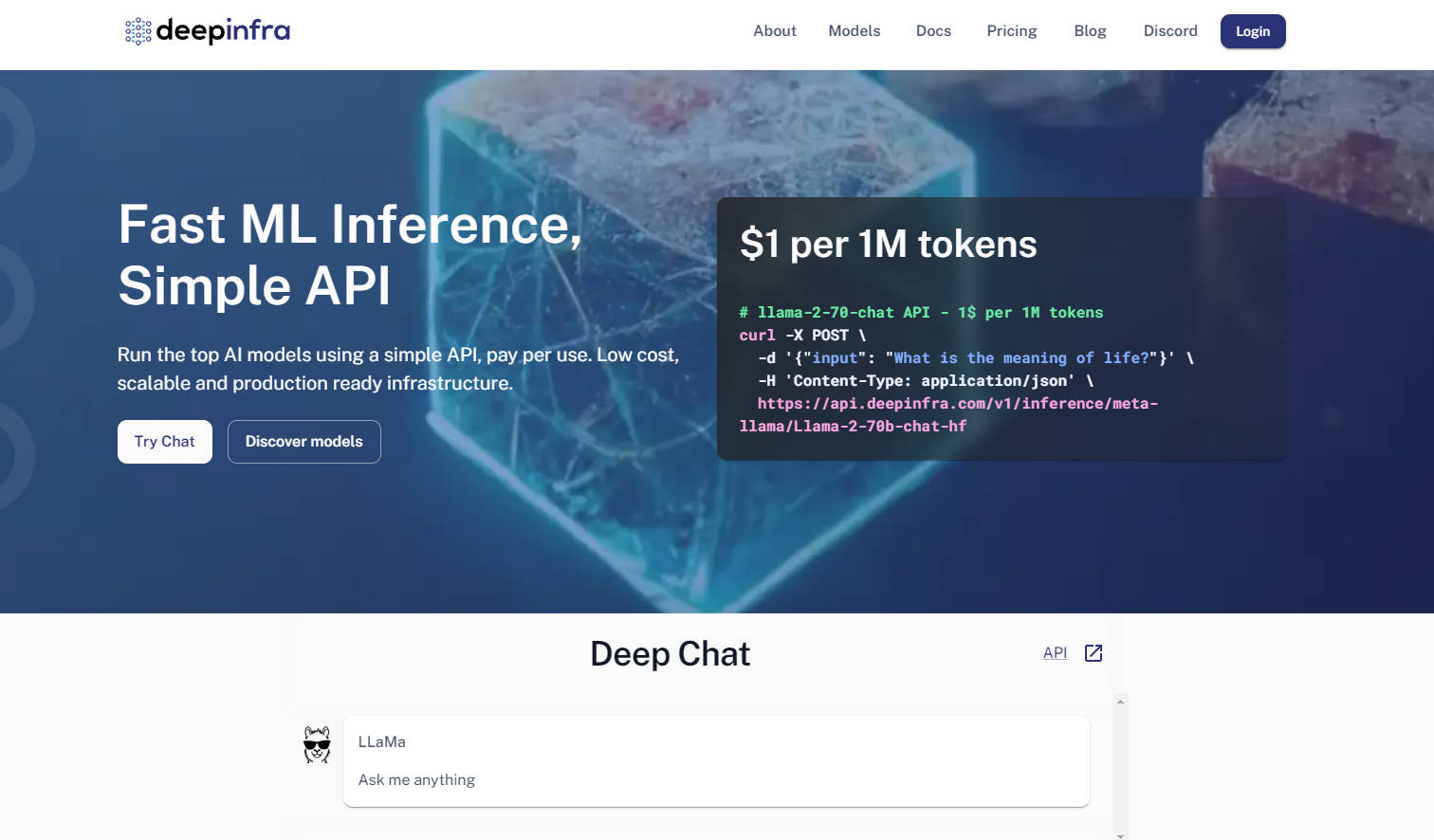

What is DeepInfra?

大規模言語モデル (LLM) を利用して開発を行うデベロッパーは、本番環境へのモデルの効率的なデプロイと、急速に進化するオープンソースエコシステム内での柔軟性の維持という、二重の課題に直面しがちです。DeepInfraは、これらの課題を解決するために設計された専用の推論クラウドインフラを提供し、本番環境対応のオープンソースAIモデルデプロイメントの頼れるプラットフォームとなります。

主な特徴

OpenAI API互換性 & マルチモーダルAPI: テキスト、画像、エンベディング、音声タスク向けに、使い慣れたOpenAI互換API(REST、Python、JS SDKs)を活用できます。これにより、OpenAIのエコシステムをすでに利用している場合でも、コード変更を最小限に抑え、容易な移行と統合が可能になります。

広範でカスタマイズ可能なモデルカタログ: Qwen、Mistral、Llama、DeepSeekなどの人気のあるオープンソースモデルの豊富なカタログにアクセスでき、常に最新リリースで更新されています。また、独自のカスタムモデルやLoRAでファインチューニングされたバージョンをアップロードすることも可能で、比類のない制御と柔軟性を提供します。

コスト最適化されたオートスケーラブルなインフラ: 多くの代替案と比較して、特にエンベディングサービスや高スループットのシナリオにおいて、推論コストを大幅に削減できます。DeepInfraに組み込まれたオートスケーリングとサーバーレスGPUインスタンスにより、利用したコンピューティングリソースに対してのみ料金が発生し、アイドル時の無駄をなくします。

高度なワークロード向け専用GPUインスタンス: コンテナ内で専用GPUインスタンスへの排他的アクセスが可能で、高性能な推論と小規模なトレーニングの両方に適しています。これにより、標準的なAPI呼び出しを超えた複雑な研究開発ニーズに対して、より優れた制御と能力を提供します。

ユースケース

高度なAIエージェントの動力源に: 高スループットのエンベディングサービスと低コストの推論を活用し、膨大なデータを効率的に処理することで、AIエージェントやRetrieval-Augmented Generation (RAG) システム向けに最先端のオープンソースモデルをデプロイできます。

特殊タスク向けカスタムモデルのデプロイ: 独自のファインチューニングモデル(例:LoRAアダプテーション)を、セキュアでスケーラブルなプラットフォーム上で簡単にホストできます。これにより、企業は複雑なGPUインフラ管理のオーバーヘッドなしに、ドメイン固有のAIソリューションを展開できます。

迅速なプロトタイプ作成とスケーラブルなAIアプリ: 幅広い人気のオープンソースモデルを利用して、新しいAIアプリケーションを迅速にテストし、スケールさせることができます。DeepInfraの柔軟なAPIとオートスケーリング機能は、コンセプトから本番環境までの開発サイクルを加速させます。

DeepInfraを選ぶ理由

DeepInfraは、オープンソースAIコミュニティと本番環境の重要なニーズに焦点を当てることで、他との差別化を図っています。

費用対効果: DeepInfraは、特にエンベディングタスクや大規模デプロイメントにおいて、推論コストを大幅に削減する積極的な価格設定が特徴です。これにより、大幅なコスト削減が実現し、より多くの開発者や企業にとって高度なAIが身近なものとなります。

比類ないモデルの柔軟性: 多くのクラウドプロバイダーとは異なり、DeepInfraはオープンソースエコシステムを優先し、DeepSeek-V3.1やQwen 2.5のような最新モデルへの迅速なアクセスを提供します。さらに、カスタムウェイトやLoRAでファインチューニングされたバージョンを持つプライベートエンドポイントをデプロイする独自の機能も備えており、比類ない適応性を提供します。

本番環境に最適化されたパフォーマンス: 低レイテンシーかつ大規模システムに深い経験を持つチームによって構築されたDeepInfraの推論最適化スタック(TensorRT-LLM、Triton、FP8/INT8量子化)は、本番環境でモデルがより高速かつ効率的に動作することを保証します。このカーネルレベルの最適化への注力は、より高いスループットと運用コストの削減を意味します。

データプライバシーと企業コンプライアンス: DeepInfraは、ユーザーリクエストデータを保存しないことでデータプライバシーを重視しています。これは、厳格なコンプライアンスとセキュリティ基準を求める企業クライアントにとって極めて重要な側面です。

結論

DeepInfraは、開発者がオープンソースAIモデルの可能性を最大限に引き出すことを可能にし、従来のデプロイの複雑さや法外なコストを解消します。AIイノベーションを本番環境に導入し、次世代のインテリジェントアプリケーションを推進するために必要な、堅牢で柔軟かつコスト効率の高いインフラストラクチャを提供します。今すぐDeepInfraを探索し、オープンソースAIのデプロイ戦略を変革しましょう。