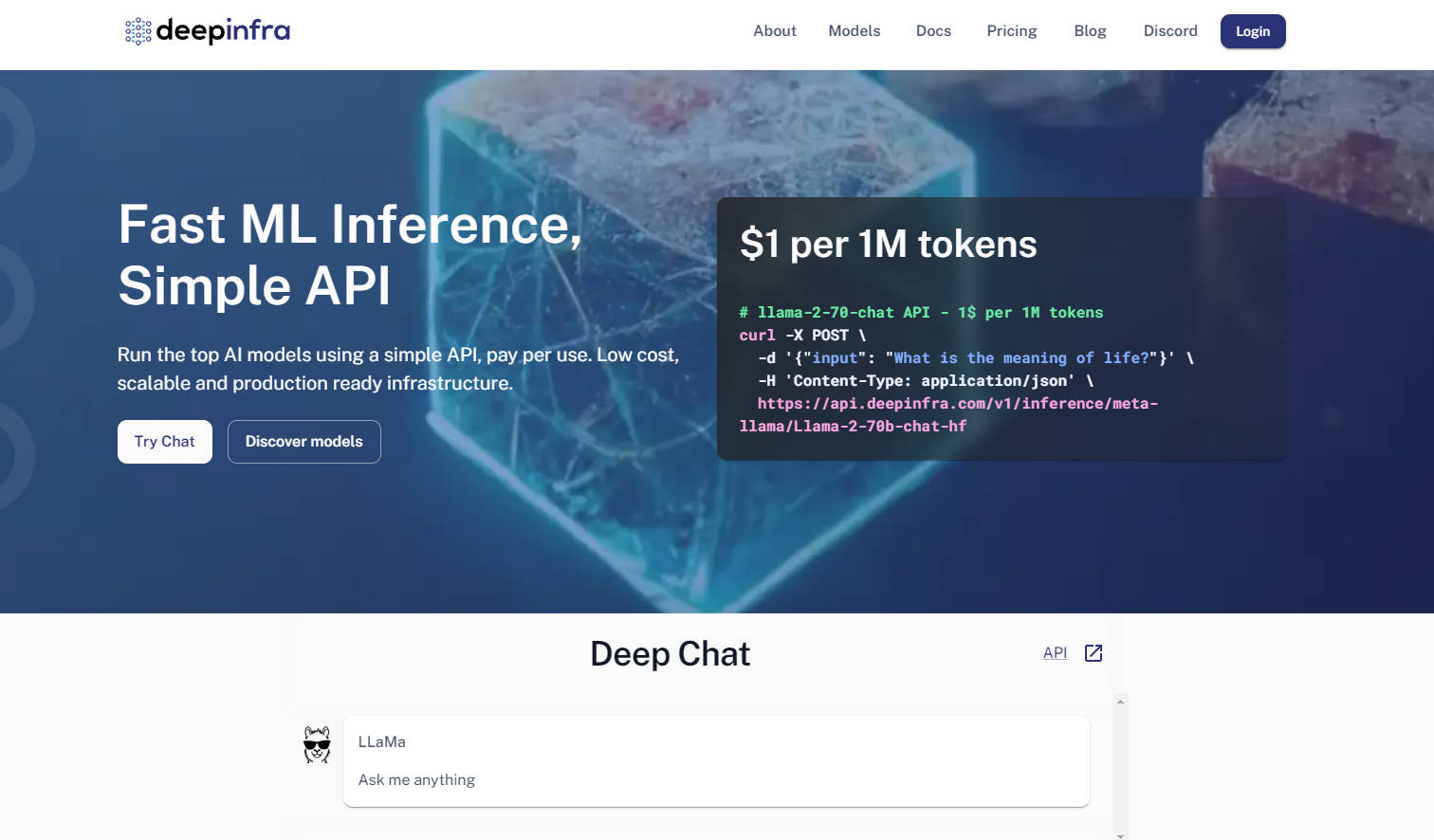

What is DeepInfra?

Les développeurs qui travaillent avec des grands modèles linguistiques (LLM) sont souvent confrontés à un double défi : celui de déployer efficacement des modèles en production tout en conservant une flexibilité essentielle au sein de l'écosystème open source en constante évolution. DeepInfra propose une infrastructure cloud d'inférence dédiée, conçue pour relever ces défis, ce qui en fait votre plateforme de référence pour le déploiement de modèles d'IA open source prêts pour la production.

Fonctionnalités Clés

Compatibilité API OpenAI & API Multimodale : Tirez parti d'APIs familières compatibles avec OpenAI (SDKs REST, Python, JS) pour les tâches de traitement de texte, d'image, d'embedding et de synthèse vocale. Cela permet une migration et une intégration aisées, minimisant les modifications de code si vous utilisez déjà l'écosystème d'OpenAI.

Catalogue de Modèles Étendu & Personnalisable : Accédez à un vaste catalogue de modèles open source populaires tels que Qwen, Mistral, Llama et DeepSeek, constamment mis à jour avec les dernières versions. Vous pouvez également téléverser vos modèles personnalisés ou vos versions affinées (fine-tuned) avec LoRA, vous offrant un contrôle et une flexibilité inégalés.

Infrastructure Optimisée en Coût & Auto-Scalable : Bénéficiez de coûts d'inférence considérablement réduits, en particulier pour les services d'embedding et les scénarios à haut débit, par rapport à de nombreuses alternatives. L'auto-scaling intégré de DeepInfra et ses instances GPU serverless garantissent que vous ne payez que pour la puissance de calcul que vous utilisez, éliminant ainsi le gaspillage des ressources inactives.

Instances GPU Dédiées pour les Charges de Travail Avancées : Obtenez un accès exclusif à des instances GPU dédiées au sein de conteneurs, adaptées à l'inférence haute performance et à l'entraînement à petite échelle. Cela offre un contrôle et une puissance accrus pour les besoins complexes de recherche et développement, au-delà des appels d'API standards.

Cas d'Utilisation

Alimenter des Agents d'IA Avancés : Déployez des modèles open source de pointe pour vos agents d'IA ou vos systèmes de génération augmentée par récupération (RAG), en tirant parti de services d'embedding à haut débit et d'une inférence à faible coût pour traiter efficacement de vastes quantités de données.

Déploiement de Modèles Personnalisés pour des Tâches Spécialisées : Hébergez facilement vos modèles propriétaires affinés (par exemple, les adaptations LoRA) sur une plateforme sécurisée et évolutive. Cela permet aux entreprises de déployer des solutions d'IA spécifiques à leur domaine sans les contraintes de gestion d'une infrastructure GPU complexe.

Prototypage Rapide et Applications d'IA Scalables : Testez et adaptez rapidement de nouvelles applications d'IA en utilisant une vaste sélection de modèles open source populaires. L'API flexible et les capacités d'auto-scaling de DeepInfra accélèrent votre cycle de développement, du concept à la production.

Pourquoi Choisir DeepInfra ?

DeepInfra se distingue en se concentrant sur les besoins cruciaux de la communauté de l'IA open source et des environnements de production :

Rentabilité : DeepInfra se distingue par sa tarification agressive, offrant des coûts d'inférence considérablement réduits, en particulier pour les tâches d'embedding et les déploiements à grande échelle. Cela peut se traduire par des économies substantielles, rendant l'IA avancée accessible à davantage de développeurs et d'entreprises.

Flexibilité de Modèles Inégalée : Contrairement à de nombreux fournisseurs de cloud, DeepInfra privilégie l'écosystème open source, offrant un accès rapide aux derniers modèles tels que DeepSeek-V3.1 et Qwen 2.5. Vous bénéficiez également de la capacité unique de déployer des endpoints privés avec des poids personnalisés ou des versions affinées avec LoRA, offrant une adaptabilité inégalée.

Optimisation Orientée Production : Conçu par une équipe possédant une profonde expérience des systèmes à faible latence et à grande échelle, la pile d'optimisation d'inférence de DeepInfra (TensorRT-LLM, Triton, quantification FP8/INT8) garantit que vos modèles fonctionnent plus rapidement et plus efficacement en production. Cette approche axée sur l'optimisation au niveau du noyau se traduit par un débit plus élevé et des coûts opérationnels réduits pour vous.

Confidentialité des Données et Conformité d'Entreprise : DeepInfra met l'accent sur la confidentialité des données en ne stockant pas les données de requêtes des utilisateurs, un aspect essentiel pour les clients d'entreprise qui exigent des normes de conformité et de sécurité strictes.

Conclusion

DeepInfra permet aux développeurs d'exploiter pleinement le potentiel des modèles d'IA open source sans les complexités de déploiement habituelles ni les coûts prohibitifs. Elle offre l'infrastructure robuste, flexible et rentable nécessaire pour mettre en production vos innovations en IA, propulsant ainsi la prochaine vague d'applications intelligentes. Explorez DeepInfra dès aujourd'hui et transformez votre stratégie de déploiement d'IA open source.

More information on DeepInfra

Top 5 Countries

Traffic Sources

DeepInfra Alternatives

Plus Alternatives-

-

-

-

-

Générez des contenus multimédias de haute qualité grâce à une API rapide et économique. De la génération d'images ultra-rapide (en moins d'une seconde) à l'inférence vidéo avancée, le tout propulsé par du matériel sur mesure et des énergies renouvelables. Aucune infrastructure ni expertise en ML n'est requise.