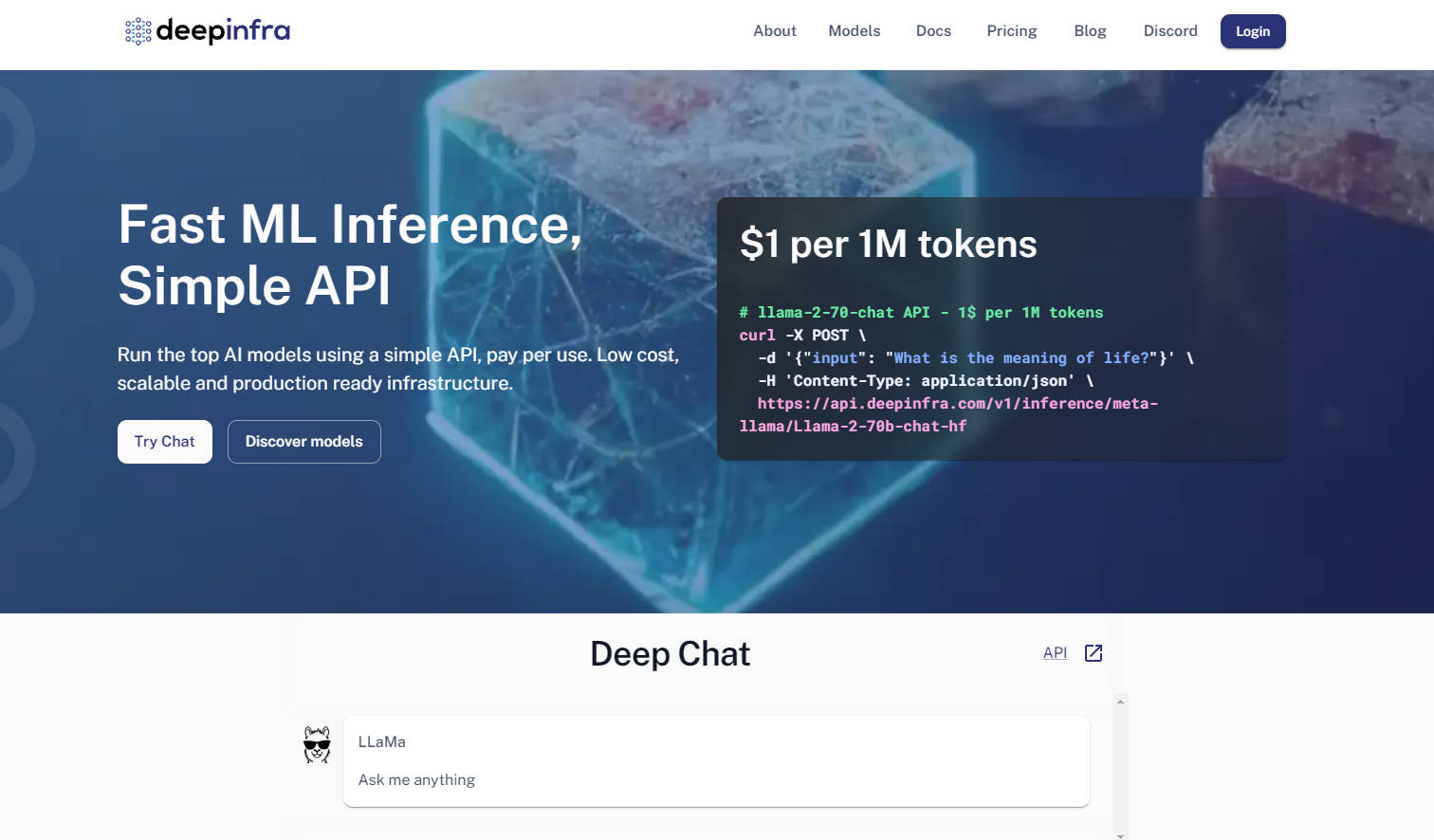

What is DeepInfra?

使用大型語言模型(LLM)的開發人員,常面臨兩大挑戰:如何高效地將模型部署到實際生產環境,以及如何在快速發展的開源生態系統中保持靈活性。DeepInfra 提供專為此設計的推論雲端基礎設施,旨在解決這些難題,使其成為您部署生產級開源 AI 模型時的首選平台。

主要特色

OpenAI API 相容性與多模態 API: 善用熟悉的 OpenAI 相容 API(支援 REST、Python、JS 開發套件),處理文字、圖像、嵌入與語音等多樣任務。如果您已採用 OpenAI 的生態系統,這將大幅簡化遷移與整合流程,最大程度地減少程式碼修改。

豐富且可自訂的模型目錄: 存取豐富多元的熱門開源模型目錄,例如 Qwen、Mistral、Llama 和 DeepSeek,並持續更新至最新版本。您還能上傳自己的客製化模型或 LoRA 微調版本,享有無與倫比的掌控度與彈性。

成本最佳化與自動擴展基礎設施: 相較於市面上許多替代方案,您將享有顯著降低的推論成本,尤其在嵌入服務和高吞吐量情境下效益更為明顯。DeepInfra 內建的自動擴展功能與無伺服器 GPU 執行個體,確保您僅需支付實際使用的運算資源費用,徹底杜絕資源閒置的浪費。

適用於進階工作負載的專用 GPU 執行個體: 獨家存取容器內的專用 GPU 執行個體,完美適用於高效能推論與小型訓練任務。這將賦予您更強大的控制能力與運算效能,以滿足超越標準 API 呼叫的複雜研究與開發需求。

應用情境

驅動進階 AI 代理: 為您的 AI 代理或檢索增強生成(RAG)系統部署尖端開源模型,並透過高吞吐量的嵌入服務和低成本推論,高效處理龐大數據量。

針對特定任務的客製化模型部署: 在安全且可擴展的平台上,輕鬆託管您的專有微調模型(例如 LoRA 適配版本)。這使得企業能夠部署特定領域的 AI 解決方案,同時避免管理複雜 GPU 基礎設施所帶來的額外負擔。

快速原型開發與可擴展 AI 應用: 利用多樣化的熱門開源模型,迅速測試並擴展全新的 AI 應用程式。DeepInfra 靈活的 API 與自動擴展能力,能大幅加速您的開發週期,從概念發想到實際生產部署。

為何選擇 DeepInfra?

DeepInfra 獨樹一幟,專注於滿足開源 AI 社群與實際生產環境的關鍵需求:

成本效益: DeepInfra 以其極具競爭力的定價脫穎而出,提供顯著更低的推論成本,尤其在嵌入任務和大規模部署方面更是如此。這意味著可為您帶來可觀的成本節省,讓更多開發人員與企業得以運用先進的 AI 技術。

無與倫比的模型彈性: 與眾多雲端供應商不同,DeepInfra 優先支持開源生態系統,確保您能快速存取 DeepSeek-V3.1 和 Qwen 2.5 等最新模型。此外,您還能獨家部署帶有客製化權重或 LoRA 微調版本的私有端點,提供卓越的適應能力。

生產導向的最佳化: DeepInfra 由一群在低延遲、大規模系統方面擁有深厚經驗的團隊所打造,其推論最佳化堆疊(包含 TensorRT-LLM、Triton、FP8/INT8 量化)能確保您的模型在生產環境中運行得更快、更有效率。這種對核心層最佳化的專注,將為您帶來更高的吞吐量與更低的營運成本。

資料隱私與企業合規性: DeepInfra 致力於保護資料隱私,不儲存任何使用者請求數據。對於要求嚴格合規與高安全標準的企業客戶而言,這是一個至關重要的考量。

結論

DeepInfra 賦予開發人員充分發揮開源 AI 模型潛力的能力,同時免除傳統部署的複雜性與高昂成本。它提供穩健、靈活且具成本效益的基礎設施,助您將 AI 創新成功導入生產環境,進而引領下一波智慧應用浪潮。立即探索 DeepInfra,革新您的開源 AI 部署策略!