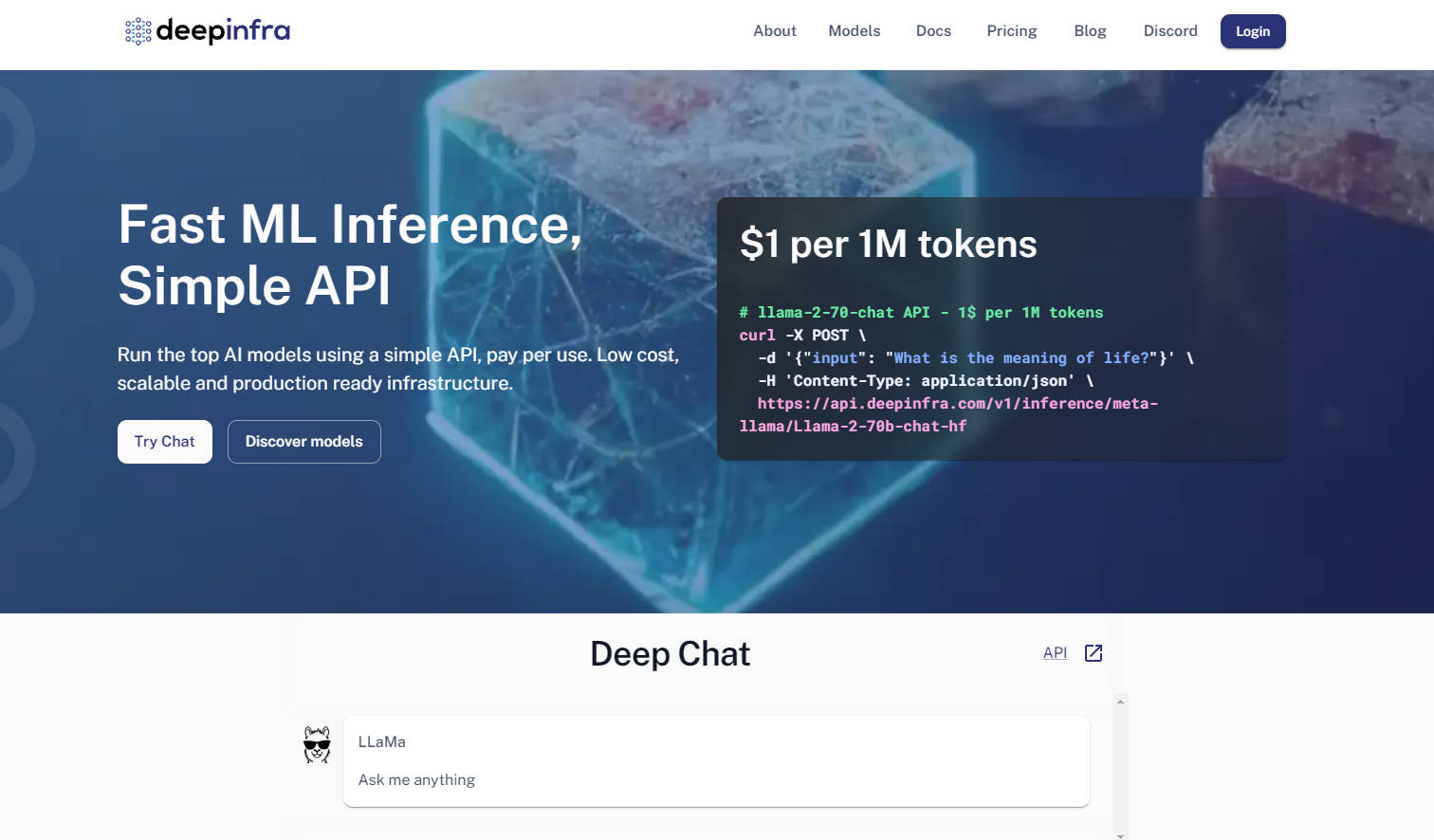

What is DeepInfra?

使用大型语言模型的开发者常面临两大挑战:如何在生产环境中高效部署模型,以及如何在快速迭代的开源生态系统中保持灵活性。DeepInfra 提供专为解决这些问题而设计的专用推理云基础设施,使其成为您部署生产级开源AI模型的首选平台。

主要特点

OpenAI API 兼容性&多模态 API: 利用熟悉的 OpenAI 兼容 API(支持 REST、Python、JS SDK),轻松处理文本、图像、嵌入和语音任务。如果您已在使用 OpenAI 生态系统,这能实现无缝迁移与集成,最大程度减少代码改动。

丰富的可定制模型目录: 访问包含 Qwen、Mistral、Llama 和 DeepSeek 等热门开源模型的丰富目录,并持续更新最新版本。您还可以上传自定义模型或 LoRA 微调版本,获得无与伦比的控制力与灵活性。

成本优化&自动伸缩基础设施: 相较于众多替代方案,DeepInfra 可显著降低推理成本,尤其在嵌入服务和高吞吐量场景下优势明显。其内置的自动伸缩和无服务器 GPU 实例确保您仅为实际使用的计算资源付费,杜绝闲置浪费。

高级工作负载专用 GPU 实例: 独家访问容器内的专用 GPU 实例,适用于高性能推理和小规模训练。这为超出标准 API 调用范围的复杂研发需求,提供了更强的控制力和算力。

应用场景

赋能高级 AI 智能体: 为您的 AI 智能体或检索增强生成 (RAG) 系统部署尖端开源模型,利用高吞吐量嵌入服务和低成本推理,高效处理海量数据。

专业任务的自定义模型部署: 在安全、可扩展的平台上轻松托管您的专有微调模型(例如 LoRA 适配)。这使得企业能够部署领域特定的 AI 解决方案,同时避免管理复杂 GPU 基础设施的额外开销。

快速原型开发与可扩展 AI 应用: 运用丰富的热门开源模型,快速测试和扩展新的 AI 应用。DeepInfra 灵活的 API 和自动伸缩能力,将您的开发周期从概念到生产实现加速。

为何选择 DeepInfra?

DeepInfra 专注于开源 AI 社区和生产环境的关键需求,从而独树一帜:

成本效益: DeepInfra 以其极具竞争力的定价脱颖而出,提供显著更低的推理成本,尤其在嵌入任务和大规模部署方面优势明显。这可为用户带来可观的成本节约,让更多开发者和企业能够轻松触及先进的 AI 技术。

无与伦比的模型灵活性: 与许多云服务提供商不同,DeepInfra 优先支持开源生态系统,提供对 DeepSeek-V3.1 和 Qwen 2.5 等最新模型的快速访问。您还可获得独有的能力,部署带有自定义权重或 LoRA 微调版本的私有端点,提供无与伦比的适应性。

生产级优化: DeepInfra 由一支在低延迟、大规模系统方面拥有深厚经验的团队打造,其推理优化堆栈(包括 TensorRT-LLM、Triton、FP8/INT8 量化)确保您的模型在生产环境中运行更快、更高效。这种对内核级优化的专注,意味着为您带来更高的吞吐量和更低的运营成本。

数据隐私与企业合规: DeepInfra 通过不存储用户请求数据来强调数据隐私,这对于要求严格合规和安全标准的行业客户而言至关重要。

总结

DeepInfra 赋能开发者充分发挥开源 AI 模型的全部潜力,同时避免了典型的部署复杂性和高昂成本。它提供健壮、灵活且经济高效的基础设施,助您将 AI 创新投入生产,推动下一波智能应用的浪潮。立即探索 DeepInfra,革新您的开源 AI 部署策略。