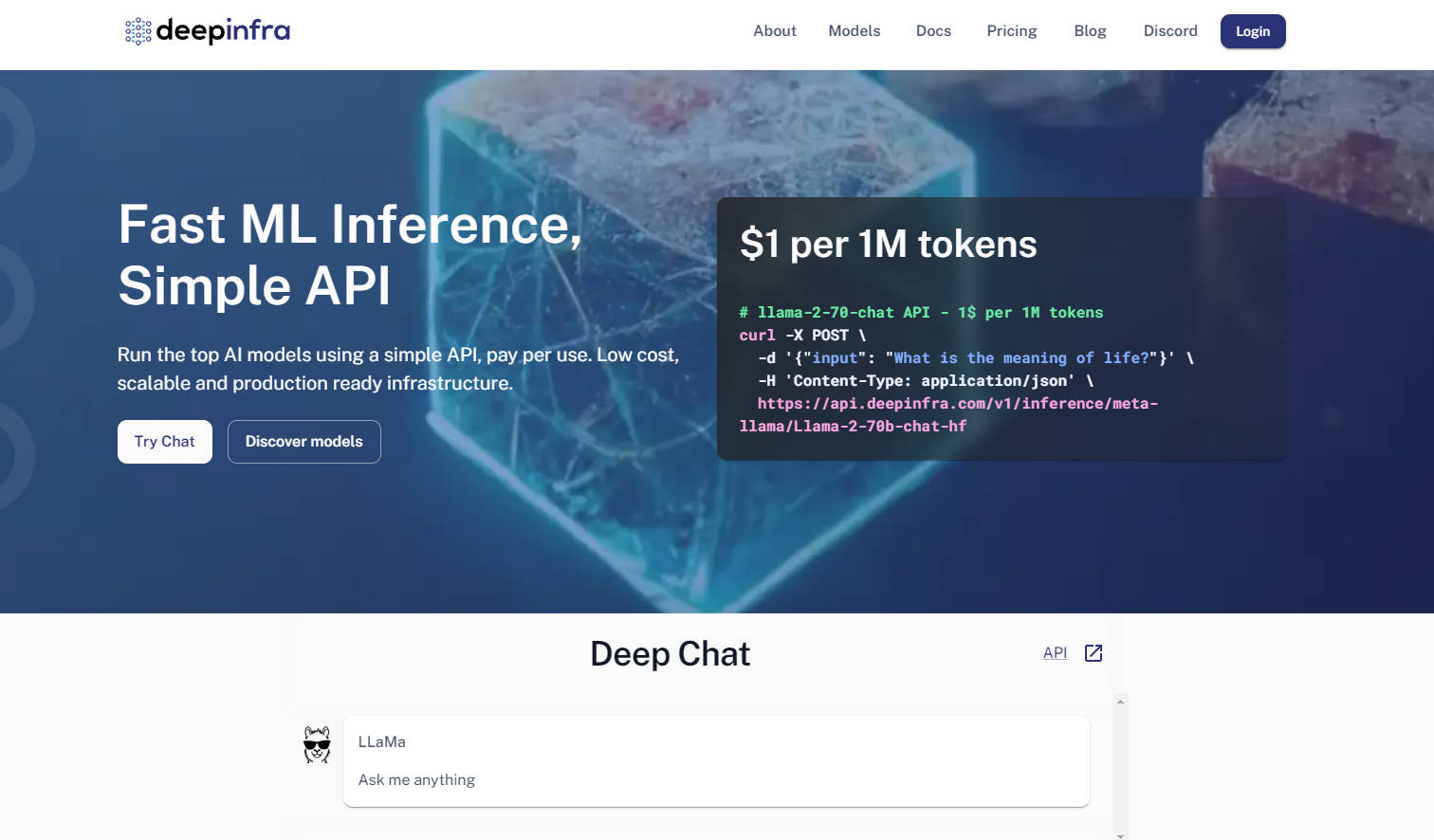

What is DeepInfra?

Разработчики, работающие с большими языковыми моделями, часто сталкиваются с двойной проблемой: эффективное развертывание моделей в продакшене и сохранение гибкости в быстроразвивающейся экосистеме открытого исходного кода. DeepInfra предлагает специализированную облачную инфраструктуру для инференса, разработанную для решения этих проблем, что делает ее вашей основной платформой для развертывания готовых к продакшену моделей ИИ с открытым исходным кодом.

Ключевые особенности

Совместимость с OpenAI API и мультимодальный API: Используйте привычные, совместимые с OpenAI API (REST, Python, JS SDK) для работы с текстом, изображениями, эмбеддингами и речью. Это обеспечивает легкую миграцию и интеграцию, минимизируя изменения кода, если вы уже используете экосистему OpenAI.

Обширный и настраиваемый каталог моделей: Получите доступ к богатому каталогу популярных моделей с открытым исходным кодом, таких как Qwen, Mistral, Llama и DeepSeek, постоянно обновляемому новейшими выпусками. Вы также можете загружать свои собственные модели или версии, дообученные с помощью LoRA, что предоставляет беспрецедентный контроль и гибкость.

Оптимизированная по стоимости и автоматически масштабируемая инфраструктура: Воспользуйтесь значительно более низкими затратами на инференс, особенно для сервисов эмбеддингов и сценариев с высокой пропускной способностью, по сравнению со многими альтернативами. Встроенное автомасштабирование и бессерверные GPU-инстансы DeepInfra гарантируют, что вы платите только за фактически используемые вычислительные ресурсы, исключая ненужные расходы.

Выделенные GPU-инстансы для сложных рабочих нагрузок: Получите эксклюзивный доступ к выделенным GPU-инстансам в контейнерах, подходящим как для высокопроизводительного инференса, так и для мелкомасштабного обучения. Это обеспечивает больший контроль и мощность для сложных научно-исследовательских и опытно-конструкторских задач, выходящих за рамки стандартных вызовов API.

Сценарии использования

Питание передовых ИИ-агентов: Развертывайте передовые модели с открытым исходным кодом для ваших ИИ-агентов или систем генерации с дополненной выборкой (RAG), используя высокопроизводительные сервисы эмбеддингов и недорогой инференс для эффективной обработки огромных объемов данных.

Развертывание пользовательских моделей для специализированных задач: Легко размещайте свои собственные дообученные модели (например, адаптации LoRA) на безопасной, масштабируемой платформе. Это позволяет предприятиям внедрять доменно-специфичные ИИ-решения без дополнительных затрат на управление сложной GPU-инфраструктурой.

Быстрое прототипирование и масштабируемые ИИ-приложения: Быстро тестируйте и масштабируйте новые ИИ-приложения, используя широкий выбор популярных моделей с открытым исходным кодом. Гибкий API DeepInfra и возможности автомасштабирования ускоряют ваш цикл разработки от концепции до продакшена.

Почему стоит выбрать DeepInfra?

DeepInfra выделяется благодаря сосредоточенности на ключевых потребностях сообщества ИИ с открытым исходным кодом и производственных сред:

Экономическая эффективность: DeepInfra отличается агрессивной ценовой политикой, предлагая значительно более низкие затраты на инференс, особенно для задач эмбеддингов и крупномасштабных развертываний. Это может привести к существенной экономии, делая передовой ИИ доступным для большего числа разработчиков и предприятий.

Беспрецедентная гибкость моделей: В отличие от многих облачных провайдеров, DeepInfra отдает приоритет экосистеме открытого исходного кода, предоставляя быстрый доступ к новейшим моделям, таким как DeepSeek-V3.1 и Qwen 2.5. Вы также получаете уникальную возможность развертывать приватные эндпоинты с пользовательскими весами или версиями, дообученными с помощью LoRA, предлагая беспрецедентную адаптивность.

Оптимизация, ориентированная на продакшен: Разработанная командой с обширным опытом работы с низколатентными крупномасштабными системами, стек оптимизации инференса DeepInfra (TensorRT-LLM, Triton, квантование FP8/INT8) гарантирует, что ваши модели будут работать быстрее и эффективнее в продакшене. Этот акцент на оптимизации на уровне ядра означает более высокую пропускную способность и снижение эксплуатационных расходов для вас.

Конфиденциальность данных и соответствие корпоративным требованиям: DeepInfra уделяет особое внимание конфиденциальности данных, не сохраняя данные запросов пользователей, что является критически важным аспектом для корпоративных клиентов, требующих строгих стандартов соответствия и безопасности.

Заключение

DeepInfra дает разработчикам возможность раскрыть весь потенциал моделей ИИ с открытым исходным кодом без типичных сложностей развертывания или непомерных затрат. Она предоставляет надежную, гибкую и экономически эффективную инфраструктуру, необходимую для внедрения ваших инноваций в области ИИ в продакшен, способствуя развитию следующей волны интеллектуальных приложений. Изучите DeepInfra сегодня и преобразите свою стратегию развертывания ИИ с открытым исходным кодом.

More information on DeepInfra

Top 5 Countries

Traffic Sources

DeepInfra Альтернативи

Больше Альтернативи-

-

-

-

-

Создавайте высококачественный медиаконтент через быстрый и доступный API. От молниеносной генерации изображений до продвинутого вывода видео – все это обеспечивается специализированным оборудованием и возобновляемыми источниками энергии. Не требуются ни собственная инфраструктура, ни экспертные знания в области машинного обучения.